Défis liés au placement de tête virtuelle pour le développement de la réalité augmentée

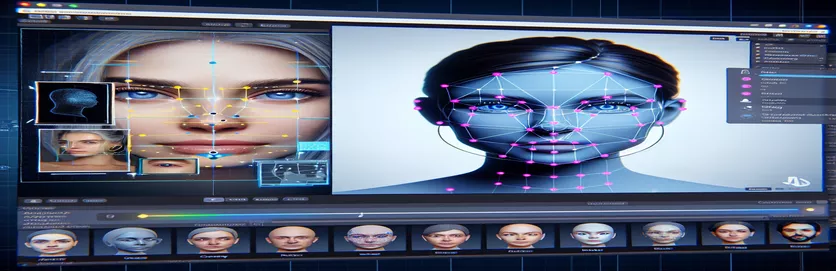

Travailler sur un projet de réalité augmentée (AR) peut être à la fois passionnant et stimulant. Lors du développement d'une application Android avec Unity, mon objectif était de mélanger harmonieusement les mondes numérique et réel en plaçant une tête virtuelle sur des visages réels. Cette fonctionnalité repose fortement sur la précision pour créer une expérience immersive. 🕶️

Pour y parvenir, j'ai utilisé MediaPipe de Google pour détecter des repères faciaux tels que les yeux, le nez et la bouche. La tête virtuelle a ensuite été générée et placée en fonction de ces points clés. Il était fascinant de voir comment les outils modernes pouvaient transformer les possibilités de la RA, mais le parcours était loin d’être parfait.

Le problème est apparu lorsque la tête virtuelle ne s’alignait pas avec le visage réel comme prévu. Quel que soit l'angle ou l'appareil, le placement était toujours un peu « décalé », conduisant à un effet peu naturel. C'était comme si la représentation virtuelle était déconnectée de la réalité. Cela a déclenché une série d’expériences de dépannage.

De la modification des paramètres de la caméra d'Unity à l'expérimentation de l'algorithme de MediaPipe, chaque tentative a apporté des améliorations progressives, mais aucune solution définitive. Cet article plonge au cœur du problème, les leçons apprises et les solutions potentielles pour les développeurs confrontés à des défis similaires. 🚀

| Commande | Exemple d'utilisation |

|---|---|

| mainCamera.usePhysicalProperties | Cette commande permet d'utiliser les propriétés physiques de la caméra Unity, permettant un contrôle plus précis de la distance focale et de la distorsion de l'objectif pour aligner les objets virtuels et réels. |

| faceMesh.GetDetectedFaceTransform() | Récupère les données de transformation (position et rotation) d'un visage détecté à partir du maillage de visage de MediaPipe, cruciales pour placer avec précision les têtes virtuelles sur les visages réels. |

| UnityObjectToClipPos | Une fonction spécifique au shader qui transforme la position d'un sommet de l'espace objet en espace de clip, utilisée dans les shaders de correction de distorsion de l'objectif pour assurer l'alignement. |

| tex2D | Une commande de shader utilisée pour échantillonner une texture à des coordonnées UV spécifiées, essentielle pour appliquer une correction de distorsion aux flux de caméra. |

| length(distUV) | Calcule la distance euclidienne des coordonnées UV à partir de l'origine, qui est exploitée pour appliquer des ajustements progressifs de la distorsion de l'objectif. |

| adjuster.virtualHead | Une variable de script faisant référence à la tête virtuelle GameObject, permettant de mettre à jour dynamiquement sa position et sa rotation en fonction des données de suivi du visage. |

| [TestFixture] | Un attribut NUnit qui marque une classe comme appareil de test, signalant qu'elle contient des tests unitaires. Ceci est utile pour vérifier la logique d’alignement de la tête virtuelle. |

| Assert.AreEqual | Une méthode NUnit utilisée pour comparer les valeurs attendues et réelles lors des tests unitaires, garantissant que le placement de la tête virtuelle correspond aux résultats souhaités. |

| _DistortionStrength | Une propriété de shader qui ajuste l'intensité de la distorsion de l'objectif, affinant ainsi l'alignement entre les mondes réel et virtuel. |

| Quaternion.Euler | Crée une rotation basée sur les angles d'Euler, couramment utilisés pour aligner des objets comme la tête virtuelle dans l'espace 3D d'Unity. |

Améliorer la précision de la RA avec Unity et MediaPipe

Le premier script que nous avons exploré se concentre sur l'utilisation des propriétés physiques de la caméra d'Unity. En activant utiliser les propriétés physiques, nous ajustons le comportement de la caméra pour qu'il corresponde plus étroitement aux optiques du monde réel. Ceci est particulièrement important lorsque vous travaillez avec la RA, où même de légers écarts dans la distance focale ou le champ de vision peuvent donner l'impression que les objets virtuels sont mal alignés. Par exemple, régler la distance focale sur une valeur précise comme 35 mm peut aider à aligner la tête virtuelle avec le visage détecté. Cet ajustement s’apparente à un réglage précis d’un télescope pour mettre parfaitement au point des objets distants, garantissant ainsi que l’expérience AR soit naturelle et immersive. 📸

Un autre élément crucial du script consiste à récupérer la position et la rotation du visage détecté à l'aide de faceMesh.GetDetectedFaceTransform(). Cette fonction fournit des mises à jour en temps réel du maillage facial de MediaPipe, essentiel pour synchroniser la tête virtuelle avec les mouvements de l'utilisateur. Imaginez jouer à un jeu vidéo dans lequel la tête de votre personnage ne bouge pas de manière synchronisée avec la vôtre ; l'expérience serait bouleversante. En garantissant un alignement précis, ce script transforme la RA d'une nouveauté en un outil pouvant prendre en charge des applications telles que les réunions virtuelles ou les jeux avancés.

Le deuxième script se penche sur la programmation des shaders, abordant spécifiquement la distorsion de l'objectif. Le shader corrige les distorsions dans le flux de la caméra, en utilisant des propriétés telles que _DistortionStrength pour manipuler la façon dont les coordonnées UV sont mappées sur la texture. Ceci est particulièrement utile lorsqu’il s’agit d’objectifs grand angle ou d’appareils photo dotés de profils de distorsion uniques. Par exemple, si une tête virtuelle apparaît plus grande ou plus petite que le visage réel en fonction de l'angle, modifier les paramètres de distorsion garantit un meilleur alignement. C’est comme ajuster le cadre d’un miroir pour éliminer un effet funhouse, rendant les reflets plus réalistes. 🎨

Enfin, les tests unitaires du troisième script valident les solutions. Ces tests comparent la position et la rotation attendues de la tête virtuelle avec les résultats réels, garantissant ainsi que les ajustements tiennent dans diverses conditions. Utiliser les NUnits Assert.AreEqual, les développeurs peuvent simuler différents scénarios, comme déplacer la tête rapidement ou l'incliner à des angles extrêmes, pour confirmer l'alignement. Par exemple, pendant le développement, j’ai remarqué que l’alignement fonctionnait bien lorsque l’on faisait face vers l’avant, mais qu’il dérivait lorsque la tête se tournait sur le côté. Ces tests unitaires ont mis en évidence le problème et guidé de nouvelles améliorations, renforçant ainsi l'importance de tests approfondis dans la création d'applications AR robustes. 🚀

Ajustement du placement des objets virtuels en AR avec Unity et MediaPipe

Solution 1 : utilisation de la caméra physique d'Unity pour ajuster le champ de vision et la distorsion de l'objectif

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Explorer des ajustements alternatifs pour l’alignement de la tête virtuelle

Solution 2 : utiliser un shader personnalisé pour corriger la distorsion de l'objectif

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Tests pour une compatibilité améliorée dans les projets AR d'Unity

Solution 3 : implémentation de tests unitaires pour l'alignement de la tête virtuelle

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Affiner le placement de la RA grâce à des techniques d'étalonnage améliorées

Un aspect souvent négligé des problèmes d’alignement AR est l’importance de l’étalonnage de la caméra. Dans les projets AR, comme placer une tête virtuelle sur une tête réelle, l'objectif paramètres intrinsèques jouent un rôle essentiel. Ces paramètres incluent la distance focale, le centre optique et les coefficients de distorsion. Lorsque ces valeurs ne sont pas exactes, la tête virtuelle peut apparaître mal alignée ou déformée. Pour résoudre ce problème, des outils d'étalonnage peuvent être utilisés pour calculer ces paramètres pour la caméra spécifique de l'appareil. Par exemple, des logiciels comme OpenCV proposent des utilitaires d'étalonnage robustes pour générer des matrices de caméra et des profils de distorsion précis. 📐

Une autre approche consiste à exploiter les capacités de Unity pile de post-traitement. En appliquant des effets tels que des corrections de profondeur de champ ou d'aberration chromatique, vous pouvez atténuer les écarts entre la tête virtuelle rendue et l'environnement réel. Le post-traitement ajoute une couche de finition qui comble le fossé entre les objets virtuels et les espaces physiques. Par exemple, un effet de flou subtil peut réduire les bords nets qui rendent les désalignements visibles. Ceci est particulièrement utile dans les applications immersives où les utilisateurs sont très concentrés sur la scène.

Enfin, ne sous-estimez pas la puissance de l’adaptation dynamique pendant l’exécution. L'intégration de modèles d'apprentissage automatique dans votre pipeline AR peut permettre au système d'apprendre et d'ajuster le placement au fil du temps. Par exemple, un modèle d’IA pourrait analyser les commentaires des utilisateurs ou détecter des incohérences et affiner l’alignement de manière dynamique. Cela rend le système plus robuste et capable de gérer les variations d'éclairage, les performances de l'appareil ou le comportement des utilisateurs. Ces améliorations garantissent une expérience AR transparente, donnant l’impression que les mondes virtuel et réel sont véritablement intégrés. 🚀

Questions courantes sur le placement MediaPipe et Unity AR

- Pourquoi ma tête virtuelle est-elle mal alignée avec le visage réel ?

- Le problème vient souvent d’un mauvais calibrage de la caméra. Utiliser des outils comme OpenCV pour calculer le camera matrix et distortion coefficients peut grandement améliorer l’alignement.

- Quel est le rôle de la distance focale dans l’alignement de la RA ?

- Le focal length définit la façon dont la caméra projette des points 3D sur un plan 2D. L'ajuster dans les paramètres physiques de la caméra Unity peut améliorer la précision.

- Unity peut-il gérer la correction de la distorsion de l'objectif ?

- Oui, Unity prend en charge les shaders pour la correction de la distorsion. Implémentez un shader avec des propriétés telles que _DistortionStrength pour personnaliser les corrections en fonction de votre profil d'objectif.

- Comment tester l’alignement des objets virtuels ?

- Utiliser des tests unitaires dans NUnit avec des commandes telles que Assert.AreEqual permet de valider le positionnement et la rotation d'objets virtuels dans diverses conditions.

- Le post-traitement est-il nécessaire pour les projets AR ?

- Bien que cela ne soit pas obligatoire, les effets de post-traitement comme depth of field et chromatic aberration peut améliorer la qualité visuelle et le réalisme des scènes AR.

- MediaPipe peut-il détecter des objets autres que des visages ?

- Oui, MediaPipe propose des solutions pour les mains, les poses et même le suivi holistique, ce qui le rend polyvalent pour différents cas d'utilisation de RA.

- Quel matériel fonctionne le mieux pour les applications Unity AR ?

- Les appareils dotés de GPU hautes performances et de caméras précises sont idéaux. Des outils comme ARCore et ARKit améliorer encore la compatibilité.

- Pourquoi l’alignement est-il pire sous certains angles ?

- Cela pourrait être dû à une inadéquation du champ de vision entre la caméra et l'environnement virtuel. Réglage de la caméra Unity fieldOfView la propriété peut aider.

- Comment les shaders améliorent-ils l’alignement de la réalité augmentée ?

- Les shaders permettent des ajustements du rendu en temps réel, comme la correction des distorsions ou la simulation des effets d'objectif, garantissant une meilleure synchronisation entre les objets virtuels et réels.

- Les systèmes AR peuvent-ils s’auto-ajuster au fil du temps ?

- Oui, l’intégration de modèles d’apprentissage automatique permet aux systèmes de s’adapter de manière dynamique, en apprenant des commentaires pour améliorer l’alignement et les performances au fil du temps.

Améliorer la précision de la RA : dernières réflexions

Parvenir à un alignement précis entre les objets virtuels et réels est crucial pour les expériences de RA immersives. Grâce à un calibrage minutieux et à des techniques avancées, les problèmes tels que la distorsion de l'objectif et les distances focales inadaptées peuvent être atténués, garantissant ainsi une meilleure précision et une meilleure satisfaction de l'utilisateur.

L'intégration des outils Unity, des algorithmes MediaPipe et des ajustements dynamiques offre des solutions robustes pour les développeurs AR. Ces améliorations permettent un mélange transparent des mondes numérique et physique, ouvrant ainsi de nouvelles possibilités en matière de jeux, de réunions virtuelles et au-delà. Avec de la persévérance et de l’innovation, les défis d’alignement de la RA deviennent gérables. 🚀

Sources et références

- Les détails sur l'utilisation de MediaPipe dans Unity ont été référencés dans la documentation officielle de MediaPipe. Explorez-le ici .

- Des conseils sur l’étalonnage et les propriétés physiques de la caméra Unity sont disponibles sur le site de documentation Unity. Visite Paramètres de la caméra Unity pour plus de détails.

- La programmation des shaders pour les applications AR et la correction de la distorsion de l'objectif a été inspirée par des articles sur le développement des shaders, tels que ceux sur Codage félin .

- Les capacités et limitations d'ARCore pour le développement Android ont été examinées sur le site des développeurs ARCore de Google. Apprenez-en davantage sur Google ARCore .