CNNలలో పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లను డీమిస్టిఫై చేయడం

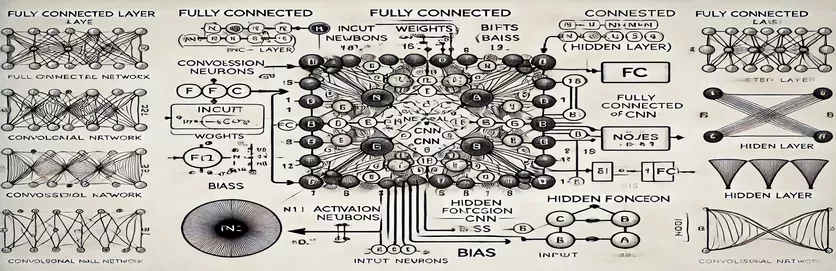

కన్వల్యూషనల్ న్యూరల్ నెట్వర్క్ (CNN)లో పూర్తిగా కనెక్ట్ చేయబడిన (FC) లేయర్ యొక్క పనితీరును అర్థం చేసుకోవడం ఒక రహస్యాన్ని విప్పినట్లు అనిపిస్తుంది. చాలా మందికి, గణన ప్రక్రియలో సంక్లిష్టత ఉంటుంది మరియు దాచిన పొరలో ఒక నోడ్ ఎలా ఉద్భవించింది. సాంప్రదాయ ఆర్టిఫిషియల్ న్యూరల్ నెట్వర్క్ల (ANNలు) వలె కాకుండా, CNNలలోని FC లేయర్ ట్యుటోరియల్లలో తరచుగా వివరించలేని సూక్ష్మ నైపుణ్యాలను కలిగి ఉంటుంది. మీరు దీని గురించి అయోమయంలో ఉంటే, మీరు ఒంటరిగా లేరు!

చాలా వనరులు ఈ అంశంపై స్కిమ్ అవుతాయి, అభ్యాసకులకు స్పష్టమైన మార్గదర్శకత్వం లేకుండా పోతుంది. ట్యుటోరియల్లు తరచుగా అసంపూర్ణ వివరణలను రీసైకిల్ చేస్తాయి, స్పష్టత కోరుకునే వారి నిరాశను పెంచుతాయి. మీరు పదేపదే సమాధానాల కోసం వెతుకుతున్నట్లు గుర్తించినట్లయితే, మీరు సరైన స్థలంలో ఉన్నారు. 🧩

ఈ గైడ్లో, మేము FC లేయర్ యొక్క దాచిన లేయర్ నుండి ఒకే నోడ్ను లెక్కించడంపై దృష్టి పెడతాము. మీరు ఒక నోడ్ కోసం మెకానిజమ్ను గ్రహించిన తర్వాత, మిగిలిన వాటిని పరిష్కరించడానికి మీరు సన్నద్ధమవుతారు. ఈ ప్రక్రియను స్పష్టమైన, చర్య తీసుకోదగిన దశలుగా విభజించడం ద్వారా, మీరు ఏదైనా FC లేయర్ గణనను నావిగేట్ చేయగల విశ్వాసాన్ని పొందుతారు.

సంబంధిత ఉదాహరణలు మరియు సరళమైన రేఖాచిత్రాన్ని ఉపయోగించి, మేము FC లేయర్లో ఇన్పుట్ల నుండి అవుట్పుట్ల వరకు మార్గాన్ని ప్రకాశవంతం చేస్తాము. అయోమయానికి వీడ్కోలు చెప్పండి మరియు అవగాహనకు హలో-మనం ప్రవేశిద్దాం! 🚀

| ఆదేశం | ఉపయోగం యొక్క ఉదాహరణ |

|---|---|

| np.dot() | రెండు శ్రేణుల మధ్య డాట్ ఉత్పత్తిని అమలు చేస్తుంది. పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లోని నోడ్ కోసం ఇన్పుట్లు మరియు బరువుల వెయిటెడ్ మొత్తాన్ని లెక్కించడానికి ఇక్కడ ఉపయోగించబడుతుంది. |

| np.maximum() | లెక్కించిన అవుట్పుట్ మరియు సున్నా మధ్య గరిష్ట విలువను ఎంచుకోవడం ద్వారా ReLU యాక్టివేషన్ ఫంక్షన్ను వర్తింపజేస్తుంది. |

| torch.tensor() | PyTorchలో టెన్సర్ను సృష్టిస్తుంది. లోతైన అభ్యాస ఫ్రేమ్వర్క్లలో డేటా ప్రాతినిధ్యం కోసం టెన్సర్లు ప్రాథమిక బిల్డింగ్ బ్లాక్లు. |

| torch.matmul() | PyTorchలో మాతృక గుణకారాన్ని నిర్వహిస్తుంది. ఇన్పుట్లు మరియు బరువుల మధ్య డాట్ ఉత్పత్తిని లెక్కించడానికి ఉపయోగించబడుతుంది. |

| torch.nn.functional.relu() | PyTorchలో ReLU యాక్టివేషన్ ఫంక్షన్ను వర్తింపజేస్తుంది, టెన్సర్లోని అన్ని ప్రతికూల విలువలను సున్నాకి సెట్ చేస్తుంది. |

| np.testing.assert_array_almost_equal() | నిర్దిష్ట సహనంలో సమానత్వం కోసం మూలకాల వారీగా రెండు శ్రేణులను సరిపోల్చండి. సంఖ్యాపరమైన కార్యకలాపాలలో అవుట్పుట్ ఖచ్చితత్వాన్ని పరీక్షించడానికి ఉపయోగపడుతుంది. |

| unittest.TestCase | పరీక్ష కేసులను రూపొందించడానికి యూనిట్టెస్ట్ మాడ్యూల్లో బేస్ క్లాస్. పైథాన్లో యూనిట్ పరీక్షలను రూపొందించడానికి మరియు నిర్వహించడానికి ఉపయోగించబడుతుంది. |

| np.array() | NumPyలో శ్రేణిని సృష్టిస్తుంది. పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ లెక్కల్లో ఇన్పుట్లు, బరువులు మరియు పక్షపాతాలను సూచించడానికి శ్రేణులు ఉపయోగించబడతాయి. |

| torch.matmul() | మాతృక గుణకారం కోసం PyTorch యొక్క ఫంక్షన్, న్యూరల్ నెట్వర్క్లలో అవుట్పుట్లను లెక్కించడానికి కీలకమైనది. |

| unittest.main() | స్క్రిప్ట్లో నిర్వచించిన అన్ని పరీక్ష కేసులను అమలు చేస్తుంది. అమలు చేయబడిన పరిష్కారాల యొక్క ఖచ్చితత్వం మరియు విశ్వసనీయతను ధృవీకరించడానికి అవసరం. |

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ గణనలను విచ్ఛిన్నం చేయడం

అందించిన స్క్రిప్ట్లు a లో నోడ్ ఎలా ఉందో డీమిస్టిఫై చేయడం లక్ష్యంగా పెట్టుకుంది పూర్తిగా కనెక్ట్ చేయబడింది (FC) CNN యొక్క లేయర్ మునుపటి లేయర్ నుండి డేటాను ప్రాసెస్ చేస్తుంది. ఈ లేయర్లు ప్రతి ఇన్పుట్ను ప్రతి నోడ్కి వెయిటెడ్ లింక్లు మరియు బయాస్లను ఉపయోగించి కనెక్ట్ చేస్తాయి, ఇవి ఇమేజ్ క్లాసిఫికేషన్ వంటి పనులకు అవసరం. మొదటి స్క్రిప్ట్ ఉపయోగించి ఒకే నోడ్ కోసం అవుట్పుట్ను గణిస్తుంది NumPy. ఇన్పుట్ విలువలను వాటి సంబంధిత బరువులతో గుణించడం మరియు పక్షపాతాన్ని జోడించడం ద్వారా, నోడ్ అవుట్పుట్ పొందబడుతుంది. ఈ అవుట్పుట్ నాన్-లీనియారిటీని పరిచయం చేయడానికి యాక్టివేషన్ ఫంక్షన్ (ఉదా., ReLU) ద్వారా పంపబడుతుంది. ఉదాహరణకు, చిత్రం యొక్క పిక్సెల్ విలువలను ఇన్పుట్లుగా ఊహించండి; బరువులు చిత్రం నుండి అర్థవంతమైన లక్షణాలను సంగ్రహించే నేర్చుకున్న ఫిల్టర్లను సూచిస్తాయి. 🖼️

రెండవ స్క్రిప్ట్ బహుళ నోడ్ల కోసం గణనను సాధారణీకరిస్తుంది. ఇది మాతృక గుణకారాన్ని ఉపయోగిస్తుంది, ఇక్కడ బరువులు 2D మ్యాట్రిక్స్గా మరియు ఇన్పుట్లు వెక్టర్గా సూచించబడతాయి. ఈ సమర్థవంతమైన విధానం లేయర్లోని అన్ని నోడ్ల కోసం ఏకకాల గణనను అనుమతిస్తుంది. పక్షపాతాలను జోడించడం ద్వారా మరియు ReLU యాక్టివేషన్ ఫంక్షన్ని వర్తింపజేయడం ద్వారా, లేయర్ యొక్క తుది అవుట్పుట్లు ఉత్పత్తి చేయబడతాయి. ఈ పద్ధతి అత్యంత స్కేలబుల్ మరియు ఆధునిక డీప్ లెర్నింగ్ ఫ్రేమ్వర్క్లలో ఒక ప్రధాన ఆపరేషన్. ఉదాహరణకు, ముఖ గుర్తింపు వ్యవస్థలో, గుర్తించబడిన ఆకారం మానవ ముఖాన్ని పోలి ఉందో లేదో తెలుసుకోవడానికి ఈ ప్రక్రియ సహాయపడుతుంది. 😊

వంటి లోతైన అభ్యాస లైబ్రరీలతో పనిచేసే వారికి పైటార్చ్, మూడవ స్క్రిప్ట్ అదే గణనలను సాధించడానికి టెన్సర్లను మరియు అంతర్నిర్మిత ఫంక్షన్లను ఎలా ఉపయోగించాలో ప్రదర్శిస్తుంది. PyTorch యొక్క ఫ్లెక్సిబిలిటీ మరియు అంతర్నిర్మిత ఆప్టిమైజేషన్లు న్యూరల్ నెట్వర్క్లను నిర్మించడానికి మరియు శిక్షణ ఇవ్వడానికి అనువైనవిగా చేస్తాయి. ఇన్పుట్లు, బరువులు మరియు బయాస్లను టెన్సర్లుగా ఎలా నిర్వచించాలో మరియు మాతృక గుణకారాన్ని ఎలా నిర్వహించాలో స్క్రిప్ట్ చూపిస్తుంది torch.matmul() ఫంక్షన్. వన్యప్రాణుల ఛాయాచిత్రాలలో జంతువులను గుర్తించడం వంటి పెద్ద డేటాసెట్లపై CNNలకు శిక్షణ ఇవ్వడానికి ఎండ్-టు-ఎండ్ పైప్లైన్లను రూపొందించడానికి ఇది ప్రత్యేకంగా ఉపయోగపడుతుంది.

చివరగా, యూనిట్ పరీక్షల స్క్రిప్ట్ వివిధ పరిస్థితులలో అన్ని అమలులు సరిగ్గా పనిచేస్తాయని నిర్ధారిస్తుంది. ఉపయోగించి ఏకపరీక్ష లైబ్రరీ, ఇది లెక్కల సంఖ్యా ఖచ్చితత్వాన్ని ధృవీకరిస్తుంది మరియు అవుట్పుట్లు ఆశించిన ఫలితాలను అందజేస్తాయని నిర్ధారిస్తుంది. డీబగ్గింగ్ మరియు విశ్వసనీయతను నిర్ధారించడానికి ఈ దశ కీలకం, ప్రత్యేకించి మెడికల్ ఇమేజ్ అనాలిసిస్ వంటి వాస్తవ-ప్రపంచ అనువర్తనాల్లో CNNలను అమలు చేస్తున్నప్పుడు. ఈ స్క్రిప్ట్లు మరియు వివరణలతో, CNNలలో FC లేయర్లను నమ్మకంగా అర్థం చేసుకోవడానికి మరియు అమలు చేయడానికి మీకు ఇప్పుడు స్పష్టమైన మార్గం ఉంది. 🚀

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లో నోడ్ యొక్క గణనను అర్థం చేసుకోవడం

మ్యాట్రిక్స్ లెక్కల కోసం పైథాన్-ఆధారిత పరిష్కారం NumPyని ప్రభావితం చేస్తుంది

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లలో నోడ్ గణనను సాధారణీకరించడం

దాచిన పొరలో అన్ని నోడ్లను లెక్కించడానికి పైథాన్ ఆధారిత పరిష్కారం

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లో నోడ్ లెక్కింపు కోసం PyTorchని ఉపయోగించడం

లోతైన అభ్యాస ఔత్సాహికుల కోసం PyTorchతో అమలు

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

యూనిట్ పరీక్షలతో ప్రతి పరిష్కారాన్ని పరీక్షించండి

అమలుల యొక్క ఖచ్చితత్వాన్ని నిర్ధారించడానికి పైథాన్-ఆధారిత యూనిట్ పరీక్షలు

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNNలలో పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ల ప్రాముఖ్యతను విప్పుతోంది

పూర్తిగా కనెక్ట్ చేయబడిన (FC) లేయర్లు కన్వల్యూషనల్ లేయర్ల నుండి సంగ్రహించిన లక్షణాలను తుది అంచనాలుగా మార్చడంలో కీలక పాత్ర పోషిస్తాయి. వారు ప్రతి ఇన్పుట్ను ప్రతి అవుట్పుట్కు కనెక్ట్ చేయడం ద్వారా పని చేస్తారు, నేర్చుకున్న లక్షణాల యొక్క దట్టమైన మ్యాపింగ్ను అందిస్తారు. ప్రాదేశిక సోపానక్రమాలపై దృష్టి సారించే కన్వల్యూషనల్ లేయర్ల వలె కాకుండా, FC లేయర్లు చిత్రంలో వస్తువులను గుర్తించడం వంటి నిర్ణయాలు తీసుకోవడానికి ఈ సమాచారాన్ని సమగ్రపరుస్తాయి. ఉదాహరణకు, స్వీయ-డ్రైవింగ్ కారు యొక్క ఇమేజ్ రికగ్నిషన్ సిస్టమ్లో, FC లేయర్ కనుగొనబడిన వస్తువు పాదచారులదా లేదా వీధి గుర్తునా అని నిర్ణయిస్తుంది. 🚗

FC లేయర్లను వేరుగా ఉంచే ఒక అంశం శిక్షణ సమయంలో నేర్చుకున్న నమూనాలను సాధారణీకరించే వారి సామర్థ్యం. కనిపించని డేటాతో వ్యవహరించేటప్పుడు ఈ ఆస్తి కీలకం. లేయర్లోని ప్రతి నోడ్ బరువులు మరియు పక్షపాతాల యొక్క ప్రత్యేకమైన కలయికను సూచిస్తుంది, ఇది నిర్దిష్ట నమూనాలు లేదా తరగతులను గుర్తించడంలో ప్రత్యేకతను కలిగిస్తుంది. అందుకే FC లేయర్ల నిర్మాణం తరచుగా మొత్తం మోడల్ యొక్క ఖచ్చితత్వాన్ని నిర్ణయిస్తుంది. ఉదాహరణకు, చేతితో వ్రాసిన అంకెల గుర్తింపు నమూనాలో, FC లేయర్ పిక్సెల్ నమూనాలను సంఖ్యా అంచనాలుగా (0-9) ఏకీకృతం చేస్తుంది. ✍️

FC లేయర్లు వాటి దట్టమైన కనెక్షన్ల కారణంగా గణనపరంగా ఖరీదైనవి అయినప్పటికీ, వివరణాత్మక వర్గీకరణ అవసరమయ్యే పనులకు అవి చాలా ముఖ్యమైనవి. ఓవర్ఫిట్ను నిరోధించడం ద్వారా వారి పనితీరును ఆప్టిమైజ్ చేయడానికి డ్రాప్అవుట్ వంటి ఆధునిక పద్ధతులు ఉపయోగించబడతాయి. శిక్షణ సమయంలో యాక్టివ్ నోడ్ల సంఖ్యను తగ్గించడం ద్వారా, డ్రాప్అవుట్ FC లేయర్ బలమైన లక్షణాలను నేర్చుకునేలా చేస్తుంది, ఇది ముఖ గుర్తింపు మరియు మెడికల్ ఇమేజ్ డయాగ్నస్టిక్స్ వంటి అప్లికేషన్లలో ఇది ఎంతో అవసరం.

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ల గురించి సాధారణ ప్రశ్నలు

- CNNలలో పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ యొక్క ప్రధాన విధి ఏమిటి?

- FC లేయర్ అన్ని ఇన్పుట్లను అవుట్పుట్లకు కలుపుతుంది, తుది అంచనాల కోసం లక్షణాలను సమగ్రం చేస్తుంది. ఫీచర్ మ్యాప్లను కార్యాచరణ ఫలితాలుగా మార్చడానికి ఇది కీలకం.

- FC లేయర్లలో బరువులు మరియు పక్షపాతాలు ఎలా ప్రారంభించబడతాయి?

- బరువులు తరచుగా యాదృచ్ఛికంగా ప్రారంభించబడతాయి లేదా జేవియర్ ప్రారంభించడం వంటి సాంకేతికతలను ఉపయోగిస్తాయి, అయితే పక్షపాతాలు సాధారణంగా సరళత కోసం సున్నా వద్ద ప్రారంభమవుతాయి.

- ReLU యాక్టివేషన్ FC లేయర్ పనితీరును ఎలా మెరుగుపరుస్తుంది?

- ReLU ప్రతికూల అవుట్పుట్లను సున్నాకి సెట్ చేయడం ద్వారా నాన్-లీనియారిటీని వర్తింపజేస్తుంది. ఇది వానిషింగ్ గ్రేడియంట్లను నిరోధిస్తుంది, మోడల్ వేగంగా కలుస్తుంది.

- డ్రాపౌట్ని FC లేయర్లకు వర్తింపజేయవచ్చా?

- అవును, డ్రాప్అవుట్ శిక్షణ సమయంలో నోడ్లను యాదృచ్ఛికంగా నిలిపివేస్తుంది, మోడల్ సాధారణీకరణను మెరుగుపరుస్తుంది మరియు ఓవర్ఫిట్ను తగ్గిస్తుంది.

- కన్వల్యూషనల్ లేయర్ల నుండి FC లేయర్లను ఏది భిన్నంగా చేస్తుంది?

- కన్వల్యూషనల్ లేయర్లు ప్రాదేశిక లక్షణాలను సంగ్రహిస్తున్నప్పుడు, FC లేయర్లు వర్గీకరణ కోసం ఈ లక్షణాలను దట్టమైన ఆకృతిలో కలుపుతాయి.

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లపై కీలక టేకావేలు

పూర్తిగా కనెక్ట్ చేయబడిన లేయర్ నేర్చుకున్న లక్షణాలను చర్య తీసుకోగల అంచనాలుగా ఏకీకృతం చేస్తుంది, ఇది న్యూరల్ నెట్వర్క్లలో తుది నిర్ణయం తీసుకునే దశగా పనిచేస్తుంది. ప్రతి నోడ్ ఎలా లెక్కించబడుతుందో అర్థం చేసుకోవడం ద్వారా, ఆబ్జెక్ట్ డిటెక్షన్ మరియు వర్గీకరణ వంటి పనుల కోసం CNN ఆర్కిటెక్చర్లను రూపొందించడంలో మరియు ఆప్టిమైజ్ చేయడంలో వినియోగదారులు విశ్వాసాన్ని పొందుతారు.

స్వయంప్రతిపత్త వాహనాల్లో ఇమేజ్ రికగ్నిషన్ లేదా ఫేషియల్ ఐడెంటిఫికేషన్ వంటి ఆచరణాత్మక ఉదాహరణలు FC లేయర్ల ప్రాముఖ్యతను ప్రదర్శిస్తాయి. సరైన విధానంతో, ఆప్టిమైజేషన్ పద్ధతులను చేర్చడం అనేది చూడని డేటాకు బాగా అనుగుణంగా ఉండే బలమైన మరియు ఖచ్చితమైన నమూనాలను నిర్ధారిస్తుంది. ఈ భావన యొక్క ప్రావీణ్యం కృత్రిమ మేధస్సులో లోతైన అన్వేషణను అన్లాక్ చేస్తుంది. 😊

మూలాలు మరియు సూచనలు

- CNNలలో పూర్తిగా కనెక్ట్ చేయబడిన లేయర్లపై వివరణాత్మక వివరణ మూలం మెషిన్ లెర్నింగ్ పాండిత్యం .

- యాక్టివేషన్ ఫంక్షన్లకు సమగ్ర గైడ్ మరియు వాటి అప్లికేషన్ల నుండి తిరిగి పొందబడింది Analytics Vidhya .

- న్యూరల్ నెట్వర్క్ల కోసం డ్రాప్అవుట్ మరియు ఆప్టిమైజేషన్ టెక్నిక్లలో అంతర్దృష్టులు కనుగొనబడ్డాయి డీప్ఏఐ .

- నుండి న్యూరల్ నెట్వర్క్లలో బరువులు మరియు పక్షపాతాలను అర్థం చేసుకోవడం డేటా సైన్స్ వైపు .

- PyTorchలో ReLU యాక్టివేషన్ ఫంక్షన్ల ఉపయోగం దీని నుండి తీసుకోబడింది PyTorch డాక్యుమెంటేషన్ .