Utmaningar i Virtual Head Placement för AR-utveckling

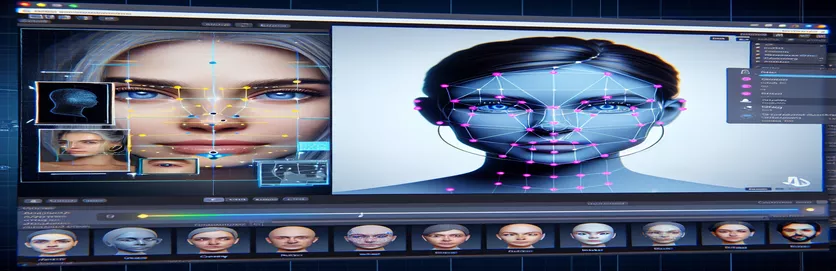

Att arbeta med ett förstärkt verklighetsprojekt (AR) kan vara både spännande och utmanande. När jag utvecklade en Android-applikation med Unity, strävade jag efter att blanda den digitala och verkliga världen sömlöst genom att placera ett virtuellt huvud över verkliga ansikten. Den här funktionen är starkt beroende av precision för att skapa en uppslukande upplevelse. 🕶️

För att uppnå detta använde jag Googles MediaPipe för att upptäcka landmärken i ansiktet som ögon, näsor och munnar. Det virtuella huvudet genererades sedan och placerades baserat på dessa nyckelpunkter. Det var fascinerande att se hur moderna verktyg kunde förvandla AR-möjligheter, men resan var långt ifrån perfekt.

Problemet uppstod när det virtuella huvudet inte var i linje med det faktiska ansiktet som förväntat. Oavsett vinkel eller enhet var placeringen alltid lite "off", vilket ledde till en onaturlig effekt. Det var som om den virtuella representationen var frånkopplad från verkligheten. Detta utlöste en rad felsökningsexperiment.

Från att justera Unitys kamerainställningar till att experimentera med MediaPipes algoritm, varje försök gav inkrementella förbättringar men ingen definitiv lösning. Den här artikeln dyker ner i kärnan av problemet, lärdomarna och potentiella lösningar för utvecklare som står inför liknande utmaningar. 🚀

| Kommando | Exempel på användning |

|---|---|

| mainCamera.usePhysicalProperties | Detta kommando möjliggör användning av Unitys fysiska kameraegenskaper, vilket möjliggör mer exakt kontroll över brännvidd och linsförvrängning för att justera virtuella och verkliga objekt. |

| faceMesh.GetDetectedFaceTransform() | Hämtar transformationsdata (position och rotation) för ett detekterat ansikte från MediaPipes ansiktsnät, avgörande för att placera virtuella huvuden exakt över verkliga ansikten. |

| UnityObjectToClipPos | En shader-specifik funktion som omvandlar en vertexposition från objektutrymme till clipspace, som används i linsförvrängningskorrigering för att säkerställa justering. |

| tex2D | Ett shader-kommando som används för att sampla en textur vid specificerade UV-koordinater, viktigt för att tillämpa distorsionskorrigering på kameraflöden. |

| length(distUV) | Beräknar det euklidiska avståndet för UV-koordinater från origo, vilket utnyttjas för att tillämpa gradvisa linsförvrängningsjusteringar. |

| adjuster.virtualHead | En skriptvariabel som hänvisar till det virtuella huvudet GameObject, vilket gör att dess position och rotation kan uppdateras dynamiskt baserat på ansiktsspårningsdata. |

| [TestFixture] | Ett NUnit-attribut som markerar en klass som en testfixtur, vilket signalerar att den innehåller enhetstester. Detta är användbart för att verifiera logik för virtuell huvudinriktning. |

| Assert.AreEqual | En NUnit-metod som används för att jämföra förväntade och faktiska värden under enhetstestning, vilket säkerställer att den virtuella huvudplaceringen matchar de önskade resultaten. |

| _DistortionStrength | En skuggningsegenskap som justerar intensiteten av linsförvrängning och finjusterar anpassningen mellan den verkliga och virtuella världen. |

| Quaternion.Euler | Skapar en rotation baserad på Euler-vinklar, som vanligtvis används för att justera objekt som det virtuella huvudet i Unitys 3D-utrymme. |

Förbättra AR-noggrannheten med Unity och MediaPipe

Det första skriptet vi utforskade fokuserar på att använda Unitys fysiska kameraegenskaper. Genom att aktivera använd Physical Properties, justerar vi kamerans beteende för att matcha den verkliga optiken närmare. Detta är särskilt viktigt när du arbetar med AR, där även små avvikelser i brännvidd eller synfält kan få virtuella objekt att se felinriktade. Om du till exempel ställer in brännvidden till ett exakt värde som 35 mm kan det hjälpa till att rikta in det virtuella huvudet med det detekterade ansiktet. Den här justeringen liknar finjustering av ett teleskop för att bringa avlägsna objekt i perfekt fokus, vilket säkerställer att AR-upplevelsen känns naturlig och uppslukande. 📸

En annan viktig komponent i skriptet är att hämta det upptäckta ansiktets position och rotation med hjälp av faceMesh.GetDetectedFaceTransform(). Denna funktion ger realtidsuppdateringar från MediaPipes ansiktsnät, vilket är väsentligt för att synkronisera det virtuella huvudet med användarens rörelser. Föreställ dig att spela ett videospel där din karaktärs huvud inte rör sig synkroniserat med ditt eget; upplevelsen skulle vara skrämmande. Genom att säkerställa korrekt anpassning förvandlar detta skript AR från en nyhet till ett verktyg som kan stödja applikationer som virtuella möten eller avancerade spel.

Det andra skriptet fördjupar sig i shader-programmering, speciellt för att ta itu med linsförvrängning. Skuggningen korrigerar förvrängningar i kameraflödet och använder egenskaper som _DistortionStrength för att manipulera hur UV-koordinater mappas på texturen. Detta är särskilt användbart när du hanterar vidvinkelobjektiv eller kameror med unika distorsionsprofiler. Till exempel, om ett virtuellt huvud verkar större eller mindre än det faktiska ansiktet beroende på vinkeln, säkerställer justering av distorsionsinställningarna bättre inriktning. Det är som att justera ramen på en spegel för att eliminera en funhouse-effekt, vilket gör reflektioner mer realistiska. 🎨

Slutligen validerar enhetstesten från det tredje skriptet lösningarna. Dessa tester jämför den förväntade positionen och rotationen av det virtuella huvudet med de faktiska resultaten, vilket säkerställer att justeringarna håller i sig under olika förhållanden. Använder NUnit's Assert.AreEqual, kan utvecklare simulera olika scenarier, som att flytta huvudet snabbt eller luta det i extrema vinklar, för att bekräfta inriktningen. Till exempel, under utvecklingen, märkte jag att inriktningen fungerade bra när jag var vänd framåt men drev när huvudet vände sig åt sidan. Dessa enhetstester lyfte fram problemet och vägledde ytterligare förbättringar, vilket förstärkte vikten av grundliga tester för att skapa robusta AR-applikationer. 🚀

Justera virtuell objektplacering i AR med Unity och MediaPipe

Lösning 1: Använd Unitys fysiska kamera för att justera FOV och linsförvrängning

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Utforska alternativa justeringar för virtuell huvuduppriktning

Lösning 2: Använd en anpassad shader för att korrigera linsförvrängning

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testar för förbättrad kompatibilitet i Unitys AR-projekt

Lösning 3: Implementera enhetstester för virtuell huvuduppriktning

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Förfina AR-placering genom förbättrade kalibreringstekniker

En ofta förbisedd aspekt av AR-anpassningsproblem är vikten av kamerakalibrering. I AR-projekt som att placera ett virtuellt huvud över ett riktigt, objektivets inneboende parametrar spelar en viktig roll. Dessa parametrar inkluderar brännvidd, optiskt centrum och distorsionskoefficienter. När dessa värden inte är korrekta kan det virtuella huvudet verka feljusterat eller förvrängt. För att hantera detta kan kalibreringsverktyg användas för att beräkna dessa parametrar för den specifika enhetskameran. Till exempel erbjuder programvara som OpenCV robusta kalibreringsverktyg för att generera exakta kameramatriser och distorsionsprofiler. 📐

Ett annat tillvägagångssätt innebär att utnyttja Unitys efterbearbetningsstapel. Genom att tillämpa effekter som skärpedjup eller kromatisk aberrationskorrigering kan du jämna ut avvikelser mellan det renderade virtuella huvudet och den verkliga miljön. Efterbehandling lägger till ett lager av polering som överbryggar gapet mellan virtuella objekt och fysiska utrymmen. Till exempel kan en subtil oskärpa effekt minska de hårda kanterna som gör feljusteringar märkbara. Detta är särskilt användbart i uppslukande applikationer där användarna är mycket fokuserade på scenen.

Slutligen, underskatta inte kraften i dynamisk anpassning under körning. Genom att integrera maskininlärningsmodeller i din AR-pipeline kan systemet lära sig och justera placeringen över tid. Till exempel kan en AI-modell analysera användarfeedback eller upptäckta inkonsekvenser och finjustera justeringen dynamiskt. Detta gör systemet mer robust och kapabelt att hantera variationer i belysning, enhetsprestanda eller användarbeteende. Dessa förbättringar säkerställer en sömlös AR-upplevelse, vilket gör att den virtuella och verkliga världen känns riktigt integrerad. 🚀

Vanliga frågor om MediaPipe och Unity AR-placering

- Varför är mitt virtuella huvud felinriktat med det verkliga ansiktet?

- Problemet beror ofta på felaktig kamerakalibrering. Använda verktyg som OpenCV för att beräkna camera matrix och distortion coefficients kan förbättra anpassningen avsevärt.

- Vilken roll spelar brännvidden i AR-uppriktning?

- De focal length definierar hur kameran projicerar 3D-punkter på ett 2D-plan. Att justera den i Unitys fysiska kamerainställningar kan förbättra noggrannheten.

- Kan Unity hantera linsförvrängningskorrigering?

- Ja, Unity stöder shaders för distorsionskorrigering. Implementera en shader med egenskaper som _DistortionStrength för att anpassa korrigeringar baserat på din linsprofil.

- Hur kan jag testa justeringen av virtuella objekt?

- Använda enhetstester i NUnit med kommandon som Assert.AreEqual låter dig validera placeringen och rotationen av virtuella objekt under olika förhållanden.

- Är efterbehandling nödvändig för AR-projekt?

- Även om det inte är obligatoriskt, efterbearbetningseffekter som depth of field och chromatic aberration kan förbättra den visuella kvaliteten och realismen i AR-scener.

- Kan MediaPipe upptäcka andra föremål än ansikten?

- Ja, MediaPipe erbjuder lösningar för händer, poser och till och med holistisk spårning, vilket gör den mångsidig för olika AR-användningsfall.

- Vilken hårdvara fungerar bäst för Unity AR-applikationer?

- Enheter med högpresterande GPU:er och exakta kameror är idealiska. Verktyg som ARCore och ARKit förbättra kompatibiliteten ytterligare.

- Varför är inriktningen sämre i vissa vinklar?

- Detta kan bero på en bristande överensstämmelse i synfältet mellan kameran och den virtuella miljön. Justering av Unity-kamerorna fieldOfView egendom kan hjälpa.

- Hur förbättrar shaders AR-justering?

- Shaders möjliggör realtidsjusteringar av renderingen, som att korrigera förvrängningar eller simulera linseffekter, vilket säkerställer bättre synkronisering mellan virtuella och verkliga objekt.

- Kan AR-system självjusteras över tid?

- Ja, att integrera maskininlärningsmodeller gör det möjligt för system att anpassa sig dynamiskt, lära sig av feedback för att förbättra anpassning och prestanda över tid.

Förbättra AR-noggrannheten: sista tankar

Att uppnå exakt anpassning mellan virtuella och verkliga objekt är avgörande för uppslukande AR-upplevelser. Genom noggrann kalibrering och avancerade tekniker kan problem som linsförvrängning och felaktiga brännvidder mildras, vilket säkerställer bättre noggrannhet och användarnöjdhet.

Att integrera Unitys verktyg, MediaPipe-algoritmer och dynamiska justeringar erbjuder robusta lösningar för AR-utvecklare. Dessa förbättringar möjliggör en sömlös blandning av digitala och fysiska världar, och låser upp nya möjligheter för spel, virtuella möten och mer. Med uthållighet och innovation blir AR-anpassningsutmaningar hanterbara. 🚀

Källor och referenser

- Detaljer om hur du använder MediaPipe i Unity refererades från den officiella MediaPipe-dokumentationen. Utforska det här .

- Vägledning om Unitys kamerakalibrering och fysiska egenskaper finns på Unitys dokumentationssida. Besök Unity-kamerainställningar för mer information.

- Shader-programmering för AR-applikationer och linsförvrängningskorrigering inspirerades av artiklar om shader-utveckling, t.ex. Kattliknande kodning .

- ARCores funktioner och begränsningar för Android-utveckling granskades från Googles ARCore-utvecklarwebbplats. Läs mer på Google ARCore .