Izzivi pri postavitvi virtualne glave za razvoj AR

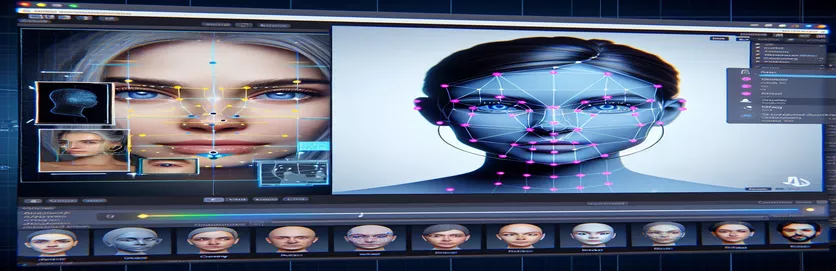

Delo na projektu razširjene resničnosti (AR) je lahko vznemirljivo in zahtevno. Ko sem razvijal aplikacijo za Android z Unity, sem želel brezhibno združiti digitalni in resnični svet tako, da sem virtualno glavo postavil nad obraze iz resničnega sveta. Ta funkcija je močno odvisna od natančnosti, da ustvari izjemno izkušnjo. 🕶️

Da bi to dosegel, sem uporabil Googlov MediaPipe za zaznavanje obraznih mejnikov, kot so oči, nosovi in usta. Virtualna glava je bila nato ustvarjena in postavljena na podlagi teh ključnih točk. Fascinantno je bilo videti, kako lahko sodobna orodja preoblikujejo možnosti AR, vendar potovanje še zdaleč ni bilo popolno.

Težava se je pojavila, ko se virtualna glava ni poravnala z dejanskim obrazom, kot je bilo pričakovano. Ne glede na kot ali napravo je bila postavitev vedno nekoliko "izklopljena", kar je povzročilo nenaraven učinek. Bilo je, kot da je bila virtualna predstavitev ločena od realnosti. To je sprožilo vrsto poskusov za odpravljanje težav.

Od prilagajanja nastavitev kamere Unity do eksperimentiranja z algoritmom MediaPipe je vsak poskus prinesel postopne izboljšave, vendar ne dokončne rešitve. Ta članek se poglobi v jedro problema, pridobljene izkušnje in možne rešitve za razvijalce, ki se soočajo s podobnimi izzivi. 🚀

| Ukaz | Primer uporabe |

|---|---|

| mainCamera.usePhysicalProperties | Ta ukaz omogoča uporabo fizičnih lastnosti kamere Unity, kar omogoča natančnejši nadzor nad goriščno razdaljo in popačenjem leče za poravnavo virtualnih in resničnih predmetov. |

| faceMesh.GetDetectedFaceTransform() | Pridobi transformacijske podatke (položaj in vrtenje) zaznanega obraza iz obrazne mreže MediaPipe, ki je ključnega pomena za natančno postavitev virtualnih glav nad dejanske obraze. |

| UnityObjectToClipPos | Funkcija, specifična za senčnike, ki preoblikuje položaj vozlišča iz prostora predmeta v prostor izrezka, ki se uporablja v senčnikih za korekcijo popačenja leče, da se zagotovi poravnava. |

| tex2D | Ukaz za senčenje, ki se uporablja za vzorčenje teksture na določenih koordinatah UV, bistvenega pomena za uporabo korekcije popačenja v virih kamere. |

| length(distUV) | Izračuna evklidsko razdaljo koordinat UV od izhodišča, ki se uporablja za postopno prilagajanje popačenja leče. |

| adjuster.virtualHead | Spremenljivka skripta, ki se nanaša na virtualno glavo GameObject, ki omogoča dinamično posodabljanje njenega položaja in rotacije na podlagi podatkov o sledenju obrazu. |

| [TestFixture] | Atribut NUnit, ki označuje razred kot testno stalnico, kar pomeni, da vsebuje teste enot. To je uporabno za preverjanje logike navidezne poravnave glave. |

| Assert.AreEqual | Metoda NUnit, ki se uporablja za primerjavo pričakovanih in dejanskih vrednosti med testiranjem enote, kar zagotavlja, da se navidezna postavitev glave ujema z želenimi rezultati. |

| _DistortionStrength | Lastnost senčenja, ki prilagaja intenzivnost popačenja leče in natančno prilagaja poravnavo med resničnim in virtualnim svetom. |

| Quaternion.Euler | Ustvari rotacijo na podlagi Eulerjevih kotov, ki se običajno uporablja za poravnavo predmetov, kot je navidezna glava v 3D prostoru Unity. |

Izboljšanje natančnosti AR z Unity in MediaPipe

Prvi skript, ki smo ga raziskali, se osredotoča na uporabo fizičnih lastnosti kamere Unity. Z omogočanjem usePhysicalPropertiesprilagodimo obnašanje kamere, da se bolj ujema z realno optiko. To je še posebej pomembno pri delu z AR, kjer lahko že majhna odstopanja v goriščni razdalji ali vidnem polju povzročijo, da so virtualni predmeti videti neporavnani. Na primer, nastavitev goriščne razdalje na natančno vrednost, kot je 35 mm, lahko pomaga poravnati navidezno glavo z zaznanim obrazom. Ta prilagoditev je podobna fini nastavitvi teleskopa, da se oddaljeni predmeti popolno izostrijo, kar zagotavlja, da je izkušnja AR naravna in poglobljena. 📸

Druga ključna komponenta skripta je pridobivanje položaja in rotacije zaznanega obraza z uporabo faceMesh.GetDetectedFaceTransform(). Ta funkcija zagotavlja posodobitve v realnem času iz obrazne mreže MediaPipe, ki je bistvena za sinhronizacijo virtualne glave z gibi uporabnika. Predstavljajte si, da igrate videoigro, kjer se glava vašega lika ne premika sinhronizirano z vašo; izkušnja bi bila grozljiva. Z zagotavljanjem natančne poravnave ta skript spremeni AR iz novosti v orodje, ki lahko podpira aplikacije, kot so virtualni sestanki ali napredne igre.

Drugi skript se poglobi v programiranje senčil, posebej obravnava popačenje leč. Senčnik popravi popačenja v viru kamere z uporabo lastnosti, kot je _DistortionStrength, za manipulacijo načina preslikave koordinat UV na teksturo. To je še posebej uporabno, ko imate opravka s širokokotnimi objektivi ali kamerami z edinstvenimi profili popačenja. Če je na primer navidezna glava videti večja ali manjša od dejanskega obraza, odvisno od kota, prilagajanje nastavitev popačenja zagotavlja boljšo poravnavo. To je tako, kot bi prilagodili okvir ogledala, da bi odpravili učinek zabavne hiše, zaradi česar so odsevi bolj realistični. 🎨

Končno testi enot iz tretjega skripta potrdijo rešitve. Ti testi primerjajo pričakovani položaj in rotacijo navidezne glave z dejanskimi rezultati, kar zagotavlja, da prilagoditve vzdržijo v različnih pogojih. Uporaba NUnit's Assert.AreEqual, lahko razvijalci simulirajo različne scenarije, kot je hitro premikanje glave ali njeno nagibanje pod skrajnimi koti, da potrdijo poravnavo. Na primer, med razvojem sem opazil, da je poravnava dobro delovala, ko je obrnjena naprej, vendar je zanesla, ko je glava obrnjena na stran. Ti testi enot so poudarili težavo in usmerjali nadaljnje izboljšave ter okrepili pomen temeljitega testiranja pri ustvarjanju robustnih aplikacij AR. 🚀

Prilagajanje postavitve navideznega predmeta v AR z Unity in MediaPipe

1. rešitev: Uporaba fizične kamere Unity za prilagoditev FOV in popačenja leče

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Raziskovanje alternativnih prilagoditev za navidezno poravnavo glave

2. rešitev: Uporaba senčila po meri za popravljanje popačenja leče

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testiranje za izboljšano združljivost v projektih AR Unity

Rešitev 3: Izvedba testov enote za navidezno poravnavo glave

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Izboljšanje umestitve AR z izboljšanimi tehnikami umerjanja

Eden pogosto spregledanih vidikov težav s poravnavo AR je pomembnost kalibracije kamere. V projektih AR, kot je postavitev navidezne glave nad resnično glavo, lečo intrinzični parametri igrajo ključno vlogo. Ti parametri vključujejo goriščno razdaljo, optično središče in koeficiente popačenja. Če te vrednosti niso točne, je lahko navidezna glava videti neporavnana ali popačena. Da bi to rešili, je mogoče uporabiti orodja za umerjanje za izračun teh parametrov za določeno kamero naprave. Na primer, programska oprema, kot je OpenCV, ponuja robustne kalibracijske pripomočke za ustvarjanje natančnih matric kamere in profilov popačenja. 📐

Drugi pristop vključuje uporabo Unityjevega sklad za naknadno obdelavo. Z uporabo učinkov, kot so globinska ostrina ali popravki kromatskih aberacij, lahko zgladite neskladja med upodobljeno virtualno glavo in okoljem v resničnem svetu. Naknadna obdelava doda plast poliranja, ki premosti vrzel med virtualnimi predmeti in fizičnimi prostori. Na primer, subtilen učinek zameglitve lahko zmanjša ostre robove, zaradi katerih so neporavnanosti opazne. To je še posebej uporabno v poglobljenih aplikacijah, kjer so uporabniki zelo osredotočeni na sceno.

Nenazadnje ne podcenjujte moči dinamičnega prilagajanja med izvajanjem. Vključitev modelov strojnega učenja v vaš cevovod AR lahko omogoči sistemu, da se sčasoma nauči in prilagodi umestitev. Na primer, model AI bi lahko analiziral povratne informacije uporabnikov ali zaznane nedoslednosti in dinamično natančno prilagodil poravnavo. Zaradi tega je sistem bolj robusten in sposoben obravnavati spremembe v osvetlitvi, zmogljivosti naprave ali vedenju uporabnika. Te izboljšave zagotavljajo brezhibno izkušnjo AR, zaradi česar sta virtualni in resnični svet resnično povezana. 🚀

Pogosta vprašanja o postavitvi MediaPipe in Unity AR

- Zakaj moja virtualna glava ni poravnana s pravim obrazom?

- Težava pogosto izvira iz nepravilne kalibracije kamere. Uporaba orodij, kot je OpenCV za izračun camera matrix in distortion coefficients lahko močno izboljša poravnavo.

- Kakšna je vloga goriščne razdalje pri poravnavi AR?

- The focal length določa, kako kamera projicira 3D točke na 2D ravnino. Če ga prilagodite v nastavitvah fizične kamere Unity, lahko povečate natančnost.

- Ali lahko Unity obravnava popravek popačenja leče?

- Da, Unity podpira senčnike za popravljanje popačenja. Implementirajte senčnik z lastnostmi, kot je _DistortionStrength za prilagajanje popravkov glede na profil vašega objektiva.

- Kako lahko preizkusim poravnavo virtualnih predmetov?

- Uporaba testov enote v NUnit z ukazi, kot je Assert.AreEqual omogoča preverjanje položaja in rotacije virtualnih objektov pod različnimi pogoji.

- Ali je za projekte AR potrebna naknadna obdelava?

- Čeprav ni obvezno, učinki naknadne obdelave, kot so depth of field in chromatic aberration lahko izboljša vizualno kakovost in realističnost prizorov AR.

- Ali lahko MediaPipe zazna predmete, ki niso obrazi?

- Da, MediaPipe ponuja rešitve za roke, pozo in celo celostno sledenje, zaradi česar je vsestranski za različne primere uporabe AR.

- Katera strojna oprema najbolje deluje za aplikacije Unity AR?

- Naprave z visoko zmogljivimi grafičnimi procesorji in natančnimi kamerami so idealne. Orodja kot ARCore in ARKit dodatno povečati združljivost.

- Zakaj je poravnava pod določenimi koti slabša?

- To je lahko posledica neusklajenosti vidnega polja med kamero in virtualnim okoljem. Prilagoditev kamer Unity fieldOfView lastnina lahko pomaga.

- Kako senčniki izboljšajo poravnavo AR?

- Senčniki omogočajo prilagajanje upodabljanja v realnem času, kot je popravljanje popačenj ali simulacija učinkov leč, kar zagotavlja boljšo sinhronizacijo med virtualnimi in resničnimi objekti.

- Ali se lahko sistemi AR sčasoma prilagodijo?

- Da, integracija modelov strojnega učenja omogoča sistemom dinamično prilagajanje, učenje iz povratnih informacij za izboljšanje usklajevanja in učinkovitosti skozi čas.

Izboljšanje natančnosti AR: zadnje misli

Doseganje natančne poravnave med predmeti virtualnega in resničnega sveta je ključnega pomena za poglobljene izkušnje AR. S skrbno kalibracijo in naprednimi tehnikami je mogoče ublažiti težave, kot so popačenje leče in neusklajene goriščne razdalje, kar zagotavlja večjo natančnost in zadovoljstvo uporabnikov.

Integracija orodij Unity, algoritmov MediaPipe in dinamičnih prilagoditev ponuja robustne rešitve za razvijalce AR. Te izboljšave omogočajo brezhibno mešanico digitalnega in fizičnega sveta, odklepanje novih možnosti za igranje iger, virtualna srečanja in več. Z vztrajnostjo in inovativnostjo postanejo izzivi prilagajanja AR obvladljivi. 🚀

Viri in reference

- Podrobnosti o uporabi MediaPipe v Unity so navedene v uradni dokumentaciji MediaPipe. Raziščite ga tukaj .

- Navodila za kalibracijo kamere Unity in fizične lastnosti so na voljo na dokumentacijskem mestu Unity. Obisk Nastavitve kamere Unity za več podrobnosti.

- Programiranje senčil za aplikacije AR in popravljanje popačenj leče so navdihnili članki o razvoju senčil, kot so tisti na Mačje kodiranje .

- Zmogljivosti in omejitve ARCore za razvoj Android so bile pregledane na Googlovem spletnem mestu za razvijalce ARCore. Več o tem na Google ARCore .