Проблемы с размещением виртуальных голов для разработки дополненной реальности

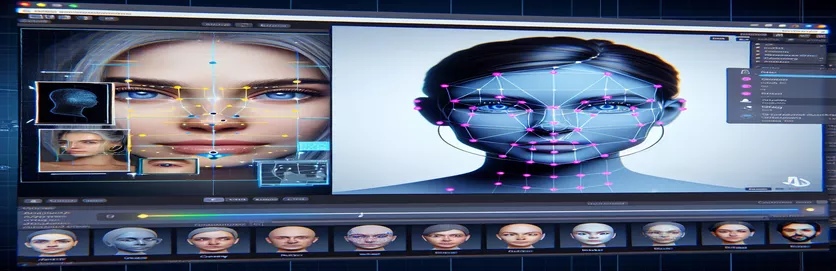

Работа над проектом дополненной реальности (AR) может быть одновременно захватывающей и сложной. Разрабатывая приложение для Android с помощью Unity, я стремился плавно объединить цифровой и реальный миры, помещая виртуальную голову поверх реальных лиц. Эта функция во многом зависит от точности для создания эффекта погружения. 🕶️

Для этого я использовал MediaPipe от Google для обнаружения ориентиров на лице, таких как глаза, нос и рот. Затем виртуальная голова была создана и размещена на основе этих ключевых точек. Было интересно наблюдать, как современные инструменты могут трансформировать возможности дополненной реальности, но путь был далек от совершенства.

Проблема возникла, когда виртуальная голова не совпадала с реальным лицом, как ожидалось. Независимо от угла или устройства, расположение всегда было немного «неправильным», что приводило к неестественному эффекту. Виртуальное представление как будто было оторвано от реальности. Это вызвало серию экспериментов по устранению неполадок.

От настройки параметров камеры Unity до экспериментов с алгоритмом MediaPipe — каждая попытка приносила постепенные улучшения, но не давала окончательного решения. В этой статье рассматривается суть проблемы, извлеченные уроки и потенциальные решения для разработчиков, сталкивающихся с аналогичными проблемами. 🚀

| Команда | Пример использования |

|---|---|

| mainCamera.usePhysicalProperties | Эта команда позволяет использовать физические свойства камеры Unity, позволяя более точно контролировать фокусное расстояние и искажения объектива для выравнивания виртуальных и реальных объектов. |

| faceMesh.GetDetectedFaceTransform() | Извлекает данные преобразования (положение и поворот) обнаруженного лица из сетки лица MediaPipe, что имеет решающее значение для точного размещения виртуальных голов над реальными лицами. |

| UnityObjectToClipPos | Функция, специфичная для шейдера, которая преобразует положение вершин из пространства объекта в пространство отсечения, используемая в шейдерах коррекции искажений линзы для обеспечения выравнивания. |

| tex2D | Команда шейдера, используемая для выборки текстуры по указанным UV-координатам, необходимая для применения коррекции искажений к изображениям с камеры. |

| length(distUV) | Вычисляет евклидово расстояние UV-координат от начала координат, которое используется для применения постепенной корректировки искажений линзы. |

| adjuster.virtualHead | Переменная сценария, ссылающаяся на игровой объект виртуальной головы, позволяющая динамически обновлять его положение и вращение на основе данных отслеживания лица. |

| [TestFixture] | Атрибут NUnit, который помечает класс как тестовое приспособление, сигнализируя о том, что он содержит модульные тесты. Это полезно для проверки логики выравнивания виртуальной головки. |

| Assert.AreEqual | Метод NUnit, используемый для сравнения ожидаемых и фактических значений во время модульного тестирования, гарантируя, что размещение виртуальной головки соответствует желаемым результатам. |

| _DistortionStrength | Свойство шейдера, которое регулирует интенсивность искажения объектива, точно настраивая соответствие между реальным и виртуальным мирами. |

| Quaternion.Euler | Создает вращение на основе углов Эйлера, обычно используемых для выравнивания объектов, таких как виртуальная голова, в трехмерном пространстве Unity. |

Повышение точности AR с помощью Unity и MediaPipe

Первый сценарий, который мы рассмотрели, фокусируется на использовании свойств физической камеры Unity. Включив использовать физические свойства, мы настраиваем поведение камеры, чтобы оно более точно соответствовало реальной оптике. Это особенно важно при работе с дополненной реальностью, где даже небольшие расхождения в фокусном расстоянии или поле зрения могут привести к смещению виртуальных объектов. Например, установка точного значения фокусного расстояния, например 35 мм, может помочь совместить виртуальную голову с обнаруженным лицом. Эта настройка аналогична точной настройке телескопа для идеальной фокусировки удаленных объектов, обеспечивая естественность и эффект присутствия в дополненной реальности. 📸

Еще одним важным компонентом скрипта является получение положения и поворота обнаруженного лица с помощью faceMesh.GetDetectedFaceTransform(). Эта функция обеспечивает обновления в реальном времени из сетки лица MediaPipe, что важно для синхронизации виртуальной головы с движениями пользователя. Представьте себе, что вы играете в видеоигру, в которой голова вашего персонажа не движется синхронно с вашей; этот опыт будет неприятным. Обеспечивая точное выравнивание, этот сценарий превращает AR из новинки в инструмент, который может поддерживать такие приложения, как виртуальные встречи или продвинутые игры.

Второй скрипт углубляется в программирование шейдеров, в частности, устраняя искажения объектива. Шейдер исправляет искажения в изображении камеры, используя такие свойства, как _DistortionStrength, для управления тем, как UV-координаты отображаются на текстуру. Это особенно полезно при работе с широкоугольными объективами или камерами с уникальными профилями искажений. Например, если виртуальная голова кажется больше или меньше фактического лица в зависимости от угла, настройка параметров искажения обеспечит лучшее выравнивание. Это похоже на настройку рамы зеркала, чтобы устранить эффект «фанхауса» и сделать отражения более реалистичными. 🎨

Наконец, модульные тесты из третьего сценария проверяют решения. Эти тесты сравнивают ожидаемое положение и вращение виртуальной головы с фактическими результатами, гарантируя, что настройки сохранятся в различных условиях. Использование NUnit Assert.AreEqual, разработчики могут моделировать различные сценарии, например быстрое движение головы или наклон ее под сильным углом, чтобы подтвердить выравнивание. Например, во время разработки я заметил, что выравнивание работает хорошо, если смотреть вперед, но смещается, когда голова поворачивается в сторону. Эти модульные тесты выявили проблему и послужили руководством для дальнейших улучшений, подчеркивая важность тщательного тестирования при создании надежных AR-приложений. 🚀

Настройка размещения виртуальных объектов в AR с помощью Unity и MediaPipe

Решение 1. Использование физической камеры Unity для настройки угла обзора и искажений объектива

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Изучение альтернативных настроек виртуального выравнивания головы

Решение 2. Использование специального шейдера для исправления искажений объектива

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Тестирование расширенной совместимости в AR-проектах Unity

Решение 3. Внедрение модульных тестов для виртуального выравнивания головок

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Уточнение размещения AR с помощью усовершенствованных методов калибровки

Одним из часто упускаемых из виду аспектов проблем выравнивания AR является важность калибровки камеры. В проектах AR, таких как размещение виртуальной головы над реальной, объектив внутренние параметры играют жизненно важную роль. К этим параметрам относятся фокусное расстояние, оптический центр и коэффициенты дисторсии. Если эти значения неточны, виртуальная голова может выглядеть смещенной или искаженной. Чтобы решить эту проблему, можно использовать инструменты калибровки для расчета этих параметров для камеры конкретного устройства. Например, такое программное обеспечение, как OpenCV, предлагает надежные утилиты калибровки для создания точных матриц камер и профилей искажений. 📐

Другой подход предполагает использование возможностей Unity. стек постобработки. Применяя такие эффекты, как глубина резкости или коррекция хроматических аберраций, вы можете сгладить несоответствия между визуализированной виртуальной головой и реальной средой. Постобработка добавляет слой полировки, который устраняет разрыв между виртуальными объектами и физическими пространствами. Например, легкий эффект размытия может уменьшить резкие края, которые делают заметными смещения. Это особенно полезно в иммерсивных приложениях, где пользователи сильно сосредоточены на сцене.

Наконец, не стоит недооценивать силу динамической адаптации во время выполнения. Включение моделей машинного обучения в ваш конвейер AR может позволить системе учиться и корректировать размещение с течением времени. Например, модель искусственного интеллекта может анализировать отзывы пользователей или обнаруживать несоответствия и динамически настраивать согласование. Это делает систему более надежной и способной справляться с изменениями в освещении, производительности устройства или поведении пользователя. Эти улучшения обеспечивают беспрепятственный опыт работы с дополненной реальностью, благодаря чему виртуальный и реальный миры кажутся по-настоящему интегрированными. 🚀

Общие вопросы о MediaPipe и Unity AR Placement

- Почему моя виртуальная голова не совпадает с реальным лицом?

- Проблема часто возникает из-за неправильной калибровки камеры. Использование таких инструментов, как OpenCV, для расчета camera matrix и distortion coefficients может значительно улучшить выравнивание.

- Какова роль фокусного расстояния в выравнивании AR?

- focal length определяет, как камера проецирует 3D-точки на 2D-плоскость. Настройка его в настройках физической камеры Unity может повысить точность.

- Может ли Unity справиться с коррекцией искажений объектива?

- Да, Unity поддерживает шейдеры для коррекции искажений. Реализуйте шейдер с такими свойствами, как _DistortionStrength для настройки коррекций на основе профиля вашего объектива.

- Как я могу проверить выравнивание виртуальных объектов?

- Использование модульных тестов в NUnit с такими командами, как Assert.AreEqual позволяет проверять позиционирование и вращение виртуальных объектов в различных условиях.

- Нужна ли постобработка для проектов AR?

- Хотя это не обязательно, эффекты постобработки, такие как depth of field и chromatic aberration может улучшить визуальное качество и реалистичность сцен AR.

- Может ли MediaPipe обнаруживать объекты, кроме лиц?

- Да, MediaPipe предлагает решения для рук, позы и даже целостного отслеживания, что делает его универсальным для различных случаев использования AR.

- Какое оборудование лучше всего подходит для приложений Unity AR?

- Устройства с высокопроизводительными графическими процессорами и точными камерами идеальны. Такие инструменты, как ARCore и ARKit дальнейшее улучшение совместимости.

- Почему выравнивание хуже под определенными углами?

- Это может быть связано с несоответствием поля зрения камеры и виртуальной среды. Настройка камеры Unity fieldOfView недвижимость может помочь.

- Как шейдеры улучшают выравнивание AR?

- Шейдеры позволяют в реальном времени корректировать рендеринг, например исправлять искажения или моделировать эффекты линз, обеспечивая лучшую синхронизацию между виртуальными и реальными объектами.

- Могут ли AR-системы самонастраиваться со временем?

- Да, интеграция моделей машинного обучения позволяет системам динамически адаптироваться, обучаясь на основе обратной связи, чтобы со временем улучшить согласованность и производительность.

Повышение точности AR: заключительные мысли

Достижение точного соответствия между виртуальными и реальными объектами имеет решающее значение для иммерсивного опыта дополненной реальности. Благодаря тщательной калибровке и передовым технологиям можно устранить такие проблемы, как искажение объектива и несовпадение фокусных расстояний, обеспечивая более высокую точность и удовлетворенность пользователей.

Интеграция инструментов Unity, алгоритмов MediaPipe и динамических настроек предлагает надежные решения для разработчиков AR. Эти улучшения обеспечивают плавное сочетание цифрового и физического миров, открывая новые возможности для игр, виртуальных встреч и многого другого. Благодаря настойчивости и инновациям проблемы согласования AR становятся управляемыми. 🚀

Источники и ссылки

- Подробности об использовании MediaPipe в Unity взяты из официальной документации MediaPipe. Исследуйте это здесь .

- Руководство по калибровке и физическим свойствам камеры Unity можно найти на сайте документации Unity. Посещать Настройки камеры Unity для более подробной информации.

- Программирование шейдеров для приложений AR и коррекция искажений объектива были вдохновлены статьями о разработке шейдеров, например, на Кошачье кодирование .

- Возможности и ограничения ARCore для разработки под Android были рассмотрены на сайте разработчиков Google ARCore. Узнайте больше на Google ARCore .