Provocări în plasarea capului virtual pentru dezvoltarea AR

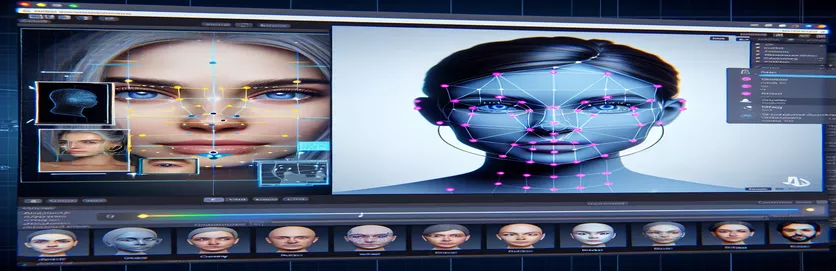

Lucrul la un proiect de realitate augmentată (AR) poate fi atât interesant, cât și provocator. Când am dezvoltat o aplicație Android cu Unity, mi-am propus să îmbin perfect lumea digitală și cea reală, plasând un cap virtual peste fețele din lumea reală. Această caracteristică se bazează în mare măsură pe precizie pentru a crea o experiență captivantă. 🕶️

Pentru a realiza acest lucru, am folosit MediaPipe de la Google pentru a detecta repere faciale, cum ar fi ochii, nasul și gura. Capul virtual a fost apoi generat și plasat pe baza acestor puncte cheie. A fost fascinant să vezi cum instrumentele moderne ar putea transforma posibilitățile AR, dar călătoria a fost departe de a fi perfectă.

Problema a apărut atunci când capul virtual nu s-a aliniat cu fața reală așa cum era de așteptat. Indiferent de unghi sau dispozitiv, plasarea a fost întotdeauna puțin „dezactivată”, ceea ce duce la un efect nenatural. Era ca și cum reprezentarea virtuală era deconectată de realitate. Acest lucru a declanșat o serie de experimente de depanare.

De la modificarea setărilor camerei Unity până la experimentarea cu algoritmul MediaPipe, fiecare încercare a adus îmbunătățiri progresive, dar nicio soluție definitivă. Acest articol analizează miezul problemei, lecțiile învățate și soluțiile potențiale pentru dezvoltatorii care se confruntă cu provocări similare. 🚀

| Comanda | Exemplu de utilizare |

|---|---|

| mainCamera.usePhysicalProperties | Această comandă permite utilizarea proprietăților fizice ale camerei Unity, permițând un control mai precis asupra distanței focale și a distorsiunii lentilelor pentru a alinia obiectele virtuale și cele din lumea reală. |

| faceMesh.GetDetectedFaceTransform() | Preia datele de transformare (poziție și rotație) ale unei fețe detectate din rețeaua feței MediaPipe, crucială pentru plasarea cu precizie a capetelor virtuale peste fețele reale. |

| UnityObjectToClipPos | O funcție specifică shader-ului care transformă o poziție de vârf din spațiul obiectului în spațiul de clip, utilizată în shader-urile de corectare a distorsiunii lentilelor pentru a asigura alinierea. |

| tex2D | O comandă de umbrire utilizată pentru a eșantiona o textură la coordonatele UV specificate, esențială pentru aplicarea corecției distorsiunii fluxurilor camerei. |

| length(distUV) | Calculează distanța euclidiană a coordonatelor UV de la origine, care este utilizată pentru a aplica ajustări graduale ale distorsiunii lentilei. |

| adjuster.virtualHead | O variabilă de script care se referă la capul virtual GameObject, permițând actualizarea dinamică a poziției și rotației acestuia pe baza datelor de urmărire a feței. |

| [TestFixture] | Un atribut NUnit care marchează o clasă ca dispozitiv de testare, semnalând că conține teste unitare. Acest lucru este util pentru verificarea logicii de aliniere a capului virtual. |

| Assert.AreEqual | O metodă NUnit utilizată pentru a compara valorile așteptate și reale în timpul testării unitare, asigurând că plasarea capului virtual se potrivește cu rezultatele dorite. |

| _DistortionStrength | O proprietate de umbrire care ajustează intensitatea distorsiunii lentilei, reglând fin alinierea dintre lumea reală și cea virtuală. |

| Quaternion.Euler | Creează o rotație bazată pe unghiurile Euler, utilizate în mod obișnuit pentru alinierea obiectelor precum capul virtual în spațiul 3D al Unity. |

Îmbunătățirea preciziei AR cu Unity și MediaPipe

Primul script pe care l-am explorat se concentrează pe utilizarea proprietăților fizice ale camerei Unity. Prin activare utilizațiPhysicalProperties, ajustăm comportamentul camerei pentru a se potrivi mai îndeaproape cu optica din lumea reală. Acest lucru este deosebit de important atunci când lucrați cu AR, unde chiar și discrepanțe ușoare ale distanței focale sau câmpului vizual pot face obiectele virtuale să pară nealiniate. De exemplu, setarea distanței focale la o valoare precisă, cum ar fi 35 mm, poate ajuta la alinierea capului virtual cu fața detectată. Această ajustare este asemănătoare cu reglarea fină a telescopului pentru a aduce obiectele îndepărtate într-o focalizare perfectă, asigurându-se că experiența AR se simte naturală și captivantă. 📸

O altă componentă crucială a scriptului este preluarea poziției și rotația feței detectate folosind faceMesh.GetDetectedFaceTransform(). Această funcție oferă actualizări în timp real din rețeaua facială MediaPipe, care este esențială pentru sincronizarea capului virtual cu mișcările utilizatorului. Imaginează-ți jocul video în care capul personajului tău nu se mișcă sincronizat cu al tău; experiența ar fi tulburătoare. Asigurând o aliniere precisă, acest script transformă AR dintr-o noutate într-un instrument care poate sprijini aplicații precum întâlniri virtuale sau jocuri avansate.

Al doilea script se aprofundează în programarea shaderului, abordând în special distorsiunea lentilelor. Shader-ul corectează distorsiunile din fluxul camerei, folosind proprietăți precum _DistortionStrength pentru a manipula modul în care coordonatele UV sunt mapate pe textură. Acest lucru este deosebit de util atunci când aveți de-a face cu obiective cu unghi larg sau camere cu profiluri unice de distorsiune. De exemplu, dacă un cap virtual pare mai mare sau mai mic decât fața reală, în funcție de unghi, ajustarea setărilor de distorsiune asigură o aliniere mai bună. Este ca și cum ai ajusta cadrul unei oglinzi pentru a elimina efectul de distracție, făcând reflexiile mai realiste. 🎨

În cele din urmă, testele unitare din al treilea script validează soluțiile. Aceste teste compară poziția așteptată și rotația capului virtual cu rezultatele reale, asigurându-se că ajustările se mențin în diferite condiții. Folosind NUnit’s Afirmă.Sunt Egale, dezvoltatorii pot simula diferite scenarii, cum ar fi mișcarea rapidă a capului sau înclinarea lui la unghiuri extreme, pentru a confirma alinierea. De exemplu, în timpul dezvoltării, am observat că alinierea a funcționat bine când eram cu fața în față, dar s-a deplasat când capul s-a întors în lateral. Aceste teste unitare au evidențiat problema și au ghidat îmbunătățiri suplimentare, întărind importanța testării amănunțite în crearea de aplicații AR robuste. 🚀

Ajustarea plasării obiectelor virtuale în AR cu Unity și MediaPipe

Soluția 1: Utilizarea camerei fizice a Unity pentru a regla FOV și distorsiunea lentilei

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Explorarea ajustărilor alternative pentru alinierea capului virtual

Soluția 2: Utilizarea unui shader personalizat pentru a corecta distorsiunea lentilei

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testare pentru compatibilitate îmbunătățită în proiectele AR ale Unity

Soluția 3: Implementarea testelor unitare pentru alinierea capului virtual

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Rafinarea plasării AR prin tehnici de calibrare îmbunătățite

Un aspect adesea trecut cu vederea al problemelor de aliniere AR este importanța calibrării camerei. În proiectele AR, cum ar fi plasarea unui cap virtual peste unul real, al obiectivului parametrii intrinseci joacă un rol vital. Acești parametri includ distanța focală, centrul optic și coeficienții de distorsiune. Când aceste valori nu sunt exacte, capul virtual poate părea nealiniat sau distorsionat. Pentru a rezolva acest lucru, instrumentele de calibrare pot fi utilizate pentru a calcula acești parametri pentru camera specifică a dispozitivului. De exemplu, software-ul precum OpenCV oferă utilități robuste de calibrare pentru a genera matrici precise ale camerei și profiluri de distorsiune. 📐

O altă abordare implică valorificarea Unity stiva de post-procesare. Aplicând efecte cum ar fi corecțiile pentru adâncimea câmpului sau aberația cromatică, puteți elimina discrepanțele dintre capul virtual redat și mediul real. Post-procesarea adaugă un strat de lustruire care face puntea dintre obiectele virtuale și spațiile fizice. De exemplu, un efect de estompare subtil poate reduce marginile aspre care fac vizibile dezalinirile. Acest lucru este util în special în aplicațiile imersive în care utilizatorii sunt foarte concentrați pe scenă.

În cele din urmă, nu subestimați puterea adaptării dinamice în timpul rulării. Încorporarea modelelor de învățare automată în conducta AR poate permite sistemului să învețe și să ajusteze plasarea în timp. De exemplu, un model de inteligență artificială ar putea analiza feedback-ul utilizatorului sau a detecta inconsecvențele și ar putea ajusta dinamic alinierea. Acest lucru face sistemul mai robust și capabil să facă față variațiilor de iluminare, performanța dispozitivului sau comportamentul utilizatorului. Aceste îmbunătățiri asigură o experiență AR perfectă, făcând ca lumea virtuală și cea reală să se simtă cu adevărat integrate. 🚀

Întrebări frecvente despre MediaPipe și Unity AR Placement

- De ce capul meu virtual este greșit aliniat cu fața reală?

- Problema provine adesea din calibrarea necorespunzătoare a camerei. Folosind instrumente precum OpenCV pentru a calcula camera matrix şi distortion coefficients poate îmbunătăți considerabil alinierea.

- Care este rolul distanței focale în alinierea AR?

- The focal length definește modul în care camera proiectează punctele 3D pe un plan 2D. Ajustarea acestuia în setările fizice ale camerei Unity poate îmbunătăți acuratețea.

- Poate Unity să gestioneze corectarea distorsiunii lentilelor?

- Da, Unity acceptă shadere pentru corectarea distorsiunii. Implementați un shader cu proprietăți precum _DistortionStrength pentru a personaliza corecțiile în funcție de profilul obiectivului dvs.

- Cum pot testa alinierea obiectelor virtuale?

- Utilizarea testelor unitare în NUnit cu comenzi precum Assert.AreEqual vă permite să validați poziționarea și rotirea obiectelor virtuale în diferite condiții.

- Este necesară post-procesarea pentru proiectele AR?

- Deși nu este obligatoriu, efectele de post-procesare cum ar fi depth of field şi chromatic aberration poate îmbunătăți calitatea vizuală și realismul scenelor AR.

- Poate MediaPipe să detecteze alte obiecte decât fețele?

- Da, MediaPipe oferă soluții pentru mâini, poziție și chiar urmărire holistică, făcându-l versatil pentru diferite cazuri de utilizare AR.

- Ce hardware funcționează cel mai bine pentru aplicațiile Unity AR?

- Dispozitivele cu GPU de înaltă performanță și camere precise sunt ideale. Instrumente ca ARCore şi ARKit sporește și mai mult compatibilitatea.

- De ce este alinierea mai proastă la anumite unghiuri?

- Acest lucru s-ar putea datora unei nepotriviri în câmpul vizual dintre cameră și mediul virtual. Reglarea camerei Unity fieldOfView proprietatea poate ajuta.

- Cum îmbunătățesc shaders-urile alinierea AR?

- Umbritoarele permit ajustări în timp real ale randării, cum ar fi corectarea distorsiunilor sau simularea efectelor lentilelor, asigurând o mai bună sincronizare între obiectele virtuale și reale.

- Sistemele AR se pot autoajusta în timp?

- Da, integrarea modelelor de învățare automată permite sistemelor să se adapteze dinamic, învățând din feedback pentru a îmbunătăți alinierea și performanța în timp.

Îmbunătățirea preciziei AR: gânduri finale

Obținerea alinierii precise între obiectele virtuale și cele din lumea reală este crucială pentru experiențele AR captivante. Prin calibrare atentă și tehnici avansate, probleme precum distorsiunea lentilelor și distanța focală nepotrivită pot fi atenuate, asigurând o mai bună acuratețe și satisfacție a utilizatorului.

Integrarea instrumentelor Unity, a algoritmilor MediaPipe și a ajustărilor dinamice oferă soluții robuste pentru dezvoltatorii AR. Aceste îmbunătățiri permit un amestec perfect de lumi digitale și fizice, deblocând noi posibilități pentru jocuri, întâlniri virtuale și nu numai. Cu persistență și inovație, provocările de aliniere AR devin gestionabile. 🚀

Surse și referințe

- Detaliile despre utilizarea MediaPipe în Unity au fost menționate din documentația oficială MediaPipe. Explorează-l Aici .

- Îndrumări privind calibrarea camerei Unity și proprietățile fizice pot fi găsite pe site-ul de documentație al Unity. Vizita Setările camerei Unity pentru mai multe detalii.

- Programarea shader pentru aplicații AR și corectarea distorsiunii lentilelor a fost inspirată din articolele despre dezvoltarea shaderului, cum ar fi cele de pe Codare asemănătoare pisicilor .

- Capacitățile și limitările ARCore pentru dezvoltarea Android au fost examinate de pe site-ul pentru dezvoltatori ARCore de la Google. Aflați mai multe la Google ARCore .