Desafios no posicionamento virtual da cabeça para desenvolvimento de AR

Trabalhar em um projeto de realidade aumentada (AR) pode ser emocionante e desafiador. Ao desenvolver um aplicativo Android com Unity, pretendi combinar perfeitamente os mundos digital e real, colocando uma cabeça virtual sobre rostos do mundo real. Esse recurso depende muito da precisão para criar uma experiência envolvente. 🕶️

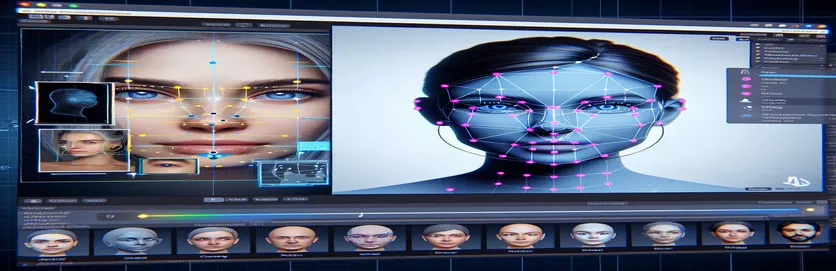

Para conseguir isso, utilizei o MediaPipe do Google para detectar pontos de referência faciais como olhos, narizes e bocas. A cabeça virtual foi então gerada e posicionada com base nesses pontos-chave. Foi fascinante ver como as ferramentas modernas poderiam transformar as possibilidades de RA, mas a jornada estava longe de ser perfeita.

O problema surgiu quando a cabeça virtual não se alinhou com o rosto real conforme esperado. Não importa o ângulo ou dispositivo, o posicionamento sempre ficava um pouco “errado”, levando a um efeito não natural. Era como se a representação virtual estivesse desligada da realidade. Isso desencadeou uma série de experimentos de solução de problemas.

Desde ajustes nas configurações da câmera do Unity até experiências com o algoritmo do MediaPipe, todas as tentativas trouxeram melhorias incrementais, mas nenhuma solução definitiva. Este artigo se aprofunda no cerne do problema, nas lições aprendidas e nas possíveis soluções para desenvolvedores que enfrentam desafios semelhantes. 🚀

| Comando | Exemplo de uso |

|---|---|

| mainCamera.usePhysicalProperties | Este comando permite o uso das propriedades físicas da câmera do Unity, permitindo um controle mais preciso sobre a distância focal e a distorção da lente para alinhar objetos virtuais e do mundo real. |

| faceMesh.GetDetectedFaceTransform() | Recupera os dados de transformação (posição e rotação) de uma face detectada da malha facial do MediaPipe, crucial para posicionar cabeças virtuais com precisão sobre faces reais. |

| UnityObjectToClipPos | Uma função específica do sombreador que transforma uma posição de vértice do espaço do objeto para o espaço do clipe, usada em sombreadores de correção de distorção de lente para garantir o alinhamento. |

| tex2D | Um comando de sombreador usado para amostrar uma textura em coordenadas UV especificadas, essencial para aplicar correção de distorção nas imagens da câmera. |

| length(distUV) | Calcula a distância euclidiana das coordenadas UV da origem, que é aproveitada para aplicar ajustes graduais de distorção da lente. |

| adjuster.virtualHead | Uma variável de script referente ao GameObject da cabeça virtual, permitindo que sua posição e rotação sejam atualizadas dinamicamente com base nos dados de rastreamento facial. |

| [TestFixture] | Um atributo NUnit que marca uma classe como um acessório de teste, sinalizando que ela contém testes unitários. Isto é útil para verificar a lógica de alinhamento da cabeça virtual. |

| Assert.AreEqual | Um método NUnit usado para comparar valores esperados e reais durante testes de unidade, garantindo que o posicionamento do cabeçote virtual corresponda aos resultados desejados. |

| _DistortionStrength | Uma propriedade de sombreamento que ajusta a intensidade da distorção da lente, ajustando o alinhamento entre os mundos real e virtual. |

| Quaternion.Euler | Cria uma rotação baseada em ângulos de Euler, comumente usados para alinhar objetos como a cabeça virtual no espaço 3D do Unity. |

Aprimorando a precisão da AR com Unity e MediaPipe

O primeiro script que exploramos concentra-se no uso das propriedades físicas da câmera do Unity. Ao ativar usePhysicalProperties, ajustamos o comportamento da câmera para corresponder melhor à óptica do mundo real. Isto é particularmente importante ao trabalhar com AR, onde mesmo pequenas discrepâncias na distância focal ou no campo de visão podem fazer com que os objetos virtuais pareçam desalinhados. Por exemplo, definir a distância focal para um valor preciso como 35 mm pode ajudar a alinhar a cabeça virtual com o rosto detectado. Este ajuste é semelhante ao ajuste fino de um telescópio para trazer objetos distantes para um foco perfeito, garantindo que a experiência AR pareça natural e envolvente. 📸

Outro componente crucial do script é recuperar a posição e rotação do rosto detectado usando faceMesh.GetDetectedFaceTransform(). Esta função fornece atualizações em tempo real da malha facial do MediaPipe, essencial para sincronizar a cabeça virtual com os movimentos do usuário. Imagine jogar um videogame onde a cabeça do seu personagem não se move em sincronia com a sua; a experiência seria chocante. Ao garantir um alinhamento preciso, esse script transforma a AR de uma novidade em uma ferramenta que pode oferecer suporte a aplicações como reuniões virtuais ou jogos avançados.

O segundo script se aprofunda na programação de shaders, abordando especificamente a distorção da lente. O shader corrige distorções na imagem da câmera, usando propriedades como _DistortionStrength para manipular como as coordenadas UV são mapeadas na textura. Isto é particularmente útil ao lidar com lentes grande angulares ou câmeras com perfis de distorção exclusivos. Por exemplo, se uma cabeça virtual parecer maior ou menor que a face real dependendo do ângulo, ajustar as configurações de distorção garante um melhor alinhamento. É como ajustar a moldura de um espelho para eliminar o efeito de casa de diversões, tornando os reflexos mais realistas. 🎨

Por fim, os testes unitários do terceiro script validam as soluções. Esses testes comparam a posição e a rotação esperadas da cabeça virtual com os resultados reais, garantindo que os ajustes sejam mantidos sob diversas condições. Usando NUnit's Afirmar.AreEqual, os desenvolvedores podem simular diferentes cenários, como mover a cabeça rapidamente ou incliná-la em ângulos extremos, para confirmar o alinhamento. Por exemplo, durante o desenvolvimento, notei que o alinhamento funcionava bem ao olhar para frente, mas oscilava quando a cabeça virava para o lado. Esses testes unitários destacaram o problema e orientaram melhorias adicionais, reforçando a importância de testes completos na criação de aplicações robustas de AR. 🚀

Ajustando o posicionamento de objetos virtuais em AR com Unity e MediaPipe

Solução 1: usando a câmera física do Unity para ajustar o FOV e a distorção da lente

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Explorando ajustes alternativos para alinhamento virtual da cabeça

Solução 2: usando um shader personalizado para corrigir a distorção da lente

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Teste de compatibilidade aprimorada em projetos de AR do Unity

Solução 3: Implementando testes de unidade para alinhamento de cabeça virtual

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Refinando a colocação de AR por meio de técnicas de calibração aprimoradas

Um aspecto frequentemente esquecido dos problemas de alinhamento de AR é a importância da calibração da câmera. Em projetos de AR, como colocar uma cabeça virtual sobre uma real, a lente parâmetros intrínsecos desempenhar um papel vital. Esses parâmetros incluem a distância focal, o centro óptico e os coeficientes de distorção. Quando esses valores não são precisos, o cabeçote virtual pode parecer desalinhado ou distorcido. Para resolver isso, ferramentas de calibração podem ser usadas para calcular esses parâmetros para a câmera do dispositivo específico. Por exemplo, softwares como o OpenCV oferecem utilitários de calibração robustos para gerar matrizes de câmeras e perfis de distorção precisos. 📐

Outra abordagem envolve aproveitar o Unity pilha de pós-processamento. Ao aplicar efeitos como profundidade de campo ou correções de aberração cromática, você pode suavizar as discrepâncias entre a cabeça virtual renderizada e o ambiente do mundo real. O pós-processamento adiciona uma camada de polimento que preenche a lacuna entre objetos virtuais e espaços físicos. Por exemplo, um efeito de desfoque sutil pode reduzir as bordas nítidas que tornam os desalinhamentos perceptíveis. Isto é especialmente útil em aplicações imersivas onde os usuários estão altamente focados na cena.

Finalmente, não subestime o poder da adaptação dinâmica durante o tempo de execução. A incorporação de modelos de aprendizado de máquina em seu pipeline de AR pode permitir que o sistema aprenda e ajuste o posicionamento ao longo do tempo. Por exemplo, um modelo de IA poderia analisar o feedback do usuário ou detectar inconsistências e ajustar o alinhamento dinamicamente. Isso torna o sistema mais robusto e capaz de lidar com variações de iluminação, desempenho do dispositivo ou comportamento do usuário. Essas melhorias garantem uma experiência de AR perfeita, fazendo com que os mundos virtual e real pareçam verdadeiramente integrados. 🚀

Perguntas comuns sobre posicionamento de MediaPipe e Unity AR

- Por que minha cabeça virtual está desalinhada com a face real?

- O problema geralmente decorre da calibração inadequada da câmera. Usando ferramentas como OpenCV para calcular o camera matrix e distortion coefficients pode melhorar muito o alinhamento.

- Qual é o papel da distância focal no alinhamento AR?

- O focal length define como a câmera projeta pontos 3D em um plano 2D. Ajustá-lo nas configurações físicas da câmera do Unity pode aumentar a precisão.

- O Unity pode lidar com a correção de distorção da lente?

- Sim, o Unity oferece suporte a shaders para correção de distorção. Implemente um shader com propriedades como _DistortionStrength para personalizar as correções com base no perfil da sua lente.

- Como posso testar o alinhamento de objetos virtuais?

- Usando testes de unidade no NUnit com comandos como Assert.AreEqual permite validar o posicionamento e rotação de objetos virtuais sob diversas condições.

- O pós-processamento é necessário para projetos de AR?

- Embora não seja obrigatório, efeitos de pós-processamento como depth of field e chromatic aberration pode melhorar a qualidade visual e o realismo das cenas AR.

- O MediaPipe pode detectar outros objetos além de rostos?

- Sim, o MediaPipe oferece soluções para mãos, poses e até mesmo rastreamento holístico, tornando-o versátil para diferentes casos de uso de AR.

- Qual hardware funciona melhor para aplicativos Unity AR?

- Dispositivos com GPUs de alto desempenho e câmeras precisas são ideais. Ferramentas como ARCore e ARKit melhorar ainda mais a compatibilidade.

- Por que o alinhamento é pior em certos ângulos?

- Isto pode ser devido a uma incompatibilidade no campo de visão entre a câmera e o ambiente virtual. Ajustando a câmera Unity fieldOfView propriedade pode ajudar.

- Como os shaders melhoram o alinhamento AR?

- Os shaders permitem ajustes em tempo real na renderização, como correção de distorções ou simulação de efeitos de lente, garantindo melhor sincronização entre objetos virtuais e reais.

- Os sistemas AR podem se ajustar automaticamente ao longo do tempo?

- Sim, a integração de modelos de aprendizado de máquina permite que os sistemas se adaptem dinamicamente, aprendendo com o feedback para melhorar o alinhamento e o desempenho ao longo do tempo.

Melhorando a precisão da AR: considerações finais

Alcançar o alinhamento preciso entre objetos virtuais e do mundo real é crucial para experiências imersivas de AR. Através de calibração cuidadosa e técnicas avançadas, problemas como distorção da lente e distâncias focais incompatíveis podem ser atenuados, garantindo melhor precisão e satisfação do usuário.

A integração das ferramentas do Unity, algoritmos MediaPipe e ajustes dinâmicos oferece soluções robustas para desenvolvedores de AR. Essas melhorias permitem uma combinação perfeita de mundos digital e físico, abrindo novas possibilidades para jogos, reuniões virtuais e muito mais. Com persistência e inovação, os desafios de alinhamento de AR tornam-se administráveis. 🚀

Fontes e Referências

- Detalhes sobre o uso do MediaPipe no Unity foram referenciados na documentação oficial do MediaPipe. Explore-o aqui .

- Orientações sobre a calibração da câmera e as propriedades físicas do Unity podem ser encontradas no site de documentação do Unity. Visite Configurações da câmera Unity para mais detalhes.

- A programação de shaders para aplicações de AR e correção de distorção de lentes foi inspirada em artigos sobre desenvolvimento de shaders, como aqueles em Codificação felina .

- Os recursos e limitações do ARCore para desenvolvimento Android foram revisados no site de desenvolvedores ARCore do Google. Saiba mais em Google ARCore .