Uitdagingen bij virtuele hoofdplaatsing voor AR-ontwikkeling

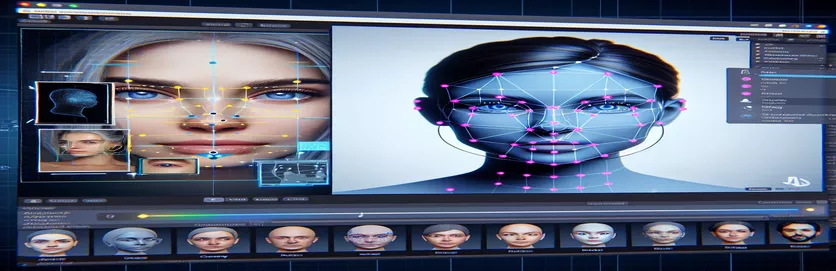

Werken aan een augmented reality (AR)-project kan zowel spannend als uitdagend zijn. Bij het ontwikkelen van een Android-applicatie met Unity wilde ik de digitale en echte wereld naadloos laten samensmelten door een virtueel hoofd over echte gezichten te plaatsen. Deze functie is sterk afhankelijk van precisie om een meeslepende ervaring te creëren. 🕶️

Om dit te bereiken heb ik MediaPipe van Google gebruikt om gezichtsherkenningspunten zoals ogen, neuzen en monden te detecteren. Op basis van deze kernpunten werd vervolgens het virtuele hoofd gegenereerd en geplaatst. Het was fascinerend om te zien hoe moderne tools AR-mogelijkheden konden transformeren, maar de reis was verre van perfect.

Het probleem ontstond toen het virtuele hoofd niet zoals verwacht op één lijn lag met het werkelijke gezicht. Ongeacht de hoek of het apparaat, de plaatsing was altijd een beetje "afwijkend", wat tot een onnatuurlijk effect leidde. Het was alsof de virtuele representatie losgekoppeld was van de werkelijkheid. Dit leidde tot een reeks experimenten voor het oplossen van problemen.

Van het aanpassen van de camera-instellingen van Unity tot het experimenteren met het algoritme van MediaPipe: elke poging bracht stapsgewijze verbeteringen met zich mee, maar geen definitieve oplossing. Dit artikel duikt in de kern van het probleem, de geleerde lessen en mogelijke oplossingen voor ontwikkelaars die met soortgelijke uitdagingen worden geconfronteerd. 🚀

| Commando | Voorbeeld van gebruik |

|---|---|

| mainCamera.usePhysicalProperties | Deze opdracht maakt het gebruik van de fysieke camera-eigenschappen van Unity mogelijk, waardoor een nauwkeurigere controle over de brandpuntsafstand en lensvervorming mogelijk is om virtuele en echte objecten uit te lijnen. |

| faceMesh.GetDetectedFaceTransform() | Haalt de transformatiegegevens (positie en rotatie) van een gedetecteerd gezicht op uit MediaPipe's gezichtsmesh, cruciaal voor het nauwkeurig plaatsen van virtuele hoofden over echte gezichten. |

| UnityObjectToClipPos | Een shader-specifieke functie die een hoekpuntpositie transformeert van objectruimte naar clipruimte, gebruikt in lensvervormingscorrectie-shaders om uitlijning te garanderen. |

| tex2D | Een arceringsopdracht die wordt gebruikt om een textuur te bemonsteren op gespecificeerde UV-coördinaten, essentieel voor het toepassen van vervormingscorrectie op camerafeeds. |

| length(distUV) | Berekent de Euclidische afstand van UV-coördinaten vanaf de oorsprong, die wordt gebruikt om geleidelijke lensvervormingsaanpassingen toe te passen. |

| adjuster.virtualHead | Een scriptvariabele die verwijst naar het virtuele hoofd GameObject, waardoor de positie en rotatie ervan dynamisch kunnen worden bijgewerkt op basis van face-trackinggegevens. |

| [TestFixture] | Een NUnit-attribuut dat een klasse als testopstelling markeert en aangeeft dat deze unittests bevat. Dit is handig voor het verifiëren van de logica voor de uitlijning van de virtuele kop. |

| Assert.AreEqual | Een NUnit-methode die wordt gebruikt om verwachte en werkelijke waarden te vergelijken tijdens het testen van eenheden, zodat de plaatsing van de virtuele kop overeenkomt met de gewenste resultaten. |

| _DistortionStrength | Een shader-eigenschap die de intensiteit van lensvervorming aanpast, waardoor de uitlijning tussen de echte en virtuele wereld nauwkeurig wordt afgesteld. |

| Quaternion.Euler | Creëert een rotatie op basis van Euler-hoeken, die vaak worden gebruikt voor het uitlijnen van objecten zoals het virtuele hoofd in de 3D-ruimte van Unity. |

Verbetering van de AR-nauwkeurigheid met Unity en MediaPipe

Het eerste script dat we hebben onderzocht, richt zich op het gebruik van de fysieke camera-eigenschappen van Unity. Door in te schakelen gebruik fysieke eigenschappen, passen we het gedrag van de camera aan, zodat deze beter aansluit bij de optiek in de echte wereld. Dit is vooral belangrijk bij het werken met AR, waarbij zelfs kleine verschillen in brandpuntsafstand of gezichtsveld ervoor kunnen zorgen dat virtuele objecten niet goed uitgelijnd lijken. Als u bijvoorbeeld de brandpuntsafstand instelt op een nauwkeurige waarde van bijvoorbeeld 35 mm, kunt u het virtuele hoofd beter uitlijnen met het gedetecteerde gezicht. Deze aanpassing lijkt op het afstemmen van een telescoop om verre objecten perfect scherp te stellen, waardoor de AR-ervaring natuurlijk en meeslepend aanvoelt. 📸

Een ander cruciaal onderdeel van het script is het ophalen van de positie en rotatie van het gedetecteerde gezicht met behulp van faceMesh.GetDetectedFaceTransform(). Deze functie biedt realtime updates van MediaPipe's gezichtsmesh, wat essentieel is voor het synchroniseren van het virtuele hoofd met de bewegingen van de gebruiker. Stel je voor dat je een videogame speelt waarbij het hoofd van je personage niet synchroon beweegt met dat van jezelf; de ervaring zou schokkend zijn. Door te zorgen voor nauwkeurige afstemming transformeert dit script AR van een nieuwigheid in een tool die toepassingen zoals virtuele vergaderingen of geavanceerde gaming kan ondersteunen.

Het tweede script gaat dieper in op shader-programmering, waarbij specifiek lensvervorming wordt aangepakt. De arcering corrigeert vervormingen in de camerafeed, met behulp van eigenschappen als _DistortionStrength om te manipuleren hoe UV-coördinaten op de textuur worden weergegeven. Dit is vooral handig bij groothoeklenzen of camera's met unieke vervormingsprofielen. Als een virtueel hoofd bijvoorbeeld groter of kleiner lijkt dan het daadwerkelijke gezicht, afhankelijk van de hoek, zorgt het aanpassen van de vervormingsinstellingen voor een betere uitlijning. Het is alsof je het frame van een spiegel aanpast om een grappig effect te elimineren, waardoor reflecties realistischer worden. 🎨

Ten slotte valideren de unit-tests uit het derde script de oplossingen. Deze tests vergelijken de verwachte positie en rotatie van het virtuele hoofd met de werkelijke resultaten, zodat aanpassingen onder verschillende omstandigheden stand houden. Met behulp van NUnit's Beweren.Zijn gelijkkunnen ontwikkelaars verschillende scenario's simuleren, zoals het snel bewegen van het hoofd of het onder extreme hoeken kantelen, om de uitlijning te bevestigen. Tijdens de ontwikkeling merkte ik bijvoorbeeld dat de uitlijning goed werkte als ik naar voren keek, maar afdreef als het hoofd naar de zijkant draaide. Deze unit-tests brachten het probleem onder de aandacht en leidden tot verdere verbeteringen, waardoor het belang van grondig testen bij het creëren van robuuste AR-applicaties werd versterkt. 🚀

Plaatsing van virtuele objecten in AR aanpassen met Unity en MediaPipe

Oplossing 1: gebruik de fysieke camera van Unity om het gezichtsveld en de lensvervorming aan te passen

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Onderzoek naar alternatieve aanpassingen voor virtuele kopuitlijning

Oplossing 2: een aangepaste arcering gebruiken om lensvervorming te corrigeren

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testen voor verbeterde compatibiliteit in de AR-projecten van Unity

Oplossing 3: Unit-tests implementeren voor virtuele hoofduitlijning

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Verfijning van AR-plaatsing door verbeterde kalibratietechnieken

Een vaak over het hoofd gezien aspect van AR-uitlijningsproblemen is het belang van camerakalibratie. In AR-projecten zoals het plaatsen van een virtueel hoofd over een echt hoofd, dat van de lens intrinsieke parameters spelen een cruciale rol. Deze parameters omvatten de brandpuntsafstand, het optische centrum en de vervormingscoëfficiënten. Als deze waarden niet nauwkeurig zijn, kan het virtuele hoofd verkeerd uitgelijnd of vervormd lijken. Om dit aan te pakken kunnen kalibratietools worden gebruikt om deze parameters voor de specifieke apparaatcamera te berekenen. Software zoals OpenCV biedt bijvoorbeeld robuuste kalibratiehulpprogramma's om nauwkeurige cameramatrices en vervormingsprofielen te genereren. 📐

Een andere benadering omvat het benutten van die van Unity nabewerkingsstapel. Door effecten zoals scherptediepte of chromatische aberratiecorrecties toe te passen, kunt u verschillen tussen het weergegeven virtuele hoofd en de werkelijke omgeving gladstrijken. Nabewerking voegt een laagje glans toe die de kloof tussen virtuele objecten en fysieke ruimtes overbrugt. Een subtiel vervagingseffect kan bijvoorbeeld de harde randen verminderen die verkeerde uitlijningen merkbaar maken. Dit is vooral handig in meeslepende toepassingen waarbij gebruikers zeer gefocust zijn op de scène.

Onderschat ten slotte de kracht van dynamische aanpassing tijdens runtime niet. Door machine learning-modellen in uw AR-pijplijn op te nemen, kan het systeem in de loop van de tijd leren en de plaatsing aanpassen. Een AI-model kan bijvoorbeeld gebruikersfeedback of gedetecteerde inconsistenties analyseren en de afstemming dynamisch verfijnen. Dit maakt het systeem robuuster en beter in staat om te gaan met variaties in verlichting, apparaatprestaties of gebruikersgedrag. Deze verbeteringen zorgen voor een naadloze AR-ervaring, waardoor de virtuele en echte wereld echt geïntegreerd aanvoelen. 🚀

Veelgestelde vragen over MediaPipe en Unity AR-plaatsing

- Waarom is mijn virtuele hoofd niet goed uitgelijnd met het echte gezicht?

- Het probleem komt vaak voort uit onjuiste camerakalibratie. Met behulp van tools zoals OpenCV om de camera matrix En distortion coefficients kan de uitlijning aanzienlijk verbeteren.

- Wat is de rol van de brandpuntsafstand bij AR-uitlijning?

- De focal length definieert hoe de camera 3D-punten op een 2D-vlak projecteert. Door dit aan te passen in de fysieke camera-instellingen van Unity kan de nauwkeurigheid worden verbeterd.

- Kan Unity overweg met lensvervormingscorrectie?

- Ja, Unity ondersteunt shaders voor vervormingscorrectie. Implementeer een shader met eigenschappen zoals _DistortionStrength om correcties aan te passen op basis van uw lensprofiel.

- Hoe kan ik de uitlijning van virtuele objecten testen?

- Unit-tests gebruiken in NUnit met opdrachten zoals Assert.AreEqual Hiermee kunt u de positionering en rotatie van virtuele objecten onder verschillende omstandigheden valideren.

- Is nabewerking nodig voor AR-projecten?

- Hoewel dit niet verplicht is, zijn er nabewerkingseffecten zoals depth of field En chromatic aberration kan de visuele kwaliteit en het realisme van AR-scènes verbeteren.

- Kan MediaPipe andere objecten dan gezichten detecteren?

- Ja, MediaPipe biedt oplossingen voor handen, pose en zelfs holistische tracking, waardoor het veelzijdig is voor verschillende AR-gebruikssituaties.

- Welke hardware werkt het beste voor Unity AR-applicaties?

- Apparaten met krachtige GPU's en nauwkeurige camera's zijn ideaal. Gereedschappen zoals ARCore En ARKit de compatibiliteit verder verbeteren.

- Waarom is de uitlijning onder bepaalde hoeken slechter?

- Dit kan te wijten zijn aan een discrepantie in het gezichtsveld tussen de camera en de virtuele omgeving. Het afstellen van de Unity-camera's fieldOfView eigendom kan helpen.

- Hoe verbeteren shaders de uitlijning van AR?

- Shaders maken real-time aanpassingen aan de weergave mogelijk, zoals het corrigeren van vervormingen of het simuleren van lenseffecten, waardoor een betere synchronisatie tussen virtuele en echte objecten wordt gegarandeerd.

- Kunnen AR-systemen zichzelf in de loop van de tijd aanpassen?

- Ja, door het integreren van machine learning-modellen kunnen systemen zich dynamisch aanpassen en leren van feedback om de afstemming en prestaties in de loop van de tijd te verbeteren.

Verbetering van de AR-nauwkeurigheid: laatste gedachten

Het bereiken van een nauwkeurige afstemming tussen virtuele en echte objecten is cruciaal voor meeslepende AR-ervaringen. Door middel van zorgvuldige kalibratie en geavanceerde technieken kunnen problemen zoals lensvervorming en niet-overeenkomende brandpuntsafstanden worden beperkt, wat zorgt voor een betere nauwkeurigheid en gebruikerstevredenheid.

De integratie van de tools van Unity, MediaPipe-algoritmen en dynamische aanpassingen biedt robuuste oplossingen voor AR-ontwikkelaars. Deze verbeteringen maken een naadloze mix van digitale en fysieke werelden mogelijk, waardoor nieuwe mogelijkheden voor gaming, virtuele vergaderingen en meer worden ontgrendeld. Met doorzettingsvermogen en innovatie worden de uitdagingen op het gebied van AR-uitlijning beheersbaar. 🚀

Bronnen en referenties

- Details over het gebruik van MediaPipe in Unity werden verwezen vanuit de officiële MediaPipe-documentatie. Ontdek het hier .

- Richtlijnen voor de camerakalibratie en fysieke eigenschappen van Unity zijn te vinden op de Unity-documentatiesite. Bezoek Unity-camera-instellingen voor meer informatie.

- Shader-programmering voor AR-toepassingen en lensvervormingscorrectie is geïnspireerd op artikelen over de ontwikkeling van shader, zoals die op Katachtige codering .

- De ARCore-mogelijkheden en beperkingen voor Android-ontwikkeling zijn beoordeeld op de ARCore-ontwikkelaarssite van Google. Meer informatie op Google ARCore .