Cabaran dalam Penempatan Kepala Maya untuk Pembangunan AR

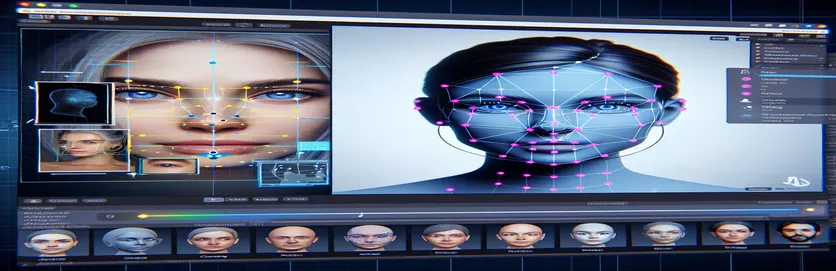

Mengusahakan projek realiti tambahan (AR) boleh menjadi menarik dan mencabar. Apabila membangunkan aplikasi Android dengan Unity, saya menyasarkan untuk menggabungkan dunia digital dan dunia nyata dengan lancar dengan meletakkan kepala maya di atas muka dunia sebenar. Ciri ini sangat bergantung pada ketepatan untuk mencipta pengalaman yang mengasyikkan. 🕶️

Untuk mencapai matlamat ini, saya menggunakan MediaPipe Google untuk mengesan tanda tempat muka seperti mata, hidung dan mulut. Kepala maya kemudiannya dijana dan diletakkan berdasarkan perkara utama ini. Sungguh menarik untuk melihat cara alat moden boleh mengubah kemungkinan AR, tetapi perjalanan itu jauh dari sempurna.

Isu ini muncul apabila kepala maya tidak sejajar dengan wajah sebenar seperti yang dijangkakan. Tidak kira sudut atau peranti, peletakan sentiasa "dimatikan" sedikit, membawa kepada kesan luar biasa. Seolah-olah representasi maya itu terputus dari realiti. Ini mencetuskan satu siri percubaan penyelesaian masalah.

Daripada mengubah suai tetapan kamera Unity hingga bereksperimen dengan algoritma MediaPipe, setiap percubaan membawa peningkatan tambahan tetapi tiada penyelesaian yang muktamad. Artikel ini menyelami inti masalah, pengajaran yang dipelajari dan penyelesaian yang berpotensi untuk pembangun yang menghadapi cabaran yang sama. 🚀

| Perintah | Contoh Penggunaan |

|---|---|

| mainCamera.usePhysicalProperties | Perintah ini membolehkan penggunaan sifat kamera fizikal Unity, membolehkan kawalan yang lebih tepat ke atas panjang fokus dan herotan kanta untuk menjajarkan objek maya dan dunia nyata. |

| faceMesh.GetDetectedFaceTransform() | Mendapatkan semula data transformasi (kedudukan dan putaran) wajah yang dikesan daripada jaringan muka MediaPipe, yang penting untuk meletakkan kepala maya dengan tepat pada muka sebenar. |

| UnityObjectToClipPos | Fungsi khusus shader yang mengubah kedudukan bucu daripada ruang objek kepada ruang klip, digunakan dalam shader pembetulan herotan kanta untuk memastikan penjajaran. |

| tex2D | Perintah shader digunakan untuk mencuba tekstur pada koordinat UV yang ditentukan, penting untuk menggunakan pembetulan herotan pada suapan kamera. |

| length(distUV) | Mengira jarak Euclidean koordinat UV dari asal, yang dimanfaatkan untuk menggunakan pelarasan herotan kanta secara beransur-ansur. |

| adjuster.virtualHead | Pembolehubah skrip yang merujuk kepada kepala maya GameObject, membolehkan kedudukan dan putarannya dikemas kini secara dinamik berdasarkan data penjejakan wajah. |

| [TestFixture] | Atribut NUnit yang menandakan kelas sebagai lekapan ujian, menandakan bahawa ia mengandungi ujian unit. Ini berguna untuk mengesahkan logik penjajaran kepala maya. |

| Assert.AreEqual | Kaedah NUnit yang digunakan untuk membandingkan nilai yang dijangka dan sebenar semasa ujian unit, memastikan peletakan kepala maya sepadan dengan hasil yang diingini. |

| _DistortionStrength | Sifat peneduh yang melaraskan keamatan herotan kanta, memperhalusi penjajaran antara dunia sebenar dan maya. |

| Quaternion.Euler | Mencipta putaran berdasarkan sudut Euler, yang biasa digunakan untuk menjajarkan objek seperti kepala maya dalam ruang 3D Unity. |

Meningkatkan Ketepatan AR dengan Unity dan MediaPipe

Skrip pertama yang kami terokai memfokuskan pada menggunakan sifat kamera fizikal Unity. Dengan membolehkan usePhysicalProperties, kami melaraskan gelagat kamera untuk memadankan optik dunia sebenar dengan lebih dekat. Ini amat penting apabila bekerja dengan AR, di mana walaupun sedikit percanggahan dalam jarak fokus atau medan pandangan boleh menyebabkan objek maya kelihatan tidak sejajar. Contohnya, menetapkan panjang fokus kepada nilai yang tepat seperti 35mm boleh membantu menjajarkan kepala maya dengan muka yang dikesan. Pelarasan ini serupa dengan menala halus teleskop untuk membawa objek jauh ke dalam fokus yang sempurna, memastikan pengalaman AR terasa semula jadi dan mengasyikkan. 📸

Satu lagi komponen penting skrip ialah mendapatkan semula kedudukan dan putaran wajah yang dikesan menggunakan faceMesh.GetDetectedFaceTransform(). Fungsi ini menyediakan kemas kini masa nyata daripada jaringan muka MediaPipe, yang penting untuk menyegerakkan kepala maya dengan pergerakan pengguna. Bayangkan bermain permainan video di mana kepala watak anda tidak bergerak selari dengan anda sendiri; pengalaman itu akan menggerunkan. Dengan memastikan penjajaran yang tepat, skrip ini mengubah AR daripada kebaharuan kepada alat yang boleh menyokong aplikasi seperti mesyuarat maya atau permainan lanjutan.

Skrip kedua menyelidiki pengaturcaraan shader, khususnya menangani herotan kanta. Shader membetulkan herotan dalam suapan kamera, menggunakan sifat seperti _DistortionStrength untuk memanipulasi cara koordinat UV dipetakan pada tekstur. Ini amat berguna apabila berurusan dengan kanta sudut lebar atau kamera dengan profil herotan yang unik. Sebagai contoh, jika kepala maya kelihatan lebih besar atau lebih kecil daripada muka sebenar bergantung pada sudut, mengubah tetapan herotan memastikan penjajaran yang lebih baik. Ia seperti melaraskan bingkai cermin untuk menghapuskan kesan funhouse, menjadikan pantulan lebih realistik. 🎨

Akhir sekali, ujian unit daripada skrip ketiga mengesahkan penyelesaian. Ujian ini membandingkan kedudukan dijangka dan putaran kepala maya dengan keputusan sebenar, memastikan pelarasan bertahan dalam pelbagai keadaan. Menggunakan NUnit Assert.AreEqual, pembangun boleh mensimulasikan senario yang berbeza, seperti menggerakkan kepala dengan pantas atau menyengetkannya pada sudut yang melampau, untuk mengesahkan penjajaran. Sebagai contoh, semasa pembangunan, saya perhatikan bahawa penjajaran berfungsi dengan baik apabila menghadap ke hadapan tetapi hanyut apabila kepala menoleh ke sisi. Ujian unit ini menyerlahkan isu dan membimbing penambahbaikan selanjutnya, mengukuhkan kepentingan ujian menyeluruh dalam mencipta aplikasi AR yang mantap. 🚀

Melaraskan Peletakan Objek Maya dalam AR dengan Unity dan MediaPipe

Penyelesaian 1: Menggunakan Kamera Fizikal Unity untuk Melaraskan FOV dan Herotan Kanta

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Meneroka Pelarasan Alternatif untuk Penjajaran Kepala Maya

Penyelesaian 2: Menggunakan Shader Tersuai untuk Membetulkan herotan Kanta

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Menguji Keserasian Dipertingkat dalam Projek AR Unity

Penyelesaian 3: Melaksanakan Ujian Unit untuk Penjajaran Kepala Maya

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Memperhalusi Peletakan AR Melalui Teknik Penentukuran Yang Dipertingkat

Satu aspek isu penjajaran AR yang sering diabaikan ialah kepentingan penentukuran kamera. Dalam projek AR seperti meletakkan kepala maya di atas yang sebenar, lensa parameter intrinsik memainkan peranan yang penting. Parameter ini termasuk panjang fokus, pusat optik, dan pekali herotan. Apabila nilai ini tidak tepat, kepala maya mungkin kelihatan tidak sejajar atau herot. Untuk menangani perkara ini, alat penentukuran boleh digunakan untuk mengira parameter ini untuk kamera peranti tertentu. Contohnya, perisian seperti OpenCV menawarkan utiliti penentukuran yang mantap untuk menjana matriks kamera yang tepat dan profil herotan. 📐

Pendekatan lain melibatkan memanfaatkan Unity's timbunan pasca pemprosesan. Dengan menggunakan kesan seperti kedalaman medan atau pembetulan penyimpangan kromatik, anda boleh melancarkan percanggahan antara kepala maya yang diberikan dan persekitaran dunia sebenar. Pasca pemprosesan menambah lapisan pengilat yang merapatkan jurang antara objek maya dan ruang fizikal. Sebagai contoh, kesan kabur yang halus boleh mengurangkan bahagian tepi yang kasar yang menjadikan salah jajaran ketara. Ini amat berguna dalam aplikasi yang mendalam di mana pengguna sangat tertumpu pada tempat kejadian.

Akhir sekali, jangan memandang rendah kuasa penyesuaian dinamik semasa masa jalan. Menggabungkan model pembelajaran mesin ke dalam saluran paip AR anda boleh membolehkan sistem mempelajari dan melaraskan peletakan dari semasa ke semasa. Sebagai contoh, model AI boleh menganalisis maklum balas pengguna atau mengesan ketidakkonsistenan dan memperhalusi penjajaran secara dinamik. Ini menjadikan sistem lebih teguh dan mampu menangani variasi dalam pencahayaan, prestasi peranti atau gelagat pengguna. Penambahbaikan ini memastikan pengalaman AR yang lancar, menjadikan dunia maya dan nyata berasa benar-benar bersepadu. 🚀

Soalan Lazim Mengenai MediaPipe dan Penempatan AR Unity

- Mengapa kepala maya saya tidak sejajar dengan wajah sebenar?

- Isu ini sering berpunca daripada penentukuran kamera yang tidak betul. Menggunakan alat seperti OpenCV untuk mengira camera matrix dan distortion coefficients boleh menambah baik penjajaran.

- Apakah peranan panjang fokus dalam penjajaran AR?

- The focal length mentakrifkan cara kamera menayangkan mata 3D pada satah 2D. Melaraskannya dalam tetapan kamera fizikal Unity boleh meningkatkan ketepatan.

- Bolehkah Unity mengendalikan pembetulan herotan kanta?

- Ya, Unity menyokong shader untuk pembetulan herotan. Laksanakan shader dengan sifat seperti _DistortionStrength untuk menyesuaikan pembetulan berdasarkan profil kanta anda.

- Bagaimanakah saya boleh menguji penjajaran objek maya?

- Menggunakan ujian unit dalam NUnit dengan arahan seperti Assert.AreEqual membolehkan anda mengesahkan kedudukan dan putaran objek maya di bawah pelbagai keadaan.

- Adakah pasca pemprosesan diperlukan untuk projek AR?

- Walaupun tidak wajib, kesan pasca pemprosesan seperti depth of field dan chromatic aberration boleh meningkatkan kualiti visual dan realisme adegan AR.

- Bolehkah MediaPipe mengesan objek selain daripada muka?

- Ya, MediaPipe menawarkan penyelesaian untuk tangan, pose, dan juga penjejakan holistik, menjadikannya serba boleh untuk kes penggunaan AR yang berbeza.

- Apakah perkakasan yang paling sesuai untuk aplikasi Unity AR?

- Peranti dengan GPU berprestasi tinggi dan kamera yang tepat adalah sesuai. Alat seperti ARCore dan ARKit meningkatkan lagi keserasian.

- Mengapa penjajaran lebih teruk pada sudut tertentu?

- Ini mungkin disebabkan oleh ketidakpadanan dalam bidang pandangan antara kamera dan persekitaran maya. Melaraskan kamera Unity fieldOfView harta boleh membantu.

- Bagaimanakah shader meningkatkan penjajaran AR?

- Shader membenarkan pelarasan masa nyata pada pemaparan, seperti membetulkan herotan atau mensimulasikan kesan kanta, memastikan penyegerakan yang lebih baik antara objek maya dan sebenar.

- Bolehkah sistem AR menyesuaikan diri dari semasa ke semasa?

- Ya, penyepaduan model pembelajaran mesin membolehkan sistem menyesuaikan diri secara dinamik, belajar daripada maklum balas untuk meningkatkan penjajaran dan prestasi dari semasa ke semasa.

Meningkatkan Ketepatan AR: Pemikiran Akhir

Mencapai penjajaran tepat antara objek maya dan dunia nyata adalah penting untuk pengalaman AR yang mendalam. Melalui penentukuran yang teliti dan teknik lanjutan, isu seperti herotan kanta dan jarak fokus yang tidak sepadan boleh dikurangkan, memastikan ketepatan yang lebih baik dan kepuasan pengguna.

Mengintegrasikan alatan Unity, algoritma MediaPipe dan pelarasan dinamik menawarkan penyelesaian yang mantap untuk pembangun AR. Penambahbaikan ini membolehkan gabungan lancar dunia digital dan fizikal, membuka kunci kemungkinan baharu untuk permainan, mesyuarat maya dan seterusnya. Dengan kegigihan dan inovasi, cabaran penjajaran AR menjadi terurus. 🚀

Sumber dan Rujukan

- Butiran tentang menggunakan MediaPipe dalam Unity dirujuk daripada dokumentasi rasmi MediaPipe. Terokainya di sini .

- Panduan tentang penentukuran kamera dan sifat fizikal Unity boleh didapati di tapak dokumentasi Unity. melawat Tetapan Kamera Perpaduan untuk maklumat lanjut.

- Pengaturcaraan shader untuk aplikasi AR dan pembetulan herotan kanta telah diilhamkan oleh artikel tentang pembangunan shader, seperti yang terdapat pada Pengekodan seperti kucing .

- Keupayaan dan had ARCore untuk pembangunan Android telah disemak daripada tapak pembangun ARCore Google. Ketahui lebih lanjut di Google ARCore .