AR 개발을 위한 가상 헤드 배치의 과제

증강 현실(AR) 프로젝트 작업은 흥미롭기도 하고 어려울 수도 있습니다. Unity로 Android 애플리케이션을 개발할 때 저는 실제 얼굴 위에 가상 머리를 배치하여 디지털 세계와 현실 세계를 원활하게 혼합하는 것을 목표로 했습니다. 이 기능은 몰입형 경험을 만들기 위해 정밀도에 크게 의존합니다. 🕶️

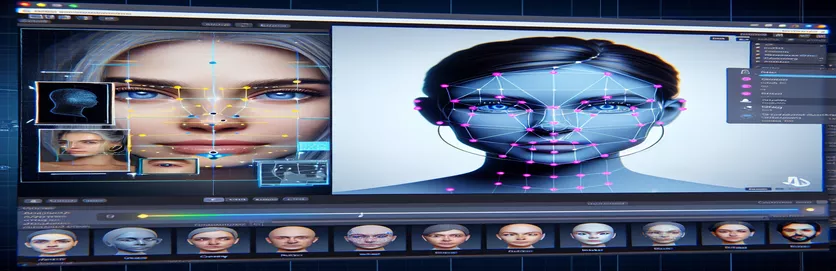

이를 달성하기 위해 Google의 MediaPipe를 활용하여 눈, 코, 입과 같은 얼굴 랜드마크를 감지했습니다. 그런 다음 이러한 핵심 포인트를 기반으로 가상 머리가 생성되고 배치되었습니다. 최신 도구가 AR 가능성을 어떻게 변화시킬 수 있는지 보는 것은 흥미로웠지만 여정은 완벽하지 않았습니다.

가상 머리가 실제 얼굴과 예상대로 정렬되지 않을 때 문제가 발생했습니다. 각도나 장치에 관계없이 항상 배치가 약간 "어긋나" 있어서 부자연스러운 효과가 발생했습니다. 마치 가상의 표현이 현실과 단절된 것 같았습니다. 이로 인해 일련의 문제 해결 실험이 촉발되었습니다.

Unity의 카메라 설정을 조정하는 것부터 MediaPipe의 알고리즘을 실험하는 것까지 모든 시도에서 점진적인 개선이 이루어졌지만 확실한 해결책은 없었습니다. 이 기사에서는 비슷한 문제에 직면한 개발자를 위한 문제의 핵심, 교훈, 잠재적인 솔루션을 자세히 살펴봅니다. 🚀

| 명령 | 사용예 |

|---|---|

| mainCamera.usePhysicalProperties | 이 명령을 사용하면 Unity의 물리적 카메라 속성을 사용할 수 있으므로 초점 거리와 렌즈 왜곡을 더욱 정밀하게 제어하여 가상 객체와 실제 객체를 정렬할 수 있습니다. |

| faceMesh.GetDetectedFaceTransform() | MediaPipe의 얼굴 메시에서 감지된 얼굴의 변환 데이터(위치 및 회전)를 검색합니다. 이는 실제 얼굴 위에 가상 머리를 정확하게 배치하는 데 중요합니다. |

| UnityObjectToClipPos | 정렬을 보장하기 위해 렌즈 왜곡 보정 셰이더에서 사용되는 정점 위치를 객체 공간에서 클립 공간으로 변환하는 셰이더 관련 기능입니다. |

| tex2D | 지정된 UV 좌표에서 텍스처를 샘플링하는 데 사용되는 셰이더 명령으로, 카메라 피드에 왜곡 보정을 적용하는 데 필수적입니다. |

| length(distUV) | 점진적인 렌즈 왜곡 조정을 적용하는 데 활용되는 원점에서 UV 좌표의 유클리드 거리를 계산합니다. |

| adjuster.virtualHead | 가상 헤드 GameObject를 참조하는 스크립트 변수로, 얼굴 추적 데이터를 기반으로 해당 위치와 회전을 동적으로 업데이트할 수 있습니다. |

| [TestFixture] | 클래스를 테스트 픽스처로 표시하고 단위 테스트가 포함되어 있음을 알리는 NUnit 특성입니다. 이는 가상 헤드 정렬 논리를 확인하는 데 유용합니다. |

| Assert.AreEqual | 단위 테스트 중에 예상 값과 실제 값을 비교하는 데 사용되는 NUnit 방법으로 가상 헤드 배치가 원하는 결과와 일치하는지 확인합니다. |

| _DistortionStrength | 렌즈 왜곡의 강도를 조정하여 현실 세계와 가상 세계 간의 정렬을 미세 조정하는 셰이더 속성입니다. |

| Quaternion.Euler | Unity의 3D 공간에서 가상 머리와 같은 객체를 정렬하는 데 일반적으로 사용되는 오일러 각도를 기반으로 회전을 생성합니다. |

Unity와 MediaPipe를 통해 AR 정확도 향상

우리가 살펴본 첫 번째 스크립트는 Unity의 물리적 카메라 속성을 사용하는 데 중점을 두었습니다. 활성화함으로써 usePhysicalProperties, 실제 광학 장치와 더 밀접하게 일치하도록 카메라의 동작을 조정합니다. 이는 초점 거리나 시야가 약간만이라도 불일치하면 가상 객체가 잘못 정렬된 것처럼 보일 수 있는 AR로 작업할 때 특히 중요합니다. 예를 들어 초점 거리를 35mm와 같은 정확한 값으로 설정하면 가상 머리를 감지된 얼굴에 정렬하는 데 도움이 될 수 있습니다. 이러한 조정은 멀리 있는 물체에 완벽한 초점을 맞추기 위해 망원경을 미세 조정하는 것과 유사하여 AR 경험이 자연스럽고 몰입감 있게 느껴지도록 합니다. 📸

스크립트의 또 다른 중요한 구성 요소는 다음을 사용하여 감지된 얼굴의 위치와 회전을 검색하는 것입니다. FaceMesh.GetDetectedFaceTransform(). 이 기능은 가상 머리를 사용자의 움직임과 동기화하는 데 필수적인 MediaPipe의 얼굴 메시에서 실시간 업데이트를 제공합니다. 캐릭터의 머리가 자신의 머리와 동기화되지 않는 비디오 게임을 한다고 상상해 보십시오. 그 경험은 충격적일 것이다. 정확한 정렬을 보장함으로써 이 스크립트는 AR을 참신함에서 가상 회의 또는 고급 게임과 같은 애플리케이션을 지원할 수 있는 도구로 변환합니다.

두 번째 스크립트는 셰이더 프로그래밍, 특히 렌즈 왜곡을 다루는 내용을 자세히 설명합니다. 셰이더는 _DistortionStrength와 같은 속성을 사용하여 UV 좌표가 텍스처에 매핑되는 방식을 조작하여 카메라 피드의 왜곡을 수정합니다. 이는 독특한 왜곡 프로파일을 가진 광각 렌즈나 카메라를 다룰 때 특히 유용합니다. 예를 들어 가상 머리가 각도에 따라 실제 얼굴보다 크거나 작게 나타나는 경우 왜곡 설정을 조정하면 더 나은 정렬이 보장됩니다. 마치 거울의 프레임을 조정하여 펀하우스 효과를 제거하여 반사를 더욱 사실적으로 만드는 것과 같습니다. 🎨

마지막으로 세 번째 스크립트의 단위 테스트는 솔루션의 유효성을 검사합니다. 이 테스트에서는 가상 머리의 예상 위치와 회전을 실제 결과와 비교하여 다양한 조건에서 조정이 유지되는지 확인합니다. NUnit 사용하기 Assert.AreEqual을 통해 개발자는 머리를 빠르게 움직이거나 극단적인 각도로 기울이는 등 다양한 시나리오를 시뮬레이션하여 정렬을 확인할 수 있습니다. 예를 들어, 개발 중에 앞을 향할 때는 정렬이 잘 작동하지만 머리를 옆으로 돌릴 때는 정렬이 흐트러지는 것을 발견했습니다. 이러한 단위 테스트는 문제를 강조하고 추가 개선 사항을 안내하여 강력한 AR 애플리케이션을 만드는 데 있어 철저한 테스트의 중요성을 강화했습니다. 🚀

Unity 및 MediaPipe를 사용하여 AR에서 가상 개체 배치 조정

해결 방법 1: Unity의 실제 카메라를 사용하여 FOV 및 렌즈 왜곡 조정

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

가상 머리 정렬을 위한 대체 조정 탐색

해결 방법 2: 사용자 정의 셰이더를 사용하여 렌즈 왜곡 수정

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Unity AR 프로젝트의 향상된 호환성 테스트

해결 방법 3: 가상 머리 정렬을 위한 단위 테스트 구현

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

향상된 보정 기술을 통해 AR 배치 개선

AR 정렬 문제에서 흔히 간과되는 측면 중 하나는 카메라 보정의 중요성입니다. 실제 머리 위에 가상 머리를 배치하는 것과 같은 AR 프로젝트에서 렌즈의 내부 매개변수 중요한 역할을 합니다. 이러한 매개변수에는 초점 거리, 광학 중심 및 왜곡 계수가 포함됩니다. 이러한 값이 정확하지 않으면 가상 머리가 잘못 정렬되거나 왜곡되어 나타날 수 있습니다. 이 문제를 해결하기 위해 교정 도구를 사용하여 특정 장치 카메라에 대한 이러한 매개변수를 계산할 수 있습니다. 예를 들어 OpenCV와 같은 소프트웨어는 정밀한 카메라 매트릭스와 왜곡 프로파일을 생성하는 강력한 보정 유틸리티를 제공합니다. 📐

또 다른 접근 방식은 Unity의 후처리 스택. 피사계 심도나 색수차 보정과 같은 효과를 적용하면 렌더링된 가상 머리와 실제 환경 간의 불일치를 완화할 수 있습니다. 후처리는 가상 객체와 물리적 공간 사이의 격차를 해소하는 광택 레이어를 추가합니다. 예를 들어, 미묘한 흐림 효과는 잘못된 정렬을 눈에 띄게 만드는 거친 가장자리를 줄일 수 있습니다. 이는 사용자가 장면에 매우 집중하는 몰입형 애플리케이션에 특히 유용합니다.

마지막으로, 런타임 중 동적 적응의 힘을 과소평가하지 마십시오. 기계 학습 모델을 AR 파이프라인에 통합하면 시스템이 시간이 지남에 따라 배치를 학습하고 조정할 수 있습니다. 예를 들어 AI 모델은 사용자 피드백을 분석하거나 불일치를 감지하고 동적으로 정렬을 미세 조정할 수 있습니다. 이를 통해 시스템은 더욱 강력해지고 조명, 장치 성능 또는 사용자 행동의 변화를 처리할 수 있게 됩니다. 이러한 개선으로 원활한 AR 경험이 보장되어 가상 세계와 현실 세계가 진정으로 통합된 듯한 느낌을 받게 됩니다. 🚀

MediaPipe 및 Unity AR 배치에 대한 일반적인 질문

- 내 가상 머리가 실제 얼굴과 잘못 정렬되는 이유는 무엇입니까?

- 이 문제는 부적절한 카메라 보정으로 인해 발생하는 경우가 많습니다. OpenCV와 같은 도구를 사용하여 계산 camera matrix 그리고 distortion coefficients 정렬을 크게 향상시킬 수 있습니다.

- AR 정렬에서 초점 거리의 역할은 무엇입니까?

- 그만큼 focal length 카메라가 3D 점을 2D 평면에 투영하는 방법을 정의합니다. Unity의 실제 카메라 설정에서 이를 조정하면 정확도가 향상될 수 있습니다.

- Unity에서 렌즈 왜곡 보정을 처리할 수 있나요?

- 예, Unity는 왜곡 보정을 위한 셰이더를 지원합니다. 다음과 같은 속성을 사용하여 셰이더를 구현합니다. _DistortionStrength 렌즈 프로필을 기반으로 교정을 사용자 정의합니다.

- 가상 개체의 정렬을 어떻게 테스트할 수 있나요?

- 다음과 같은 명령으로 NUnit에서 단위 테스트 사용 Assert.AreEqual 다양한 조건에서 가상 객체의 위치 지정과 회전을 검증할 수 있습니다.

- AR 프로젝트에 후처리가 필요한가요?

- 필수는 아니지만 다음과 같은 후처리 효과가 있습니다. depth of field 그리고 chromatic aberration AR 장면의 시각적 품질과 현실감을 향상시킬 수 있습니다.

- MediaPipe가 얼굴 이외의 개체를 감지할 수 있나요?

- 예, MediaPipe는 손, 포즈, 전체적인 추적을 위한 솔루션을 제공하므로 다양한 AR 사용 사례에 다용도로 사용할 수 있습니다.

- Unity AR 애플리케이션에 가장 적합한 하드웨어는 무엇입니까?

- 고성능 GPU와 정밀한 카메라를 갖춘 장치가 이상적입니다. 다음과 같은 도구 ARCore 그리고 ARKit 호환성을 더욱 강화합니다.

- 특정 각도에서 정렬이 더 나빠지는 이유는 무엇입니까?

- 이는 카메라와 가상 환경 간의 시야 불일치로 인해 발생할 수 있습니다. Unity 카메라 조정 fieldOfView 재산이 도움이 될 수 있습니다.

- 셰이더는 AR 정렬을 어떻게 개선합니까?

- 셰이더를 사용하면 왜곡 수정, 렌즈 효과 시뮬레이션 등 렌더링을 실시간으로 조정할 수 있어 가상 객체와 실제 객체 간의 동기화가 향상됩니다.

- AR 시스템은 시간이 지남에 따라 자체 조정될 수 있나요?

- 예, 기계 학습 모델을 통합하면 시스템이 동적으로 적응하고 피드백을 통해 학습하여 시간이 지남에 따라 정렬과 성능을 향상할 수 있습니다.

AR 정확도 향상: 최종 생각

몰입형 AR 경험을 위해서는 가상 객체와 실제 객체 간의 정확한 정렬을 달성하는 것이 중요합니다. 세심한 보정과 고급 기술을 통해 렌즈 왜곡 및 초점 거리 불일치와 같은 문제를 완화하여 정확도와 사용자 만족도를 높일 수 있습니다.

Unity의 도구, MediaPipe 알고리즘 및 동적 조정을 통합하면 AR 개발자를 위한 강력한 솔루션이 제공됩니다. 이러한 개선을 통해 디지털 세계와 실제 세계의 원활한 혼합이 가능해지며 게임, 가상 회의 등을 위한 새로운 가능성이 열립니다. 지속성과 혁신을 통해 AR 정렬 문제를 관리할 수 있게 됩니다. 🚀

출처 및 참고자료

- Unity에서 MediaPipe 사용에 대한 자세한 내용은 공식 MediaPipe 문서에서 참조했습니다. 탐험해 보세요 여기 .

- Unity의 카메라 보정 및 물리적 속성에 대한 지침은 Unity 설명서 사이트에서 확인할 수 있습니다. 방문하다 Unity 카메라 설정 자세한 내용은

- AR 애플리케이션 및 렌즈 왜곡 보정을 위한 셰이더 프로그래밍은 다음과 같은 셰이더 개발 관련 기사에서 영감을 받았습니다. 고양이 같은 코딩 .

- Android 개발을 위한 ARCore 기능 및 제한 사항은 Google의 ARCore 개발자 사이트에서 검토되었습니다. 자세히 알아보기 구글 ARCore .