Sfide nel posizionamento della testa virtuale per lo sviluppo AR

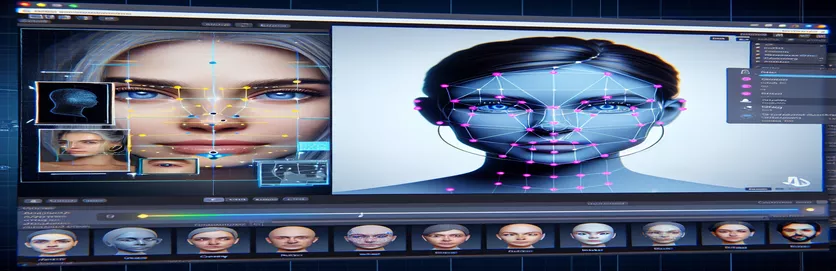

Lavorare su un progetto di realtà aumentata (AR) può essere allo stesso tempo entusiasmante e stimolante. Durante lo sviluppo di un'applicazione Android con Unity, ho mirato a fondere perfettamente il mondo digitale e quello reale posizionando una testa virtuale sui volti del mondo reale. Questa funzionalità fa molto affidamento sulla precisione per creare un'esperienza coinvolgente. 🕶️

Per raggiungere questo obiettivo, ho utilizzato MediaPipe di Google per rilevare punti di riferimento facciali come occhi, naso e bocca. La testa virtuale è stata quindi generata e posizionata in base a questi punti chiave. È stato affascinante vedere come gli strumenti moderni potessero trasformare le possibilità dell’AR, ma il viaggio era tutt’altro che perfetto.

Il problema emergeva quando la testa virtuale non si allineava con il volto reale come previsto. Non importa l'angolazione o il dispositivo, il posizionamento era sempre un po' "fuori posto", producendo un effetto innaturale. Era come se la rappresentazione virtuale fosse scollegata dalla realtà. Ciò ha dato il via a una serie di esperimenti per la risoluzione dei problemi.

Dalla modifica delle impostazioni della fotocamera di Unity alla sperimentazione con l'algoritmo di MediaPipe, ogni tentativo ha portato miglioramenti incrementali ma nessuna soluzione definitiva. Questo articolo approfondisce il nocciolo del problema, le lezioni apprese e le potenziali soluzioni per gli sviluppatori che affrontano sfide simili. 🚀

| Comando | Esempio di utilizzo |

|---|---|

| mainCamera.usePhysicalProperties | Questo comando consente l'utilizzo delle proprietà fisiche della fotocamera di Unity, consentendo un controllo più preciso sulla lunghezza focale e sulla distorsione dell'obiettivo per allineare gli oggetti virtuali e del mondo reale. |

| faceMesh.GetDetectedFaceTransform() | Recupera i dati di trasformazione (posizione e rotazione) di un volto rilevato dalla mesh dei volti di MediaPipe, fondamentale per posizionare accuratamente le teste virtuali sui volti reali. |

| UnityObjectToClipPos | Una funzione specifica dello shader che trasforma la posizione di un vertice dallo spazio dell'oggetto allo spazio del clip, utilizzata negli shader di correzione della distorsione dell'obiettivo per garantire l'allineamento. |

| tex2D | Un comando shader utilizzato per campionare una texture alle coordinate UV specificate, essenziale per applicare la correzione della distorsione ai feed della fotocamera. |

| length(distUV) | Calcola la distanza euclidea delle coordinate UV dall'origine, che viene sfruttata per applicare regolazioni graduali della distorsione della lente. |

| adjuster.virtualHead | Una variabile di script che fa riferimento alla testa virtuale GameObject, consentendo l'aggiornamento dinamico della sua posizione e rotazione in base ai dati di rilevamento del volto. |

| [TestFixture] | Un attributo NUnit che contrassegna una classe come dispositivo di test, segnalando che contiene test unitari. Ciò è utile per verificare la logica di allineamento della testa virtuale. |

| Assert.AreEqual | Un metodo NUnit utilizzato per confrontare i valori attesi e quelli effettivi durante i test unitari, garantendo che il posizionamento della testa virtuale corrisponda ai risultati desiderati. |

| _DistortionStrength | Una proprietà shader che regola l'intensità della distorsione della lente, perfezionando l'allineamento tra il mondo reale e quello virtuale. |

| Quaternion.Euler | Crea una rotazione basata sugli angoli di Eulero, comunemente utilizzata per allineare oggetti come la testa virtuale nello spazio 3D di Unity. |

Miglioramento della precisione AR con Unity e MediaPipe

Il primo script che abbiamo esplorato si concentra sull'utilizzo delle proprietà fisiche della fotocamera di Unity. Abilitando utilizzareProprietàFisiche, regoliamo il comportamento della fotocamera per adattarlo più fedelmente all'ottica del mondo reale. Ciò è particolarmente importante quando si lavora con la realtà aumentata, dove anche lievi discrepanze nella lunghezza focale o nel campo visivo possono far apparire disallineati gli oggetti virtuali. Ad esempio, impostare la lunghezza focale su un valore preciso come 35 mm può aiutare ad allineare la testa virtuale con il volto rilevato. Questa regolazione è simile alla messa a punto di un telescopio per mettere a fuoco perfettamente gli oggetti distanti, garantendo che l’esperienza AR sia naturale e coinvolgente. 📸

Un altro componente cruciale dello script è il recupero della posizione e della rotazione del volto rilevato utilizzando faceMesh.GetDetectedFaceTransform(). Questa funzione fornisce aggiornamenti in tempo reale dalla mesh del viso di MediaPipe, essenziale per sincronizzare la testa virtuale con i movimenti dell'utente. Immagina di giocare a un videogioco in cui la testa del tuo personaggio non si muove in sincronia con la tua; l'esperienza sarebbe sconvolgente. Garantendo un allineamento accurato, questo script trasforma l'AR da una novità in uno strumento in grado di supportare applicazioni come riunioni virtuali o giochi avanzati.

Il secondo script approfondisce la programmazione degli shader, affrontando in particolare la distorsione dell'obiettivo. Lo shader corregge le distorsioni nel feed della fotocamera, utilizzando proprietà come _DistortionStrength per manipolare il modo in cui le coordinate UV vengono mappate sulla texture. Ciò è particolarmente utile quando si ha a che fare con obiettivi grandangolari o fotocamere con profili di distorsione unici. Ad esempio, se una testa virtuale appare più grande o più piccola del volto reale a seconda dell'angolazione, la modifica delle impostazioni di distorsione garantisce un migliore allineamento. È come regolare la cornice di uno specchio per eliminare l’effetto luna park, rendendo i riflessi più realistici. 🎨

Infine, gli unit test del terzo script convalidano le soluzioni. Questi test confrontano la posizione e la rotazione previste della testa virtuale con i risultati effettivi, garantendo che le regolazioni resistano in varie condizioni. Utilizzando NUnit Assert.AreEqual, gli sviluppatori possono simulare diversi scenari, come muovere rapidamente la testa o inclinarla ad angoli estremi, per confermare l'allineamento. Ad esempio, durante lo sviluppo, ho notato che l'allineamento funzionava bene quando si guardava in avanti, ma andava alla deriva quando la testa si girava di lato. Questi test unitari hanno evidenziato il problema e guidato ulteriori miglioramenti, rafforzando l’importanza di test approfonditi nella creazione di robuste applicazioni AR. 🚀

Regolazione del posizionamento degli oggetti virtuali in AR con Unity e MediaPipe

Soluzione 1: utilizzare la fotocamera fisica di Unity per regolare il FOV e la distorsione dell'obiettivo

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Esplorazione di regolazioni alternative per l'allineamento della testa virtuale

Soluzione 2: utilizzo di uno shader personalizzato per correggere la distorsione dell'obiettivo

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Test per una compatibilità avanzata nei progetti AR di Unity

Soluzione 3: implementazione di unit test per l'allineamento della testa virtuale

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Perfezionamento del posizionamento AR attraverso tecniche di calibrazione avanzate

Un aspetto spesso trascurato dei problemi di allineamento AR è l’importanza della calibrazione della fotocamera. Nei progetti AR è come posizionare una testa virtuale sopra una testa reale, quella dell'obiettivo parametri intrinseci svolgere un ruolo vitale. Questi parametri includono la lunghezza focale, il centro ottico e i coefficienti di distorsione. Quando questi valori non sono accurati, la testa virtuale potrebbe apparire disallineata o distorta. Per risolvere questo problema, è possibile utilizzare strumenti di calibrazione per calcolare questi parametri per la fotocamera del dispositivo specifico. Ad esempio, software come OpenCV offre robuste utilità di calibrazione per generare matrici di fotocamere e profili di distorsione precisi. 📐

Un altro approccio prevede lo sfruttamento di Unity stack di post-elaborazione. Applicando effetti come la profondità di campo o le correzioni dell'aberrazione cromatica, puoi appianare le discrepanze tra la testa virtuale renderizzata e l'ambiente del mondo reale. La post-elaborazione aggiunge uno strato di rifinitura che colma il divario tra oggetti virtuali e spazi fisici. Ad esempio, un leggero effetto di sfocatura può ridurre i bordi netti che rendono evidenti i disallineamenti. Ciò è particolarmente utile nelle applicazioni immersive in cui gli utenti sono fortemente concentrati sulla scena.

Infine, non sottovalutare il potere dell’adattamento dinamico durante il runtime. Incorporare modelli di machine learning nella tua pipeline AR può consentire al sistema di apprendere e adattare il posizionamento nel tempo. Ad esempio, un modello di intelligenza artificiale potrebbe analizzare il feedback degli utenti o rilevare incoerenze e mettere a punto l’allineamento in modo dinamico. Ciò rende il sistema più robusto e in grado di gestire variazioni di illuminazione, prestazioni del dispositivo o comportamento dell'utente. Questi miglioramenti garantiscono un’esperienza AR senza soluzione di continuità, facendo sì che il mondo virtuale e quello reale sembrino veramente integrati. 🚀

Domande comuni sul posizionamento di MediaPipe e Unity AR

- Perché la mia testa virtuale non è allineata rispetto al volto reale?

- Il problema spesso deriva da una calibrazione errata della fotocamera. Utilizzando strumenti come OpenCV per calcolare il camera matrix E distortion coefficients può migliorare notevolmente l'allineamento.

- Qual è il ruolo della lunghezza focale nell'allineamento AR?

- IL focal length definisce il modo in cui la telecamera proietta i punti 3D su un piano 2D. Regolarlo nelle impostazioni fisiche della fotocamera di Unity può migliorare la precisione.

- Unity è in grado di gestire la correzione della distorsione dell'obiettivo?

- Sì, Unity supporta gli shader per la correzione della distorsione. Implementa uno shader con proprietà come _DistortionStrength per personalizzare le correzioni in base al profilo dell'obiettivo.

- Come posso testare l'allineamento degli oggetti virtuali?

- Utilizzo dei test unitari in NUnit con comandi come Assert.AreEqual consente di convalidare il posizionamento e la rotazione degli oggetti virtuali in varie condizioni.

- La post-elaborazione è necessaria per i progetti AR?

- Sebbene non siano obbligatori, gli effetti di post-elaborazione simili depth of field E chromatic aberration può migliorare la qualità visiva e il realismo delle scene AR.

- MediaPipe può rilevare oggetti diversi dai volti?

- Sì, MediaPipe offre soluzioni per mani, pose e persino tracciamento olistico, rendendolo versatile per diversi casi d'uso AR.

- Quale hardware funziona meglio per le applicazioni Unity AR?

- I dispositivi con GPU ad alte prestazioni e fotocamere precise sono l'ideale. Strumenti come ARCore E ARKit migliorare ulteriormente la compatibilità.

- Perché l'allineamento è peggiore a determinati angoli?

- Ciò potrebbe essere dovuto a una mancata corrispondenza del campo visivo tra la telecamera e l'ambiente virtuale. Regolazione della telecamera Unity fieldOfView la proprietà può aiutare.

- In che modo gli shader migliorano l'allineamento AR?

- Gli shader consentono regolazioni in tempo reale al rendering, come la correzione di distorsioni o la simulazione degli effetti della lente, garantendo una migliore sincronizzazione tra oggetti virtuali e reali.

- I sistemi AR possono auto-adattarsi nel tempo?

- Sì, l’integrazione di modelli di machine learning consente ai sistemi di adattarsi dinamicamente, imparando dal feedback per migliorare l’allineamento e le prestazioni nel tempo.

Migliorare la precisione AR: considerazioni finali

Raggiungere un allineamento preciso tra gli oggetti virtuali e quelli del mondo reale è fondamentale per esperienze AR coinvolgenti. Attraverso un'attenta calibrazione e tecniche avanzate, è possibile mitigare problemi come la distorsione dell'obiettivo e le lunghezze focali non corrispondenti, garantendo una migliore precisione e soddisfazione dell'utente.

L'integrazione degli strumenti di Unity, degli algoritmi MediaPipe e delle regolazioni dinamiche offre soluzioni robuste per gli sviluppatori AR. Questi miglioramenti consentono una perfetta combinazione di mondi digitali e fisici, sbloccando nuove possibilità per giochi, riunioni virtuali e altro ancora. Con tenacia e innovazione, le sfide dell’allineamento AR diventano gestibili. 🚀

Fonti e riferimenti

- I dettagli sull'utilizzo di MediaPipe in Unity sono stati referenziati dalla documentazione ufficiale di MediaPipe. Esploralo Qui .

- È possibile trovare indicazioni sulla calibrazione della fotocamera e sulle proprietà fisiche di Unity sul sito della documentazione di Unity. Visita Impostazioni della fotocamera Unity per maggiori dettagli

- La programmazione degli shader per applicazioni AR e la correzione della distorsione dell'obiettivo è stata ispirata da articoli sullo sviluppo degli shader, come quelli su Codifica felina .

- Le funzionalità e le limitazioni di ARCore per lo sviluppo Android sono state esaminate dal sito per sviluppatori ARCore di Google. Scopri di più su Google ARCore .