Izazovi u postavljanju virtualne glave za razvoj AR-a

Rad na projektu proširene stvarnosti (AR) može biti i uzbudljiv i izazovan. Kada sam razvijao Android aplikaciju s Unityjem, namjeravao sam besprijekorno pomiješati digitalni i stvarni svijet postavljanjem virtualne glave preko lica iz stvarnog svijeta. Ova se značajka uvelike oslanja na preciznost kako bi se stvorilo impresivno iskustvo. 🕶️

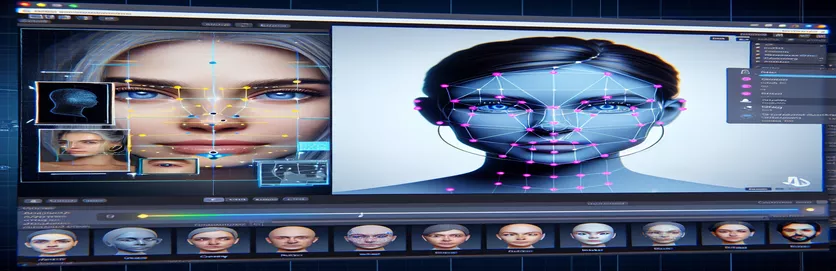

Kako bih to postigao, upotrijebio sam Googleov MediaPipe za otkrivanje orijentira na licu poput očiju, nosa i usta. Virtualna glava je zatim generirana i postavljena na temelju ovih ključnih točaka. Bilo je fascinantno vidjeti kako moderni alati mogu transformirati AR mogućnosti, ali putovanje je bilo daleko od savršenog.

Problem se pojavio kada se virtualna glava nije poravnala sa stvarnim licem kako se očekivalo. Bez obzira na kut ili uređaj, položaj je uvijek bio malo "iskrivljen", što je dovelo do neprirodnog učinka. Kao da je virtualna reprezentacija bila odvojena od stvarnosti. To je pokrenulo niz eksperimenata za rješavanje problema.

Od podešavanja Unityjevih postavki kamere do eksperimentiranja s algoritmom MediaPipea, svaki pokušaj donosio je postupna poboljšanja, ali ne i konačno rješenje. Ovaj članak zaranja u srž problema, naučene lekcije i potencijalna rješenja za programere koji se suočavaju sa sličnim izazovima. 🚀

| Naredba | Primjer upotrebe |

|---|---|

| mainCamera.usePhysicalProperties | Ova naredba omogućuje korištenje Unityjevih fizičkih svojstava kamere, omogućujući precizniju kontrolu nad žarišnom duljinom i izobličenjem leće za poravnavanje virtualnih i stvarnih objekata. |

| faceMesh.GetDetectedFaceTransform() | Dohvaća transformacijske podatke (položaj i rotacija) otkrivenog lica iz mreže lica MediaPipe, što je ključno za točno postavljanje virtualnih glava preko stvarnih lica. |

| UnityObjectToClipPos | Funkcija specifična za shadere koja transformira položaj vrha iz prostora objekta u prostor isječka, a koristi se u shaderima za korekciju izobličenja objektiva kako bi se osiguralo poravnanje. |

| tex2D | Naredba shadera koja se koristi za uzorkovanje teksture na određenim UV koordinatama, bitna za primjenu korekcije izobličenja na feedove kamere. |

| length(distUV) | Izračunava euklidsku udaljenost UV koordinata od ishodišta, što se koristi za primjenu postupnih prilagodbi izobličenja leće. |

| adjuster.virtualHead | Varijabla skripte koja se odnosi na virtualnu glavu GameObject, omogućavajući dinamičko ažuriranje njezine pozicije i rotacije na temelju podataka o praćenju lica. |

| [TestFixture] | Atribut NUnit koji označava klasu kao test fixture, signalizirajući da sadrži jedinične testove. Ovo je korisno za provjeru logike poravnanja virtualne glave. |

| Assert.AreEqual | NUnit metoda koja se koristi za usporedbu očekivanih i stvarnih vrijednosti tijekom testiranja jedinice, osiguravajući da virtualni položaj glave odgovara željenim rezultatima. |

| _DistortionStrength | Svojstvo sjenčanja koje prilagođava intenzitet izobličenja leće, fino podešavajući usklađivanje između stvarnog i virtualnog svijeta. |

| Quaternion.Euler | Stvara rotaciju na temelju Eulerovih kutova, koji se obično koriste za poravnavanje objekata poput virtualne glave u 3D prostoru Unityja. |

Poboljšanje AR točnosti uz Unity i MediaPipe

Prva skripta koju smo istražili fokusirana je na korištenje svojstava fizičke kamere Unityja. Omogućavanjem usePhysicalProperties, prilagođavamo ponašanje kamere kako bi bolje odgovaralo stvarnoj optici. Ovo je osobito važno kada radite s AR-om, gdje čak i mala odstupanja u žarišnoj duljini ili vidnom polju mogu učiniti da virtualni objekti izgledaju neporavnati. Na primjer, postavljanje žarišne duljine na preciznu vrijednost poput 35 mm može pomoći u poravnanju virtualne glave s detektiranim licem. Ova prilagodba je slična finom podešavanju teleskopa kako bi se udaljeni objekti savršeno fokusirali, osiguravajući da AR iskustvo bude prirodno i impresivno. 📸

Druga ključna komponenta skripte je dohvaćanje položaja i rotacije otkrivenog lica pomoću faceMesh.GetDetectedFaceTransform(). Ova funkcija pruža ažuriranja u stvarnom vremenu iz MediaPipe mreže za lice, što je bitno za sinkronizaciju virtualne glave s pokretima korisnika. Zamislite da igrate video igru u kojoj se glava vašeg lika ne pomiče sinkronizirano s vašom; iskustvo bi bilo mučno. Osiguravajući točnu usklađenost, ova skripta transformira AR iz novosti u alat koji može podržati aplikacije poput virtualnih sastanaka ili naprednog igranja.

Druga skripta bavi se programiranjem shadera, posebno se baveći distorzijom leće. Shader ispravlja izobličenja u feedu kamere, koristeći svojstva kao što je _DistortionStrength za manipuliranje načinom na koji se UV koordinate preslikavaju na teksturu. Ovo je osobito korisno kada se radi o širokokutnim objektivima ili kamerama s jedinstvenim profilima izobličenja. Na primjer, ako se virtualna glava čini većom ili manjom od stvarnog lica, ovisno o kutu, podešavanje postavki izobličenja osigurava bolje poravnanje. To je poput podešavanja okvira zrcala kako biste uklonili efekt zabave, čineći odraze realističnijima. 🎨

Konačno, jedinični testovi iz treće skripte potvrđuju rješenja. Ovi testovi uspoređuju očekivani položaj i rotaciju virtualne glave sa stvarnim rezultatima, osiguravajući da prilagodbe izdrže u različitim uvjetima. Korištenje NUnit-a Ustvrdi.Jesu li jednaki, programeri mogu simulirati različite scenarije, poput brzog pomicanja glave ili naginjanja pod ekstremnim kutovima, kako bi potvrdili poravnanje. Na primjer, tijekom razvoja, primijetio sam da je poravnanje dobro funkcioniralo kada je lice okrenuto prema naprijed, ali je zalutalo kada se glava okrene u stranu. Ovi jedinični testovi istaknuli su problem i usmjerili daljnja poboljšanja, pojačavajući važnost temeljitog testiranja u stvaranju robusnih AR aplikacija. 🚀

Prilagodba položaja virtualnog objekta u AR-u s Unityjem i MediaPipeom

Rješenje 1: Korištenje Unityjeve fizičke kamere za podešavanje vidnog polja i izobličenja objektiva

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Istraživanje alternativnih prilagodbi za virtualno poravnanje glave

Rješenje 2: Korištenje prilagođenog shadera za ispravljanje izobličenja leće

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testiranje poboljšane kompatibilnosti u Unityjevim AR projektima

Rješenje 3: Implementacija jediničnih testova za virtualno poravnanje glave

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Pročišćavanje AR položaja kroz poboljšane tehnike kalibracije

Jedan često zanemaren aspekt problema s AR poravnanjem je važnost kalibracije kamere. U AR projektima poput postavljanja virtualne glave iznad stvarne, leće intrinzični parametri igraju vitalnu ulogu. Ovi parametri uključuju žarišnu duljinu, optičko središte i koeficijente izobličenja. Kad te vrijednosti nisu točne, virtualna glava može izgledati neporavnata ili iskrivljena. Kako bi se to riješilo, alati za kalibraciju mogu se koristiti za izračunavanje ovih parametara za kameru određenog uređaja. Na primjer, softver poput OpenCV nudi robusne alate za kalibraciju za generiranje preciznih matrica kamere i profila izobličenja. 📐

Drugi pristup uključuje korištenje Unityja stog za naknadnu obradu. Primjenom efekata poput dubinske oštrine ili korekcije kromatske aberacije, možete izgladiti razlike između prikazane virtualne glave i okoline u stvarnom svijetu. Naknadna obrada dodaje sloj poliranja koji premošćuje jaz između virtualnih objekata i fizičkih prostora. Na primjer, suptilni efekt zamućenja može smanjiti oštre rubove koji čine neusklađenosti vidljivima. Ovo je posebno korisno u aplikacijama koje uživljavaju u prostor gdje su korisnici jako usredotočeni na scenu.

Konačno, ne podcjenjujte snagu dinamičke prilagodbe tijekom rada. Uključivanje modela strojnog učenja u vaš AR cjevovod može omogućiti sustavu da nauči i prilagodi položaj tijekom vremena. Na primjer, model umjetne inteligencije mogao bi analizirati povratne informacije korisnika ili otkrivene nedosljednosti i dinamički fino podešavati usklađivanje. To čini sustav robusnijim i sposobnijim da se nosi s varijacijama u osvjetljenju, performansama uređaja ili ponašanju korisnika. Ova poboljšanja osiguravaju besprijekorno AR iskustvo, čineći virtualni i stvarni svijet doista integriranim. 🚀

Uobičajena pitanja o postavljanju MediaPipe i Unity AR

- Zašto moja virtualna glava nije poravnata sa stvarnim licem?

- Problem često proizlazi iz nepravilne kalibracije kamere. Korištenje alata kao što je OpenCV za izračun camera matrix i distortion coefficients može uvelike poboljšati poravnanje.

- Koja je uloga žarišne duljine u AR poravnanju?

- The focal length definira kako kamera projicira 3D točke na 2D ravninu. Podešavanje u postavkama fizičke kamere Unityja može povećati točnost.

- Može li Unity riješiti ispravljanje izobličenja leće?

- Da, Unity podržava shadere za ispravljanje izobličenja. Implementirajte shader sa svojstvima poput _DistortionStrength za prilagodbu korekcija na temelju vašeg profila objektiva.

- Kako mogu testirati poravnanje virtualnih objekata?

- Korištenje jediničnih testova u NUnit s naredbama poput Assert.AreEqual omogućuje provjeru pozicioniranja i rotacije virtualnih objekata pod različitim uvjetima.

- Je li naknadna obrada potrebna za AR projekte?

- Iako nije obavezno, efekti naknadne obrade poput depth of field i chromatic aberration može poboljšati vizualnu kvalitetu i realizam AR scena.

- Može li MediaPipe otkriti objekte koji nisu lica?

- Da, MediaPipe nudi rješenja za ruke, pozu, pa čak i holističko praćenje, što ga čini svestranim za različite slučajeve upotrebe AR-a.

- Koji hardver najbolje funkcionira za Unity AR aplikacije?

- Idealni su uređaji s grafičkim procesorima visokih performansi i preciznim kamerama. Alati poput ARCore i ARKit dodatno poboljšati kompatibilnost.

- Zašto je poravnanje lošije pod određenim kutovima?

- To bi moglo biti zbog neusklađenosti u vidnom polju između kamere i virtualnog okruženja. Podešavanje Unity kamera fieldOfView vlasništvo može pomoći.

- Kako shaderi poboljšavaju AR poravnanje?

- Shaderi omogućuju prilagodbe renderiranja u stvarnom vremenu, poput ispravljanja izobličenja ili simuliranja efekata leće, osiguravajući bolju sinkronizaciju između virtualnih i stvarnih objekata.

- Mogu li se AR sustavi sami prilagoditi tijekom vremena?

- Da, integracija modela strojnog učenja omogućuje sustavima dinamičku prilagodbu, učenje iz povratnih informacija kako bi se poboljšalo usklađivanje i izvedba tijekom vremena.

Poboljšanje AR točnosti: Završne misli

Postizanje precizne usklađenosti između virtualnih i stvarnih objekata ključno je za impresivna AR iskustva. Pažljivom kalibracijom i naprednim tehnikama mogu se ublažiti problemi poput izobličenja leće i neusklađenih žarišnih duljina, čime se osigurava bolja točnost i zadovoljstvo korisnika.

Integracija Unityjevih alata, MediaPipe algoritama i dinamičkih prilagodbi nudi robusna rješenja za AR programere. Ova poboljšanja omogućuju besprijekoran spoj digitalnog i fizičkog svijeta, otključavajući nove mogućnosti za igranje, virtualne sastanke i više od toga. Uz upornost i inovativnost, izazovi usklađivanja AR-a postaju savladivi. 🚀

Izvori i reference

- Pojedinosti o korištenju MediaPipe-a u Unityju navedene su u službenoj dokumentaciji MediaPipe-a. Istraži to ovdje .

- Smjernice o kalibraciji Unityjeve kamere i fizičkim svojstvima mogu se pronaći na Unity dokumentacijskom mjestu. Posjetiti Postavke Unity kamere za više detalja.

- Programiranje shadera za AR aplikacije i ispravljanje izobličenja leće inspirirano je člancima o razvoju shadera, poput onih na Mačkasto kodiranje .

- Mogućnosti i ograničenja ARCorea za razvoj Androida pregledani su na Googleovoj web stranici za razvojne programere ARCore. Saznajte više na Google ARCore .