Daniel Marino

25 studenoga 2024

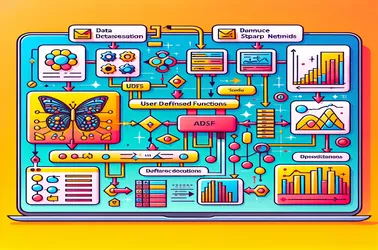

Rješavanje problema SparkContexta s korištenjem UDF-ova za Apache Spark za ekstrakciju značajki slike

Pri korištenju UDF-ova unutar Apache Sparka za distribuirane operacije kao što je obrada modela dubokog učenja, uobičajeno je naići na Sparkov problem "SparkContext se može koristiti samo na upravljačkom programu". To se događa zbog stroge prirode SparkContexta vezane uz upravljački program, koji kontrolira raspodjelu poslova. Sprječavanjem sukoba serijalizacije u distribuiranim cjevovodima obrade slike i jamčenjem pristupa modelu bez ponovne inicijalizacije na svakom čvoru, rješenja kao što su varijable emitiranja omogućuju nam dijeljenje modela s radnim čvorovima u učinkovit način. Sparkov kapacitet za rješavanje zamršenih zadataka strojnog učenja na razini znatno je poboljšan pristupima emitiranja.