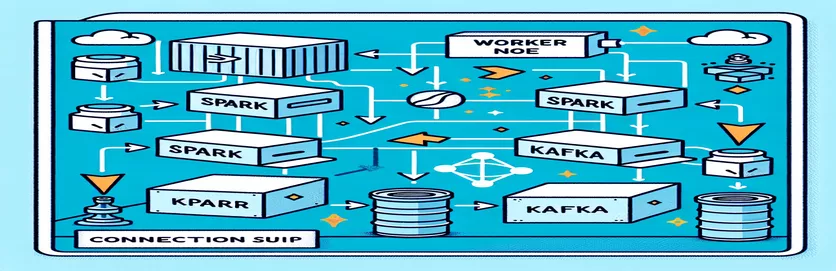

ડોકરાઇઝ્ડ એન્વાયર્નમેન્ટમાં સ્પાર્ક અને કાફકાને એકીકૃત કરવાના પડકારો

એકીકૃત કરતી વખતે તમે ક્યારેય કનેક્ટિવિટી સમસ્યાનો સામનો કર્યો છે કાફકા બ્રોકર માં સ્પાર્ક ક્લસ્ટર ડોકર સેટઅપની અંદર? તમે એકલા નથી! આ બે શક્તિશાળી સાધનો વચ્ચે સંચાર ગોઠવતી વખતે ઘણા વિકાસકર્તાઓ અવરોધોનો સામનો કરે છે. 🛠️

તાજેતરમાં, મેં મારામાં વધારો કરવાનું શરૂ કર્યું સ્પાર્ક ક્લસ્ટર રીઅલ-ટાઇમ ડેટા પ્રોસેસિંગને સુવ્યવસ્થિત કરવા માટે કાફકા બ્રોકર ઉમેરીને. જો કે, મેં સતત કનેક્શન સમયસમાપ્તિ અને DNS રિઝોલ્યુશન ભૂલો સાથે રોડ બ્લોકને હિટ કર્યો, જેણે પ્રક્રિયાને મુશ્કેલીનિવારણ મેરેથોનમાં ફેરવી. 😅

આ મુદ્દાઓ ડોકર કમ્પોઝ અને સ્પાર્કના કાફકા-સંબંધિત રૂપરેખાંકનોમાં ખોટી ગોઠવણી કરેલ સેટિંગ્સને કારણે ઉદ્ભવ્યા છે. ઘણા માર્ગદર્શિકાઓનું પાલન કરવા અને અસંખ્ય પરિમાણોને ટ્વિક કરવા છતાં, પ્રપંચી "બ્રોકર ઉપલબ્ધ ન હોઈ શકે" સંદેશ ચાલુ રહ્યો, જેનાથી મને મૂંઝવણ અને હતાશ થઈ ગયો.

આ લેખમાં, હું મારો અનુભવ શેર કરીશ અને ડોકર વાતાવરણમાં સ્પાર્ક વર્કર્સ અને કાફકા બ્રોકર્સ વચ્ચેના કનેક્ટિવિટી પડકારોને ઉકેલવા માટે વ્યવહારુ પગલાં ઓફર કરીશ. રસ્તામાં, તમે આ મુશ્કેલીઓને ટાળવા અને સીમલેસ એકીકરણની ખાતરી કરવા માટેની ટીપ્સ અને યુક્તિઓ શીખી શકશો. ચાલો અંદર જઈએ! 🚀

| આદેશ | ઉપયોગનું ઉદાહરણ |

|---|---|

| from_json() | આ સ્પાર્ક SQL ફંક્શન JSON સ્ટ્રિંગને પાર્સ કરે છે અને સ્ટ્રક્ચર્ડ ડેટા ઑબ્જેક્ટ બનાવે છે. ઉદાહરણમાં, તેનો ઉપયોગ કાફકા સંદેશાઓને સ્ટ્રક્ચર્ડ ડેટામાં ડિસિરિયલાઇઝ કરવા માટે થાય છે. |

| StructType() | સ્ટ્રક્ચર્ડ ડેટા પ્રોસેસિંગ માટે સ્કીમા વ્યાખ્યાયિત કરે છે. તે ખાસ કરીને કાફકા સંદેશાઓના અપેક્ષિત ફોર્મેટને વ્યાખ્યાયિત કરવા માટે ઉપયોગી છે. |

| .readStream | સ્પાર્કમાં સ્ટ્રીમિંગ ડેટાફ્રેમ શરૂ કરે છે, જે કાફકા અથવા અન્ય સ્ટ્રીમિંગ સ્ત્રોતોમાંથી સતત ડેટા ઇન્જેશન માટે પરવાનગી આપે છે. |

| writeStream | સ્પાર્ક સ્ટ્રક્ચર્ડ સ્ટ્રીમિંગ ક્વેરી માટે આઉટપુટ મોડ અને સિંકને વ્યાખ્યાયિત કરે છે. અહીં, તે એપેન્ડ મોડમાં કન્સોલ પર લખવાનું સ્પષ્ટ કરે છે. |

| bootstrap_servers | કાફકા રૂપરેખાંકન પરિમાણ કે જે કાફકા બ્રોકરનું સરનામું સ્પષ્ટ કરે છે. સ્પાર્ક અને કાફકા સંચાર માટે મહત્વપૂર્ણ. |

| auto_offset_reset | એક કાફકા ગ્રાહક સેટિંગ જે નક્કી કરે છે કે જ્યારે કોઈ પૂર્વ ઑફસેટ અસ્તિત્વમાં ન હોય ત્યારે સંદેશા વાંચવાનું ક્યાંથી શરૂ કરવું. "સૌથી વહેલું" વિકલ્પ સૌથી જૂના સંદેશથી શરૂ થાય છે. |

| KAFKA_ADVERTISED_LISTENERS | ડોકર કાફ્કા રૂપરેખાંકન પર્યાવરણ ચલ. તે ડોકર નેટવર્કની અંદર અને બહાર યોગ્ય સંચાર સુનિશ્ચિત કરીને કાફકા ક્લાયન્ટ્સ માટે જાહેરાત કરાયેલ સરનામાંનો ઉલ્લેખ કરે છે. |

| KAFKA_LISTENERS | નેટવર્ક ઇન્ટરફેસને ગોઠવે છે જેના પર કાફકા બ્રોકર ઇનકમિંગ કનેક્શન્સ માટે સાંભળે છે. આંતરિક અને બાહ્ય સંચારને અલગ કરવા માટે અહીં વપરાય છે. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | વિવિધ કાફકા શ્રોતાઓ માટે સુરક્ષા પ્રોટોકોલ વ્યાખ્યાયિત કરે છે. તે શ્રોતાઓના નામોને તેમના સંબંધિત પ્રોટોકોલમાં નકશા કરે છે, જેમ કે આ કિસ્સામાં PLAINTEXT. |

| .awaitTermination() | એક સ્પાર્ક સ્ટ્રક્ચર્ડ સ્ટ્રીમિંગ પદ્ધતિ કે જે સ્ટ્રીમિંગ ક્વેરી સમાપ્ત ન થાય ત્યાં સુધી સ્ક્રિપ્ટના અમલને અવરોધે છે, તે સુનિશ્ચિત કરે છે કે સ્ટ્રીમ સતત ચાલે છે. |

ડોકરમાં સ્પાર્ક અને કાફકા એકીકરણને સમજવું

પ્રથમ સ્ક્રિપ્ટ એ વચ્ચે જોડાણ સ્થાપિત કરવા પર ધ્યાન કેન્દ્રિત કરે છે સ્પાર્ક વર્કર અને એ કાફકા બ્રોકર. સ્પાર્કના સ્ટ્રક્ચર્ડ સ્ટ્રીમિંગ API નો ઉપયોગ કરીને, સ્ક્રિપ્ટ કાફકા વિષયમાંથી રીઅલ-ટાઇમ ડેટા વાંચે છે. તે સ્પાર્ક સત્રને શરૂ કરીને અને તેને જરૂરી કાફકા પેકેજ સાથે ગોઠવવાથી શરૂ થાય છે. આ નિર્ણાયક છે કારણ કે તે સ્પાર્કને કાફકા સાથે એકીકૃત રીતે વાતચીત કરવા માટે જરૂરી નિર્ભરતા પૂરી પાડે છે. આ નિર્ભરતાનું ઉદાહરણ `org.apache.spark:spark-sql-kafka` પેકેજ છે, જે ડોકર વાતાવરણમાં સ્પાર્ક અને કાફકા વચ્ચે સુસંગતતા સુનિશ્ચિત કરે છે.

કાફકા સંદેશાઓને હેન્ડલ કરવા માટે, સ્ક્રિપ્ટ `સ્ટ્રક્ટ ટાઈપ` નો ઉપયોગ કરીને સ્કીમા વ્યાખ્યાયિત કરે છે. આ સ્કીમા ખાતરી કરે છે કે આવનારા સંદેશાઓ યોગ્ય રીતે વિશ્લેષિત અને સંરચિત છે. વાસ્તવિક દુનિયાના દૃશ્યોમાં ઘણીવાર કાફકાના JSON ડેટાને હેન્ડલ કરવામાં આવે છે. દાખલા તરીકે, એક ક્રિપ્ટોકરન્સી મોનિટરિંગ સિસ્ટમની કલ્પના કરો જ્યાં ભાવ અપડેટ્સ ધરાવતા સંદેશા કાફકાને મોકલવામાં આવે છે. આ સંદેશાઓને વાંચી શકાય તેવા ફોર્મેટમાં વિશ્લેષિત કરવાથી વલણની આગાહી માટે ડેટાની પ્રક્રિયા અને વિશ્લેષણ કરવાનું સરળ બને છે. 🪙

ડોકર કમ્પોઝ કન્ફિગરેશન કનેક્ટિવિટી સમસ્યાઓના નિરાકરણમાં મુખ્ય ભૂમિકા ભજવે છે. `KAFKA_ADVERTISED_LISTENERS` અને `KAFKA_LISTENERS` સેટિંગ્સ ડોકર નેટવર્કમાં આંતરિક અને બાહ્ય સંચારને અલગ પાડવા માટે ગોઠવવામાં આવી છે. આ સુનિશ્ચિત કરે છે કે સમાન ડોકર નેટવર્ક પર ચાલતી સેવાઓ, જેમ કે સ્પાર્ક અને કાફકા, DNS રિઝોલ્યુશન સમસ્યાઓ વિના ક્રિયાપ્રતિક્રિયા કરી શકે છે. ઉદાહરણ તરીકે, મેપિંગ `INSIDE://kafka:9093` આંતરિક કન્ટેનરને કાફકાને ઍક્સેસ કરવાની મંજૂરી આપે છે, જ્યારે `OUTSIDE://localhost:9093` બાહ્ય એપ્લિકેશનને મોનિટરિંગ ટૂલ્સને કનેક્ટ કરવા સક્ષમ કરે છે.

બીજી સ્ક્રિપ્ટ દર્શાવે છે કે કાફકા કનેક્શનને ચકાસવા માટે પાયથોન `કાફ્કા કન્ઝ્યુમર` નો ઉપયોગ કેવી રીતે કરવો. કાફકા બ્રોકર યોગ્ય રીતે કાર્ય કરી રહ્યું છે તેની ખાતરી કરવા માટે આ એક સરળ છતાં અસરકારક અભિગમ છે. ઉલ્લેખિત વિષયના સંદેશાઓનો ઉપયોગ કરીને, તમે ચકાસી શકો છો કે શું ડેટા પ્રવાહ અવિરત છે. એક એપ્લિકેશનનો વિચાર કરો જ્યાં વપરાશકર્તા સ્ટોક માર્કેટ ડેટાને ટ્રૅક કરવા માંગે છે. આ કન્ઝ્યુમર સ્ક્રિપ્ટનો ઉપયોગ કરીને કનેક્શનનું પરીક્ષણ કરવું એ સુનિશ્ચિત કરે છે કે રૂપરેખાંકન ભૂલોને કારણે કોઈ જટિલ અપડેટ્સ ચૂકી ન જાય. આ સાધનો વડે, તમે વિશ્વાસપૂર્વક રીઅલ-ટાઇમ ડેટા પ્રોસેસિંગ માટે મજબૂત સિસ્ટમો જમાવી શકો છો! 🚀

સ્પાર્ક વર્કર અને કાફકા બ્રોકર વચ્ચે કનેક્ટિવિટી મુદ્દાઓનું સંચાલન

ઉકેલ 1: ડોકર સાથે સ્પાર્ક અને કાફકામાં ડિબગીંગ અને કનેક્શન સમસ્યાઓ ઉકેલવા માટે પાયથોનનો ઉપયોગ કરવો

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

ડોકરાઇઝ્ડ કાફકામાં ડીએનએસ રિઝોલ્યુશન ઇશ્યૂ ડિબગ કરવું

ઉકેલ 2: યોગ્ય DNS રિઝોલ્યુશન માટે ડોકર કમ્પોઝ કન્ફિગરેશનમાં ફેરફાર કરી રહ્યા છીએ

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

કાફકા કન્ઝ્યુમર કનેક્શનનું પરીક્ષણ

ઉકેલ 3: કનેક્શન ચકાસવા માટે પાયથોન કાફકા ઉપભોક્તા

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

ડોકરાઇઝ્ડ એન્વાયર્નમેન્ટમાં કાફકા અને સ્પાર્કનું ઑપ્ટિમાઇઝિંગ

વચ્ચે સરળ સંચાર સુનિશ્ચિત કરવા માટેનું એક મહત્વપૂર્ણ પાસું કાફકા બ્રોકર્સ અને સ્પાર્ક કામદારો ડોકરમાં નેટવર્ક સેટિંગ્સને અસરકારક રીતે ગોઠવી રહ્યું છે. ડોકર કન્ટેનર અલગ વાતાવરણમાં કાર્ય કરે છે, જ્યારે સેવાઓને ક્રિયાપ્રતિક્રિયા કરવાની જરૂર હોય ત્યારે ઘણી વખત DNS રિઝોલ્યુશન સમસ્યાઓનું કારણ બને છે. આને સંબોધવા માટે, તમે ડોકર કમ્પોઝના નેટવર્ક રૂપરેખાંકન વિકલ્પોનો લાભ લઈ શકો છો. દાખલા તરીકે, `my_network` જેવા કસ્ટમ નેટવર્કને વ્યાખ્યાયિત કરવું અને સેવાઓને લિંક કરવી એ સુનિશ્ચિત કરે છે કે કન્ટેનર એકબીજાને IP કરતાં નામથી ઓળખે છે, જે સેટઅપને સરળ બનાવે છે અને સામાન્ય મુશ્કેલીઓ ટાળે છે.

અન્ય આવશ્યક વિચારણા એ કાફકાના શ્રોતા રૂપરેખાંકનોને ઑપ્ટિમાઇઝ કરવાનું છે. તમારી ડોકર કમ્પોઝ ફાઇલમાં `KAFKA_ADVERTISED_LISTENERS` અને `KAFKA_LISTENERS` નો ઉલ્લેખ કરીને, તમે કાફ્કાને તેના ગ્રાહકોને યોગ્ય સરનામાંની જાહેરાત કરવાની મંજૂરી આપો છો. આંતરિક અને બાહ્ય શ્રોતાઓ વચ્ચેનો આ તફાવત તકરારને ઉકેલે છે, ખાસ કરીને જ્યારે સ્પાર્ક વર્કર્સ ડોકર નેટવર્કની બહારથી કનેક્ટ થવાનો પ્રયાસ કરે છે. આનું વાસ્તવિક જીવનનું ઉદાહરણ મોનિટરિંગ ડેશબોર્ડ છે જે હોસ્ટ મશીનમાંથી કાફકા ડેટાની ક્વેરી કરે છે, જેમાં એક્સેસ માટે એક અલગ બાહ્ય શ્રોતાની જરૂર હોય છે. 🔧

છેલ્લે, તમારી સ્પાર્ક એપ્લિકેશન્સમાં મજબૂત ભૂલ હેન્ડલિંગને અમલમાં મૂકવું મહત્વપૂર્ણ છે. ઉદાહરણ તરીકે, કાફકા રૂપરેખાંકનની અંદર પુનઃપ્રયાસો અને ફોલબેકનો લાભ લેવાથી અસ્થાયી કનેક્ટિવિટી સમસ્યાઓને સુંદર રીતે હેન્ડલ કરી શકાય છે. `.option("kafka.consumer.max.poll.records", "500")` ઉમેરવાથી ભારે ભારણ હેઠળ પણ કાર્યક્ષમ ડેટા પુનઃપ્રાપ્તિ સુનિશ્ચિત થાય છે. રીઅલ-ટાઇમમાં સ્ટોકના ભાવને ટ્રૅક કરતી પ્રોડક્શન-ગ્રેડ એપ્લિકેશનની કલ્પના કરો - સ્થાને નિષ્ફળ-સલામત રાખવાથી નેટવર્ક હિચકી દરમિયાન પણ અવિરત ડેટા ફ્લો સુનિશ્ચિત થાય છે. આ તકનીકો એકસાથે વિશ્વસનીય ડેટા પ્રોસેસિંગ પાઇપલાઇનની કરોડરજ્જુ બનાવે છે. 🚀

ડોકરમાં સ્પાર્ક અને કાફકા વિશે સામાન્ય પ્રશ્નો

- નો હેતુ શું છે KAFKA_ADVERTISED_LISTENERS?

- તે ડોકર નેટવર્કની અંદર અને બહાર યોગ્ય સંચાર સુનિશ્ચિત કરીને કાફકા ક્લાયન્ટ્સને કનેક્ટ કરવા માટે જાહેરાત કરાયેલ સરનામાંનો ઉલ્લેખ કરે છે.

- તમે ડોકર કમ્પોઝમાં કસ્ટમ નેટવર્કને કેવી રીતે વ્યાખ્યાયિત કરશો?

- તમે હેઠળ નેટવર્ક ઉમેરી શકો છો networks કી અને તેને સેવાઓમાં સામેલ કરો, જેમ કે `networks: my_network`.

- શા માટે ડોકર કન્ટેનરમાં DNS રિઝોલ્યુશન નિષ્ફળ થાય છે?

- કન્ટેનર એકબીજાને નામથી ઓળખી શકતા નથી સિવાય કે તેઓ સમાન ડોકર નેટવર્કનો ભાગ હોય, જે તેમના DNSને લિંક કરે છે.

- ની ભૂમિકા શું છે .option("subscribe", "topic") સ્પાર્ક સ્ટ્રીમિંગમાં?

- તે રીઅલ-ટાઇમ ડેટા ઇન્જેશન માટે ઉલ્લેખિત કાફકા વિષય પર સ્પાર્ક સ્ટ્રક્ચર્ડ સ્ટ્રીમિંગ ડેટાફ્રેમને સબ્સ્ક્રાઇબ કરે છે.

- ફરીથી પ્રયાસો કાફકા-સ્પાર્ક એકીકરણને કેવી રીતે સુધારી શકે છે?

- રૂપરેખાંકનોમાં પુનઃપ્રયાસ કરે છે, જેમ કે max.poll.records, ક્ષણિક ભૂલોને હેન્ડલ કરવામાં અને સતત ડેટા પ્રોસેસિંગની ખાતરી કરવામાં મદદ કરે છે.

સ્પાર્ક અને કાફકા એકીકરણને સરળ બનાવવું

ડોકરમાં સ્પાર્ક અને કાફકાનું સેટઅપ જટિલ હોઈ શકે છે, પરંતુ યોગ્ય રૂપરેખાંકનો સાથે, તે વ્યવસ્થિત બને છે. કનેક્ટિવિટી સમસ્યાઓ ટાળવા માટે શ્રોતા સેટિંગ્સ અને નેટવર્ક ગોઠવણી પર ધ્યાન કેન્દ્રિત કરો. શ્રેષ્ઠ કામગીરી માટે ઝૂકીપર અને કાફકા જેવા તમામ ઘટકો સારી રીતે સમન્વયિત છે તેની ખાતરી કરો.

વાસ્તવિક વિશ્વના ઉપયોગના કેસ, જેમ કે નાણાકીય ડેટા અથવા IoT સ્ટ્રીમનું નિરીક્ષણ કરવું, મજબૂત ગોઠવણીના મહત્વને પ્રકાશિત કરે છે. અહીં શેર કરાયેલા સાધનો અને સ્ક્રિપ્ટો તમને સામાન્ય અવરોધોને દૂર કરવા અને કાર્યક્ષમ, રીઅલ-ટાઇમ ડેટા પાઇપલાઇન્સ બનાવવા માટેના જ્ઞાનથી સજ્જ કરે છે. 🛠️

સ્ત્રોતો અને સંદર્ભો

- આ લેખ અધિકારી દ્વારા માહિતી આપવામાં આવી હતી અપાચે સ્પાર્ક કાફકા એકીકરણ દસ્તાવેજીકરણ , રૂપરેખાંકન અને વપરાશમાં વિગતવાર આંતરદૃષ્ટિ પ્રદાન કરે છે.

- ડોકર નેટવર્કીંગ શ્રેષ્ઠ પ્રેક્ટિસનો સંદર્ભ આપવામાં આવ્યો હતો ડોકર નેટવર્કિંગ દસ્તાવેજીકરણ ચોક્કસ અને વિશ્વસનીય કન્ટેનર કમ્યુનિકેશન સેટઅપની ખાતરી કરવા.

- પ્રાયોગિક ઉદાહરણો અને વધારાના કાફકા સેટિંગ્સ માંથી સ્વીકારવામાં આવ્યા હતા Wurstmeister Kafka Docker GitHub રીપોઝીટરી .