Desafíos en la colocación de cabezales virtuales para el desarrollo de AR

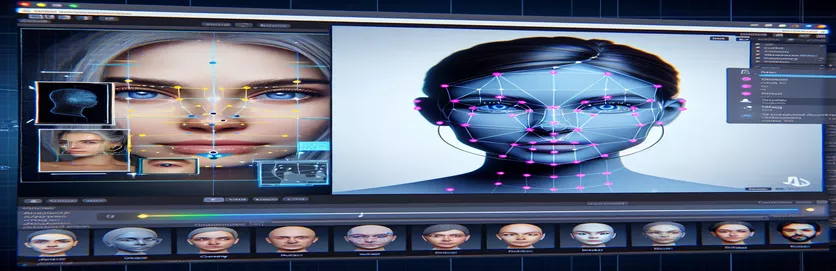

Trabajar en un proyecto de realidad aumentada (AR) puede ser a la vez emocionante y desafiante. Al desarrollar una aplicación de Android con Unity, mi objetivo era combinar los mundos digital y real a la perfección colocando una cabeza virtual sobre caras del mundo real. Esta característica depende en gran medida de la precisión para crear una experiencia inmersiva. 🕶️

Para lograr esto, utilicé MediaPipe de Google para detectar puntos de referencia faciales como ojos, narices y bocas. Luego se generó y colocó la cabeza virtual en función de estos puntos clave. Fue fascinante ver cómo las herramientas modernas podían transformar las posibilidades de la RA, pero el viaje estuvo lejos de ser perfecto.

El problema surgió cuando la cabeza virtual no se alineaba con la cara real como se esperaba. No importa el ángulo o el dispositivo, la ubicación siempre fue un poco "desviada", lo que generaba un efecto antinatural. Era como si la representación virtual estuviera desconectada de la realidad. Esto provocó una serie de experimentos de solución de problemas.

Desde modificar la configuración de la cámara de Unity hasta experimentar con el algoritmo de MediaPipe, cada intento generó mejoras incrementales, pero ninguna solución definitiva. Este artículo profundiza en el núcleo del problema, las lecciones aprendidas y las posibles soluciones para los desarrolladores que enfrentan desafíos similares. 🚀

| Dominio | Ejemplo de uso |

|---|---|

| mainCamera.usePhysicalProperties | Este comando permite el uso de las propiedades físicas de la cámara de Unity, lo que permite un control más preciso sobre la distancia focal y la distorsión de la lente para alinear objetos virtuales y del mundo real. |

| faceMesh.GetDetectedFaceTransform() | Recupera los datos de transformación (posición y rotación) de una cara detectada de la malla de caras de MediaPipe, crucial para colocar cabezas virtuales con precisión sobre caras reales. |

| UnityObjectToClipPos | Una función específica del sombreador que transforma la posición de un vértice del espacio del objeto al espacio del clip, utilizada en los sombreadores de corrección de distorsión de la lente para garantizar la alineación. |

| tex2D | Un comando de sombreado utilizado para muestrear una textura en coordenadas UV específicas, esencial para aplicar corrección de distorsión a las transmisiones de la cámara. |

| length(distUV) | Calcula la distancia euclidiana de las coordenadas UV desde el origen, que se aprovecha para aplicar ajustes graduales de distorsión de la lente. |

| adjuster.virtualHead | Una variable de script que hace referencia al GameObject de cabeza virtual, lo que permite actualizar dinámicamente su posición y rotación en función de los datos de seguimiento de rostros. |

| [TestFixture] | Un atributo NUnit que marca una clase como dispositivo de prueba, lo que indica que contiene pruebas unitarias. Esto es útil para verificar la lógica de alineación del cabezal virtual. |

| Assert.AreEqual | Un método NUnit utilizado para comparar los valores esperados y reales durante las pruebas unitarias, garantizando que la ubicación del cabezal virtual coincida con los resultados deseados. |

| _DistortionStrength | Una propiedad de sombreado que ajusta la intensidad de la distorsión de la lente, afinando la alineación entre el mundo real y el virtual. |

| Quaternion.Euler | Crea una rotación basada en ángulos de Euler, comúnmente utilizados para alinear objetos como la cabeza virtual en el espacio 3D de Unity. |

Mejora de la precisión de AR con Unity y MediaPipe

El primer guión que exploramos se centra en el uso de las propiedades físicas de la cámara de Unity. Al habilitar utilizar propiedades físicas, ajustamos el comportamiento de la cámara para que se ajuste más a la óptica del mundo real. Esto es particularmente importante cuando se trabaja con AR, donde incluso ligeras discrepancias en la distancia focal o el campo de visión pueden hacer que los objetos virtuales parezcan desalineados. Por ejemplo, establecer la distancia focal en un valor preciso como 35 mm puede ayudar a alinear la cabeza virtual con el rostro detectado. Este ajuste es similar a ajustar un telescopio para enfocar perfectamente los objetos distantes, asegurando que la experiencia AR se sienta natural e inmersiva. 📸

Otro componente crucial del script es recuperar la posición y rotación de la cara detectada usando faceMesh.GetDetectedFaceTransform(). Esta función proporciona actualizaciones en tiempo real de la malla facial de MediaPipe, lo cual es esencial para sincronizar la cabeza virtual con los movimientos del usuario. Imagina jugar un videojuego en el que la cabeza de tu personaje no se mueve sincronizada con la tuya; la experiencia sería discordante. Al garantizar una alineación precisa, este script transforma la RA de una novedad a una herramienta que puede admitir aplicaciones como reuniones virtuales o juegos avanzados.

El segundo guión profundiza en la programación de sombreadores, abordando específicamente la distorsión de la lente. El sombreador corrige las distorsiones en la transmisión de la cámara, utilizando propiedades como _DistortionStrength para manipular cómo se asignan las coordenadas UV a la textura. Esto es particularmente útil cuando se trata de lentes gran angular o cámaras con perfiles de distorsión únicos. Por ejemplo, si una cabeza virtual parece más grande o más pequeña que la cara real según el ángulo, ajustar la configuración de distorsión garantiza una mejor alineación. Es como ajustar el marco de un espejo para eliminar el efecto de casa de risa, haciendo que los reflejos sean más realistas. 🎨

Finalmente, las pruebas unitarias del tercer script validan las soluciones. Estas pruebas comparan la posición esperada y la rotación de la cabeza virtual con los resultados reales, asegurando que los ajustes se mantengan en diversas condiciones. Usando NUnit Afirmar. Son iguales, los desarrolladores pueden simular diferentes escenarios, como mover la cabeza rápidamente o inclinarla en ángulos extremos, para confirmar la alineación. Por ejemplo, durante el desarrollo, noté que la alineación funcionaba bien cuando se miraba hacia adelante, pero se desviaba cuando la cabeza se giraba hacia un lado. Estas pruebas unitarias resaltaron el problema y guiaron mejoras adicionales, reforzando la importancia de realizar pruebas exhaustivas en la creación de aplicaciones AR sólidas. 🚀

Ajustar la ubicación de objetos virtuales en AR con Unity y MediaPipe

Solución 1: uso de la cámara física de Unity para ajustar el campo de visión y la distorsión de la lente

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Explorando ajustes alternativos para la alineación virtual de la cabeza

Solución 2: usar un sombreador personalizado para corregir la distorsión de la lente

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Pruebas de compatibilidad mejorada en proyectos AR de Unity

Solución 3: Implementación de pruebas unitarias para la alineación virtual de cabezales

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Refinamiento de la colocación de AR mediante técnicas de calibración mejoradas

Un aspecto que a menudo se pasa por alto en los problemas de alineación de AR es la importancia de la calibración de la cámara. En proyectos de AR, como colocar una cabeza virtual sobre una real, la lente parámetros intrínsecos jugar un papel vital. Estos parámetros incluyen la distancia focal, el centro óptico y los coeficientes de distorsión. Cuando estos valores no son precisos, la cabeza virtual puede aparecer desalineada o distorsionada. Para solucionar esto, se pueden utilizar herramientas de calibración para calcular estos parámetros para la cámara del dispositivo específico. Por ejemplo, software como OpenCV ofrece sólidas utilidades de calibración para generar matrices de cámara y perfiles de distorsión precisos. 📐

Otro enfoque implica aprovechar la capacidad de Unity pila de posprocesamiento. Al aplicar efectos como profundidad de campo o correcciones de aberración cromática, puede suavizar las discrepancias entre la cabeza virtual renderizada y el entorno del mundo real. El posprocesamiento agrega una capa de pulido que cierra la brecha entre los objetos virtuales y los espacios físicos. Por ejemplo, un efecto de desenfoque sutil puede reducir los bordes ásperos que hacen que las desalineaciones se noten. Esto es especialmente útil en aplicaciones inmersivas donde los usuarios están muy concentrados en la escena.

Por último, no subestime el poder de la adaptación dinámica durante el tiempo de ejecución. La incorporación de modelos de aprendizaje automático en su canal de AR puede permitir que el sistema aprenda y ajuste la ubicación con el tiempo. Por ejemplo, un modelo de IA podría analizar los comentarios de los usuarios o detectar inconsistencias y ajustar la alineación dinámicamente. Esto hace que el sistema sea más robusto y capaz de hacer frente a variaciones en la iluminación, el rendimiento del dispositivo o el comportamiento del usuario. Estas mejoras garantizan una experiencia de RA perfecta, haciendo que los mundos virtual y real se sientan verdaderamente integrados. 🚀

Preguntas comunes sobre la ubicación de MediaPipe y Unity AR

- ¿Por qué mi cabeza virtual está desalineada con la cara real?

- El problema suele deberse a una calibración inadecuada de la cámara. Usar herramientas como OpenCV para calcular el camera matrix y distortion coefficients puede mejorar enormemente la alineación.

- ¿Cuál es el papel de la distancia focal en la alineación AR?

- El focal length Define cómo la cámara proyecta puntos 3D en un plano 2D. Ajustarlo en la configuración de la cámara física de Unity puede mejorar la precisión.

- ¿Puede Unity manejar la corrección de la distorsión de la lente?

- Sí, Unity admite sombreadores para corregir la distorsión. Implementar un sombreador con propiedades como _DistortionStrength para personalizar las correcciones según el perfil de su lente.

- ¿Cómo puedo probar la alineación de objetos virtuales?

- Usando pruebas unitarias en NUnit con comandos como Assert.AreEqual le permite validar el posicionamiento y la rotación de objetos virtuales bajo diversas condiciones.

- ¿Es necesario el posprocesamiento para proyectos de AR?

- Si bien no son obligatorios, los efectos de posprocesamiento como depth of field y chromatic aberration puede mejorar la calidad visual y el realismo de las escenas AR.

- ¿Puede MediaPipe detectar objetos distintos de caras?

- Sí, MediaPipe ofrece soluciones para manos, poses e incluso seguimiento holístico, lo que lo hace versátil para diferentes casos de uso de AR.

- ¿Qué hardware funciona mejor para las aplicaciones Unity AR?

- Los dispositivos con GPU de alto rendimiento y cámaras precisas son ideales. Herramientas como ARCore y ARKit mejorar aún más la compatibilidad.

- ¿Por qué la alineación empeora en ciertos ángulos?

- Esto podría deberse a una falta de coincidencia en el campo de visión entre la cámara y el entorno virtual. Ajustar la cámara Unity fieldOfView la propiedad puede ayudar.

- ¿Cómo mejoran los sombreadores la alineación de AR?

- Los sombreadores permiten realizar ajustes en el renderizado en tiempo real, como corregir distorsiones o simular efectos de lentes, lo que garantiza una mejor sincronización entre los objetos virtuales y reales.

- ¿Pueden los sistemas AR autoajustarse con el tiempo?

- Sí, la integración de modelos de aprendizaje automático permite que los sistemas se adapten dinámicamente, aprendiendo de la retroalimentación para mejorar la alineación y el rendimiento con el tiempo.

Mejora de la precisión de la RA: reflexiones finales

Lograr una alineación precisa entre los objetos virtuales y del mundo real es crucial para las experiencias inmersivas de RA. Mediante una calibración cuidadosa y técnicas avanzadas, se pueden mitigar problemas como la distorsión de la lente y las distancias focales no coincidentes, lo que garantiza una mayor precisión y satisfacción del usuario.

La integración de las herramientas de Unity, los algoritmos de MediaPipe y los ajustes dinámicos ofrece soluciones sólidas para los desarrolladores de AR. Estas mejoras permiten una combinación perfecta de mundos digitales y físicos, desbloqueando nuevas posibilidades para juegos, reuniones virtuales y más. Con persistencia e innovación, los desafíos de alineación de AR se vuelven manejables. 🚀

Fuentes y referencias

- Se hace referencia a los detalles sobre el uso de MediaPipe en Unity en la documentación oficial de MediaPipe. explorarlo aquí .

- Puede encontrar orientación sobre la calibración de la cámara y las propiedades físicas de Unity en el sitio de documentación de Unity. Visita Configuración de la cámara de unidad para más detalles.

- La programación de sombreadores para aplicaciones AR y corrección de distorsión de lentes se inspiró en artículos sobre el desarrollo de sombreadores, como los de Codificación felina .

- Las capacidades y limitaciones de ARCore para el desarrollo de Android se revisaron desde el sitio para desarrolladores ARCore de Google. Obtenga más información en Google ARCore .