Výzvy ve virtuálním umístění hlavy pro vývoj AR

Práce na projektu rozšířené reality (AR) může být vzrušující i náročná. Při vývoji aplikace pro Android s Unity jsem se snažil hladce prolnout digitální a skutečný svět umístěním virtuální hlavy na tváře skutečného světa. Tato funkce silně spoléhá na přesnost, aby vytvořila pohlcující zážitek. 🕶️

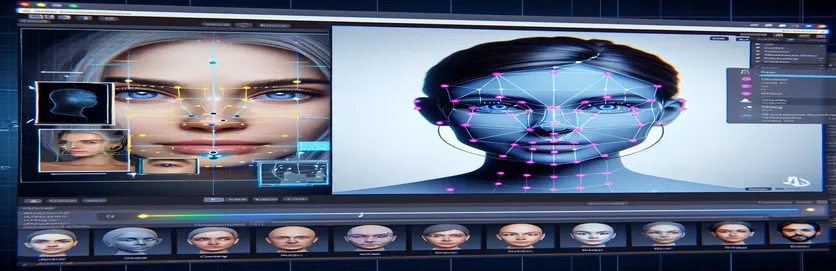

Abych toho dosáhl, použil jsem MediaPipe společnosti Google k detekci orientačních bodů na obličeji, jako jsou oči, nosy a ústa. Na základě těchto klíčových bodů byla poté vygenerována a umístěna virtuální hlava. Bylo fascinující vidět, jak moderní nástroje dokážou transformovat možnosti AR, ale cesta k dokonalosti měla daleko.

Problém se objevil, když se virtuální hlava nesrovnala se skutečnou tváří, jak se očekávalo. Bez ohledu na úhel nebo zařízení bylo umístění vždy trochu "mimo", což vedlo k nepřirozenému efektu. Jako by byla virtuální reprezentace odpojena od reality. To vyvolalo řadu experimentů s řešením problémů.

Od vyladění nastavení fotoaparátu Unity až po experimentování s algoritmem MediaPipe, každý pokus přinesl postupná vylepšení, ale žádné definitivní řešení. Tento článek se ponoří do jádra problému, poučení a potenciálních řešení pro vývojáře, kteří čelí podobným problémům. 🚀

| Příkaz | Příklad použití |

|---|---|

| mainCamera.usePhysicalProperties | Tento příkaz umožňuje použití fyzických vlastností kamery Unity, což umožňuje přesnější kontrolu nad ohniskovou vzdáleností a zkreslením objektivu pro zarovnání virtuálních a skutečných objektů. |

| faceMesh.GetDetectedFaceTransform() | Získává transformační data (polohu a rotaci) detekované tváře ze sítě MediaPipe, což je klíčové pro přesné umístění virtuálních hlav na skutečné tváře. |

| UnityObjectToClipPos | Funkce specifická pro shader, která transformuje polohu vrcholu z prostoru objektu do prostoru klipu, používaná v shaderech korekce zkreslení objektivu k zajištění zarovnání. |

| tex2D | Příkaz shaderu používaný k vzorkování textury na zadaných souřadnicích UV, který je nezbytný pro aplikaci korekce zkreslení na posuvy kamery. |

| length(distUV) | Vypočítá euklidovskou vzdálenost UV souřadnic od počátku, která se využívá k aplikaci postupných úprav zkreslení čočky. |

| adjuster.virtualHead | Proměnná skriptu odkazující na virtuální hlavu GameObject, která umožňuje dynamickou aktualizaci její polohy a rotace na základě dat ze sledování obličeje. |

| [TestFixture] | Atribut NUnit, který označuje třídu jako testovací přípravek, což signalizuje, že obsahuje testy jednotek. To je užitečné pro ověření logiky vyrovnání virtuální hlavy. |

| Assert.AreEqual | Metoda NUnit používaná k porovnání očekávaných a skutečných hodnot během testování jednotky, což zajišťuje, že umístění virtuální hlavy odpovídá požadovaným výsledkům. |

| _DistortionStrength | Vlastnost shaderu, která upravuje intenzitu zkreslení čočky a jemně dolaďuje zarovnání mezi skutečným a virtuálním světem. |

| Quaternion.Euler | Vytvoří rotaci na základě Eulerových úhlů, běžně používaných pro zarovnání objektů, jako je virtuální hlava, ve 3D prostoru Unity. |

Vylepšení přesnosti AR pomocí Unity a MediaPipe

První skript, který jsme prozkoumali, se zaměřuje na použití fyzických vlastností fotoaparátu Unity. Povolením použití fyzikálních vlastností, upravujeme chování fotoaparátu tak, aby lépe odpovídalo optice reálného světa. To je důležité zejména při práci s AR, kde i nepatrné rozdíly v ohniskové vzdálenosti nebo zorném poli mohou způsobit, že virtuální objekty vypadají špatně zarovnané. Například nastavení ohniskové vzdálenosti na přesnou hodnotu, jako je 35 mm, může pomoci zarovnat virtuální hlavu s detekovanou tváří. Tato úprava je podobná jemnému doladění dalekohledu, aby byly vzdálené objekty dokonale zaostřeny, což zajišťuje, že zážitek z AR bude přirozený a pohlcující. 📸

Další klíčovou součástí skriptu je načtení polohy a rotace detekované tváře pomocí faceMesh.GetDetectedFaceTransform(). Tato funkce poskytuje aktualizace v reálném čase z obličejové sítě MediaPipe, což je nezbytné pro synchronizaci virtuální hlavy s pohyby uživatele. Představte si, že hrajete videohru, kde se hlava vaší postavy nepohybuje synchronizovaně s tou vaší; zážitek by byl skličující. Zajištěním přesného zarovnání tento skript transformuje AR z novinky na nástroj, který může podporovat aplikace, jako jsou virtuální schůzky nebo pokročilé hraní.

Druhý skript se ponoří do programování shaderů, konkrétně se zabývá zkreslením čočky. Shader opravuje zkreslení v kanálu kamery pomocí vlastností jako _DistortionStrength k manipulaci s tím, jak jsou UV souřadnice mapovány na texturu. To je užitečné zejména při práci s širokoúhlými objektivy nebo fotoaparáty s jedinečnými profily zkreslení. Pokud se například virtuální hlava zdá větší nebo menší než skutečná tvář v závislosti na úhlu, vyladění nastavení zkreslení zajistí lepší zarovnání. Je to jako upravit rám zrcadla tak, aby se eliminoval efekt funhouse a odrazy byly realističtější. 🎨

Nakonec testy jednotek ze třetího skriptu ověří řešení. Tyto testy porovnávají očekávanou polohu a rotaci virtuální hlavy se skutečnými výsledky a zajišťují, že nastavení obstojí za různých podmínek. Pomocí NUnit's Assert.AreEqual, mohou vývojáři simulovat různé scénáře, jako je rychlý pohyb hlavy nebo její naklánění v extrémních úhlech, aby potvrdili zarovnání. Například během vývoje jsem si všiml, že zarovnání fungovalo dobře, když jsem čelil dopředu, ale driftovalo, když se hlava otočila na stranu. Tyto testy jednotky upozornily na problém a vedly k dalším vylepšením, čímž posílily důležitost důkladného testování při vytváření robustních aplikací AR. 🚀

Úprava umístění virtuálních objektů v AR pomocí Unity a MediaPipe

Řešení 1: Použití fyzické kamery Unity k úpravě FOV a zkreslení objektivu

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Zkoumání alternativních úprav pro vyrovnání virtuální hlavy

Řešení 2: Použití vlastního stínítka pro korekci zkreslení objektivu

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Testování vylepšené kompatibility v projektech AR společnosti Unity

Řešení 3: Implementace testů jednotek pro vyrovnání virtuální hlavy

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Zdokonalení umístění AR pomocí vylepšených technik kalibrace

Jedním z často přehlížených aspektů problémů se zarovnáním AR je důležitost kalibrace kamery. V projektech AR, jako je umístění virtuální hlavy nad skutečnou, objektivovou vnitřní parametry hrát zásadní roli. Tyto parametry zahrnují ohniskovou vzdálenost, optický střed a koeficienty zkreslení. Pokud tyto hodnoty nejsou přesné, může se virtuální hlava jevit jako nesprávně zarovnaná nebo zkreslená. K vyřešení tohoto problému lze použít kalibrační nástroje k výpočtu těchto parametrů pro konkrétní kameru zařízení. Například software jako OpenCV nabízí robustní kalibrační nástroje pro generování přesných kamerových matric a profilů zkreslení. 📐

Další přístup zahrnuje využití Unity's zásobník následného zpracování. Použitím efektů, jako je hloubka ostrosti nebo korekce chromatické aberace, můžete vyhladit nesrovnalosti mezi vykreslenou virtuální hlavou a skutečným prostředím. Následné zpracování přidává vrstvu lesku, která překlenuje propast mezi virtuálními objekty a fyzickými prostory. Jemný efekt rozostření může například snížit ostré okraje, díky nimž jsou patrná nesouosost. To je užitečné zejména v pohlcujících aplikacích, kde se uživatelé silně soustředí na scénu.

A konečně, nepodceňujte sílu dynamické adaptace za běhu. Začlenění modelů strojového učení do vašeho kanálu AR může systému umožnit učit se a upravovat umístění v průběhu času. Model AI by například mohl analyzovat zpětnou vazbu od uživatelů nebo detekovat nesrovnalosti a dynamicky doladit zarovnání. Díky tomu je systém robustnější a dokáže se vypořádat s odchylkami v osvětlení, výkonu zařízení nebo chování uživatelů. Tato vylepšení zajišťují bezproblémový zážitek z AR, díky čemuž se virtuální a skutečný svět cítí skutečně integrovaný. 🚀

Běžné otázky týkající se umístění MediaPipe a Unity AR

- Proč je moje virtuální hlava špatně zarovnaná se skutečnou tváří?

- Problém často pramení z nesprávné kalibrace fotoaparátu. Použití nástrojů jako OpenCV k výpočtu camera matrix a distortion coefficients může výrazně zlepšit zarovnání.

- Jakou roli hraje ohnisková vzdálenost při zarovnání AR?

- The focal length definuje, jak kamera promítá 3D body do 2D roviny. Jeho úpravou v nastavení fyzické kamery Unity můžete zvýšit přesnost.

- Dokáže Unity zvládnout korekci zkreslení objektivu?

- Ano, Unity podporuje shadery pro korekci zkreslení. Implementujte shader s vlastnostmi jako _DistortionStrength pro přizpůsobení korekcí na základě vašeho profilu objektivu.

- Jak mohu otestovat zarovnání virtuálních objektů?

- Použití unit testů v NUnit s příkazy jako Assert.AreEqual umožňuje ověřit umístění a rotaci virtuálních objektů za různých podmínek.

- Je pro projekty AR nutné následné zpracování?

- I když to není povinné, post-processing efekty jako depth of field a chromatic aberration může zlepšit vizuální kvalitu a realističnost scén AR.

- Dokáže MediaPipe detekovat jiné objekty než obličeje?

- Ano, MediaPipe nabízí řešení pro ruce, pózu a dokonce i holistické sledování, díky čemuž je univerzální pro různé případy použití AR.

- Jaký hardware funguje nejlépe pro aplikace Unity AR?

- Ideální jsou zařízení s vysoce výkonnými GPU a přesnými kamerami. Nástroje jako ARCore a ARKit dále zlepšit kompatibilitu.

- Proč je zarovnání v určitých úhlech horší?

- Může to být způsobeno nesouladem zorného pole mezi kamerou a virtuálním prostředím. Nastavení kamery Unity fieldOfView majetek může pomoci.

- Jak shadery zlepšují zarovnání AR?

- Shadery umožňují úpravy vykreslování v reálném čase, jako je korekce zkreslení nebo simulace efektů čočky, což zajišťuje lepší synchronizaci mezi virtuálními a skutečnými objekty.

- Mohou se systémy AR samy v průběhu času přizpůsobovat?

- Ano, integrace modelů strojového učení umožňuje systémům dynamicky se přizpůsobovat, učit se ze zpětné vazby, aby se zlepšilo sladění a výkon v průběhu času.

Zlepšení přesnosti AR: Závěrečné myšlenky

Dosažení přesného zarovnání mezi virtuálními a reálnými objekty je zásadní pro pohlcující zážitky v AR. Pečlivou kalibrací a pokročilými technikami lze zmírnit problémy, jako je zkreslení objektivu a neshodující se ohniskové vzdálenosti, a zajistit tak lepší přesnost a spokojenost uživatelů.

Integrace nástrojů Unity, algoritmů MediaPipe a dynamických úprav nabízí robustní řešení pro vývojáře AR. Tato vylepšení umožňují bezproblémové spojení digitálního a fyzického světa a odemykají nové možnosti pro hraní her, virtuální setkání a další. Díky vytrvalosti a inovacím se problémy se zarovnáním AR stávají zvládnutelnými. 🚀

Zdroje a odkazy

- Podrobnosti o používání MediaPipe v Unity byly uvedeny v oficiální dokumentaci MediaPipe. Prozkoumejte to zde .

- Pokyny ke kalibraci a fyzikálním vlastnostem kamery Unity lze nalézt na stránce dokumentace Unity. Návštěva Nastavení fotoaparátu Unity pro více podrobností.

- Programování shaderů pro aplikace AR a korekce zkreslení objektivu bylo inspirováno články o vývoji shaderů, jako jsou např Kočičí kódování .

- Možnosti a omezení ARCore pro vývoj Androidu byly přezkoumány z vývojářského webu ARCore společnosti Google. Více se dozvíte na Google ARCore .